AIDC(2)

巍卓铭诚

· 甘肃

AI要吃饭,吃的就是算力,而算力的背后,靠稳定、高效的电力撑着。

AIDC就是AI专属的数据中心,相当于AI时代的粮仓,而电气设备就是这个粮仓的输送管道和储备系统。电气设备跟不上,再强的GPU也发挥不了作用。

一、AIDC

1、为啥疯狂投钱

(1)AI市场

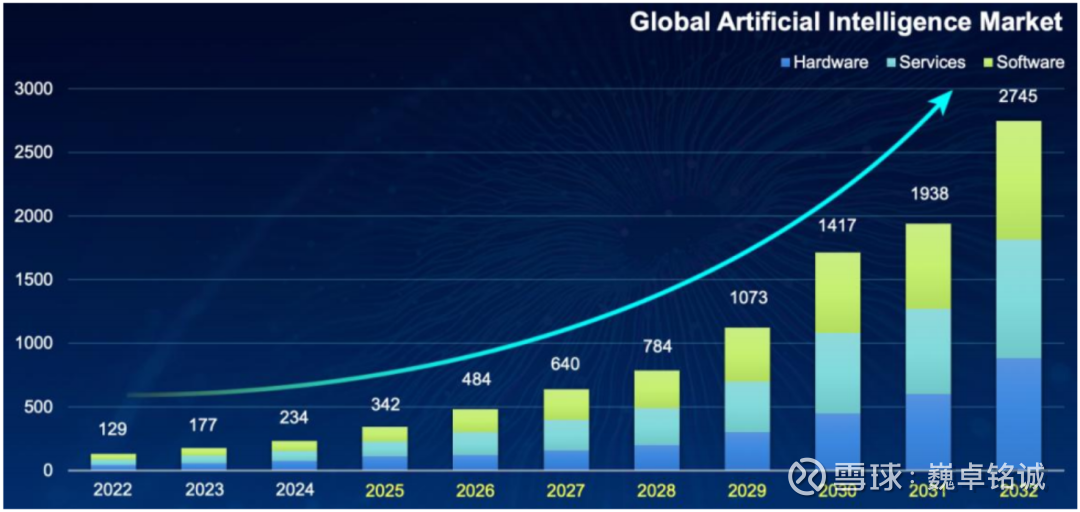

生成式AI出来后,全球AI市场规模涨得特别快。

根据IEA预测,2024年全球AI产业市场空间约234亿美元,到2032年能涨到2745亿美元,年均增速高达36%。

这么大的AI市场,得有足够的AIDC来支撑算力,不然大模型训练、AI推理都没法落地。

全球AI市场规模高速增长(2025-2032年为预测数据)

(2)云厂商和Colo

AI的主要使用者是云厂商,比如国内的阿里、腾讯,海外的亚马逊、微软,这些企业自然成了AIDC投资的主力军。

国内方面,阿里2024年资本开支同比涨了239%,还计划2025-2027年投3800亿建AI基础设施;

腾讯2024年

点击查看全文