从产业落地角度理解AI推理和AI存储

核心是理解AI 竞争从“卷模型”转到“卷推理体系”的逻辑。

过去几年:卷模型本身

大家都在比谁的模型参数更多、语料更大、能力更强。

这阶段的重点是突破认知和能力的上限,让模型更厉害。

成本、延迟、部署可行性都不是第一位考虑的。

现在:模型能力足够,应用落地遇到成本墙

一直重申的观点是,当下AI的边界逐步清晰,应用才是关键,谈应用,就必须要谈成本。

在真实场景(尤其是银行这种高并发、高实时)中,推理成本成了核心痛点:高端 GPU 占用贵,延迟高影响体验,大模型很多算力都浪费在处理简单、重复的部分,数据→模型→结果,这条链路上,存在大量不必要的全流程计算和资源浪费。

今天下午华为这个解决方案,大概是这样的,纯瞎猜版:

在AI推理链条上加入AI存储,此存储更强调架构,而不是储存卡。

先用便签(KV Cache 等缓存技术)记住简单、重复的历史信息,避免每次都从头算,把 GPU 算力集中在新输入、复杂计算上。简单任务走轻模型/低成本路径,就像柜台业务中,80%是存取款,不需要请总经理出马。复杂任务直通最强模型 + GPU,保证复杂问题有足够的算力支持和低延迟响应。数据从存储到 GPU 尽量直达,减少搬运、等待和拷贝。软硬件协同调度,框架(MindSpore)+ 底层加速(CANN)配合,动态分配任务、批量调度,稳定尾延迟。

这也符合华为官网,OceanStor的介绍。

我的评价:每个东西都不是全新的,不是在发布一个更大的模型或单一硬件,更像是一个融合系统,这个系统可以更低成本的推进AI应用落地,算是AI在产业落地的一大步。

更低成本非常重要,就像电车普及中,更便宜非常重要。

我让GPT帮我想了个通俗易懂的产业举例:

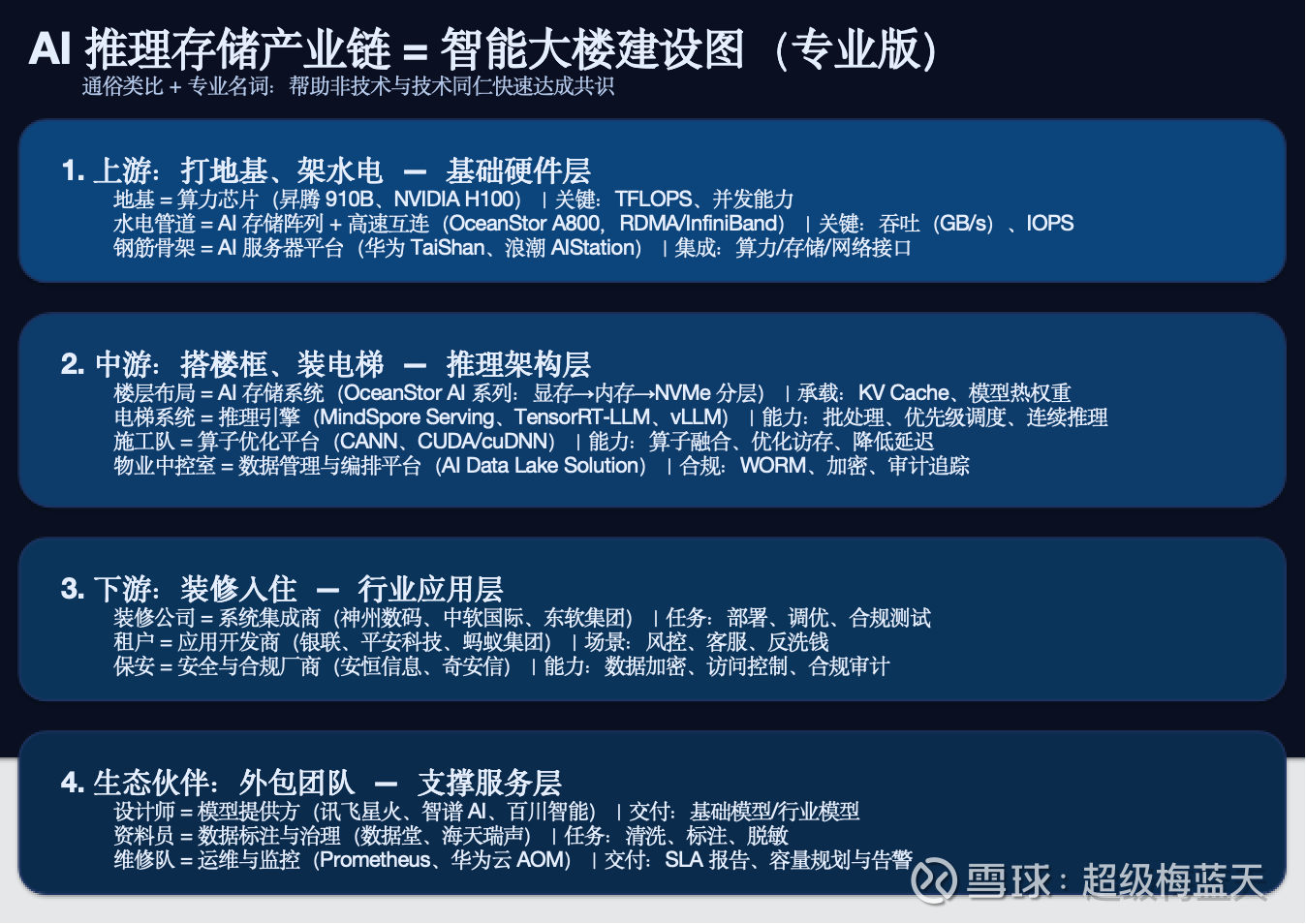

图片提及的公司没有验证,仅作为参考使用

以前,像厨师在家做菜,每来一单都从零洗菜、切菜、炒菜,慢、贵、菜炒的好吃,但成本很高。

现在,就像在中央厨房把常用的半成品和调料放在手边:简单菜直接端,复杂菜才现做。结果就是出菜快了、成本低了、客人多了,厨师(GPU)也不再闲着等料。

这样的架构像产业层面的 Agent。

所以在这个节点上,再高看一眼AI存储OceanStor,看多中亦科技,既有经销商又有技术协同的。

利益披露:持有$中亦科技(SZ301208)$