2026 CES演讲 要点

1、Nvidia Vera Rubin/VR200 NVL72重点更新,整合我的最新产业调查与Nvidia CEO黄仁勋的2026 CES演讲

(1)Nvidia将AI服务器VR200 NVL144 (die-based) 改名为VR200 NVL72 (package-based)。我的调查指出,VR200 NVL72将分为Max Q与Max P两种power profile。

-黄仁勋提到了NVL72,而非先前的NVL144

-Max Q与Max P硬件设计相同

-Max Q GPU/机柜功耗 (TGP/TDP):约1.8/190 (kW)

-Max P GPU/机柜功耗 (TGP/TDP):约2.3/230 (kW)

-两者均显著高于GB300 NVL72的1.4/140 (kW)

-因应资料中心供电规格,不同power profile提升安装弹性。此改变也意味着Nvidia开始注意到物理世界对建置AI服务器的限制,并将其反映在产品规格上

(2)VR200 NVL72 Max Q与Max P的GPU散热设计升级。

- 两者均采用微通道冷板 (micro-channel cold plate;MCCP) 搭配镀金散热盖 (gold-plated lid)

-市场高度期待GPU TGP达2.3kW后开始采用微通道盖板 (micro-channel lid;MCL),但MCL最快需至2H27才会量产

(3)受益于GPU、HBM与NVLink Switch规格升级,VR200 NVL72的AI训练/推理算力约是GB300 NVL72的3.5/5倍,机柜的供电也因此大幅提升。

-VR200 NVL72的power shelf升级到3*3U 110kW (6×18.3kW PSU) (vs. GB300 NVL72最普遍的8*1U 33kW (6×5.5kW PSU))

- VR200 NVL72 power shelf采3+1备份设计

-VR200 NVL72的电力进线 (power whip) 提升到100A (vs. GB300 NVL72的60A),这对资料中心供电要求更高 (如母线 (busway) 与插接箱 (tap-off box) 等设计)。

(4)VR200 NVL72的散热设计更依赖液冷方案。

- Compute & NVSwitch tray均采用无风扇设计 (fanless)

-机柜冷却液流量 (TCS flow) 几乎增加100% (vs. GB300 NVL72),有利CDU、分歧管、水冷板与QD规格与/或数量升级

-机柜风量 (Air flow) 需求则降低约80% (以CFM计) (vs. GB300 NVL72)。

(5)VR200 NVL72的Compute tray首度采用midplane,落实无线设计 (cableless)。

-Midplane关键规格包括:44层 (22+22)、M9 CCL (EM896K3)、尺寸约420*60 (mm)。

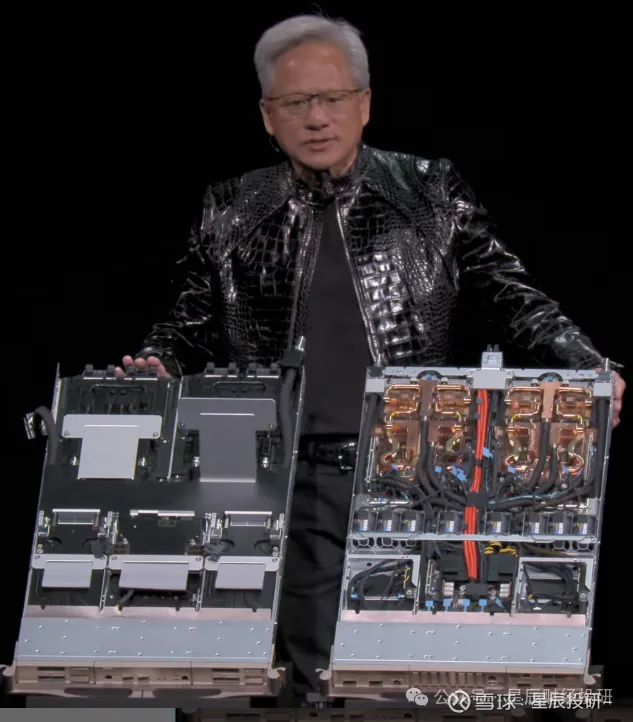

-黄仁勋提到,受益于此设计,Compute tray的组装时间可由2小时显著降低到5分钟 (vs. GB300 NVL72)。

(6)2026年Rubin CoWoS投片量约30-35万片,预计在1Q26初开始小量试产并于2Q26末量产。VR200 NVL72的机柜组装量产预计在3Q26底,考虑到良率爬坡,预计2026/2H26机柜出货量约5,000-7,000柜。

(7)当机柜功耗达约200kW,54V配电会开始遭遇显著的空间占用 (铜排/线材) 与转换效率瓶颈,故VR200 NVL72可视为Oberon机柜的最后一代方案;后续面对AI算力提升带来的挑战,将采用支援800V HVDC的次世代Kyber机柜设计因应。

【关于液冷】

2、英伟达Rubin 即将面市,100%全液冷方案,液冷需求或将提前爆发

(1)在2026年的CES上,英伟达公司首席执行官黄仁勋宣布,英伟达公司备受期待的新一代Rubin数据中心产品即将在今年面市,届时客户将能够试用该技术,从而助力加快人工智能(AI)的发展进程。黄仁勋介绍,全部六款全新的Rubin芯片均已从制造合作伙伴处取回,并且已经通过了一些关键测试,这表明这些芯片正按计划推进,可以交付给客户。

(2)Rubin架构服务器确定100%液冷方案,取消风扇及传统软管:Rubin 架构对计算托盘(Compute Tray)进行了重新设计,旨在简化极其复杂的组装过程:100% 全液冷设计:Rubin 实现了从前代约 80% 液冷到100%全液冷的转变,底盘内部彻底取消了风扇。rubin架构沿用GB300方案,全面取消传统的EPDM橡胶软管,继续采用不锈钢波纹管。冷板架构上,rubin架构采用类似GB200的大冷板模组方案,1块大冷板覆盖1CPU+2GPU的组合。

(3)交换机小冷板覆盖,全液冷架构趋势明显:交换机部分,Rubin交换机方案和GB300的架构类似,小冷板覆盖交换机Asic芯片,全液冷覆盖,每块Asic覆盖一块小冷板。除了Rubin交换机,英伟达还推出pectrum-X CPO交换机,也是采用全液冷架构,其中液冷架构非常复杂,光模块等环节也采用铜冷板覆盖,全液冷架构趋势明显。

(4)液冷生态伙伴全面跟进,大陆厂商处于关键时间节点:目前,Rubin平台相关生态合作伙伴已经开始跟进,包括整机解决方案提供商、零部件供应商等,我们认为,目前随着Rubin量产预期提前,大陆厂商正处于最后关键送样及认证阶段,需及时关注。

【关于电源】

3、2026年ces展会上,Rubin确定会用vpd方案,美股vicor(vicr)最为受益

此次大会黄仁勋确认Rubin架构进入全面量产阶段,相对Blackwell(GB200)的1200W,Rubin的单片TDP飙升至2300w。这种情况下,传统侧向供电会压降失控,只有通过VPD让电流从芯片下方直达核心,才能将损耗降低。

这个方案引入意味着散热量不再只集中在芯片正面,PCB 背面的电源组件也需要极高的散热效率,英伟达这次展示了两相冷板液冷技术,以应对这种垂直分布电源。

最后一个Rubin架构将搭载更宽、更多的HBM4显存,HBM因为已经占据了GPU封装周围所有空间,物理位置已经没有给横向供电(lpd),因此vpd(垂直供电)是确定性方案。

Vpd方案里vicor布局了大量专利,基本上所有公司如台达,mps要做vpd都要给vicor付授权费,我们预计26年光各种授权费就要收取2亿美金(相当于纯利润),公司预计后续每年授权费有50%增速。

高功耗环境下,aidc电力电子最大趋势就是sst方案+vpd,sst大家是各凭本事,vpd是各家都绕不开vicor一定要给他付钱。25年vicor打赢了致胜的专利战,业绩即将迎来收获和爆发。

【关于存储】

4、事件:NV推出BlueField-4 DPU,使单GPU额外获16TB上下文空间

Vera Rubin NVLink 72每个机架中,配备4个BlueField-4 DPU直接管理150TB的上下文内存池,内存池通过机架内网络与所有GPU直连,为每个GPU分配额外的16TB的专用上下文空间,解决AI应用长上下文的瓶颈。

存储架构更新,老黄先讲了推理机制

每生成 1个 Token(一个词),GPU 都要把整个过去的对话历史(即 KV Cache)从显存里读一遍。随着对话变长,KV Cache 的体积会线性膨胀。这个“读一遍”的过程极其消耗带宽。我们希望AI可以记住跟它进行的每一次对话,现在的做法是把 KV Cache 放在 HBM 里(因为它够快),但 HBM 又贵,容量又小,前一代的解决方案是利用 NVLink-C2C 把 Grace CPU 的大内存(LPDDR5X)当成 GPU 的扩展显存用,这个不够用了,第二个方法是数据溢出后,通过“南北向网络”(North-South Network)去读取远端的存储服务器,这个问题是太慢了,网络带宽被挤爆,延迟无法接受。

所以,解决方案为把存储搬到机架里,贴着 GPU 放(如下图3),并用 BlueField-4 来管理,不再去远端的存储服务器读数据,BlueField-4 在这里不仅是 DPU(数据处理器),它也变成了一个专用的 KV Cache 管理器,每个GPU多16TB(这边对NAND是大利好)

NV提出单GPU增加16TB NAND,对NAND市场的影响到底有多大?

目前GB300 NVL72单机柜的存储配置为:HBM 20TB、LPDDR5X 17TB、NAND 553/1106TB(取中间值830TB)。

按照10万机柜计算,对应的存储需求为:HBM 2EB 、LPDDR5X 1.7 EB 、SSD 83 EB。25年全球HBM、DRAM、NAND的供给量是2.8EB、36.4EB、931EB。

根据NV最新在CES的表述,每颗GPU增加16TB NAND,每个机柜增加1152TB NAND。按照10万机柜计算,NAND需求增加115.2 EB,占25年全球NAND总供给的12%,对NAND的需求极大。

此前仅HBM按照单GPU配比计算,为保存上下文、NV提出每颗GPU配置16TB NAND,对NAND的需求更加确定和可视化,有望成为类HBM的存储产品。

存储逻辑加强,业绩兑现,持续看好存储二波

26年CES上NV提出AI训练与推理中海量上下文数据的解决方案,随着AI大模型参数扩展到数万亿参数,大量的上下文数据以KV Cache的形式缓存在GPU的存储中,KV Cache占用存储容量的持续变大带来训练和推理的瓶颈。英伟达借助BlueField-4提供上下文记忆存储平台,在GPU存储和传统存储中构建“第三层”。NV在Vera Rubin NVL72的每个节点配4个BlueField-4,每个背后有150TB上下文内存,每块GPU额外获得16TB内存。“第三层”存储池的出现,一方面将提升NVL机柜本身存储的容量,第二是新增了内存池需求,都将增强远期NAND需求逻辑!

看好第二波行情,先前美光业绩印证周期仍在持续,AI泡沫论缓和,我们仍然维持先前路演观点,这轮存储周期看到27年。1月Q1合约价落地,环比高增,涨幅超预期!后面仍有许多可以期待的催化,关注1月初密集业绩预告,模组厂商均有望取得不错业绩,也关注本周三星业绩。