AIDC电源革命正式开启,电源主机、储能、功率半导体、核心部件四大方向共振(一)

核心观点单颗AI芯片和单个AI计算机柜功率的不断提升,促使AIDC电源向大功率、直流化、高压化不断迭代。本报告尝试详尽地梳理AIDC电源技术发展趋势,以及给各环节设备带来的变化。投资机会包括四大类:(1)AIDC电源主机,即PSU、HVDC、SST等环节,价值量集中、技术壁垒和入围门槛高;(2)电站级储能,越来越成为AI数据中心并网的刚需;(3)核心零部件,尤其看好固态断路器、CBU/BBU、DC/DC设备、电子熔断器/继电器等AIDC新增环节;(4)GaN、SiC等第三代半导体。综合考虑市场空间、业务弹性、个股α等因素,推荐阳光电源、麦格米特、欧陆通、良信股份、金盘科技等。

摘要

AI供电方案的根本驱动力是单芯片和单机柜功率的不断提升

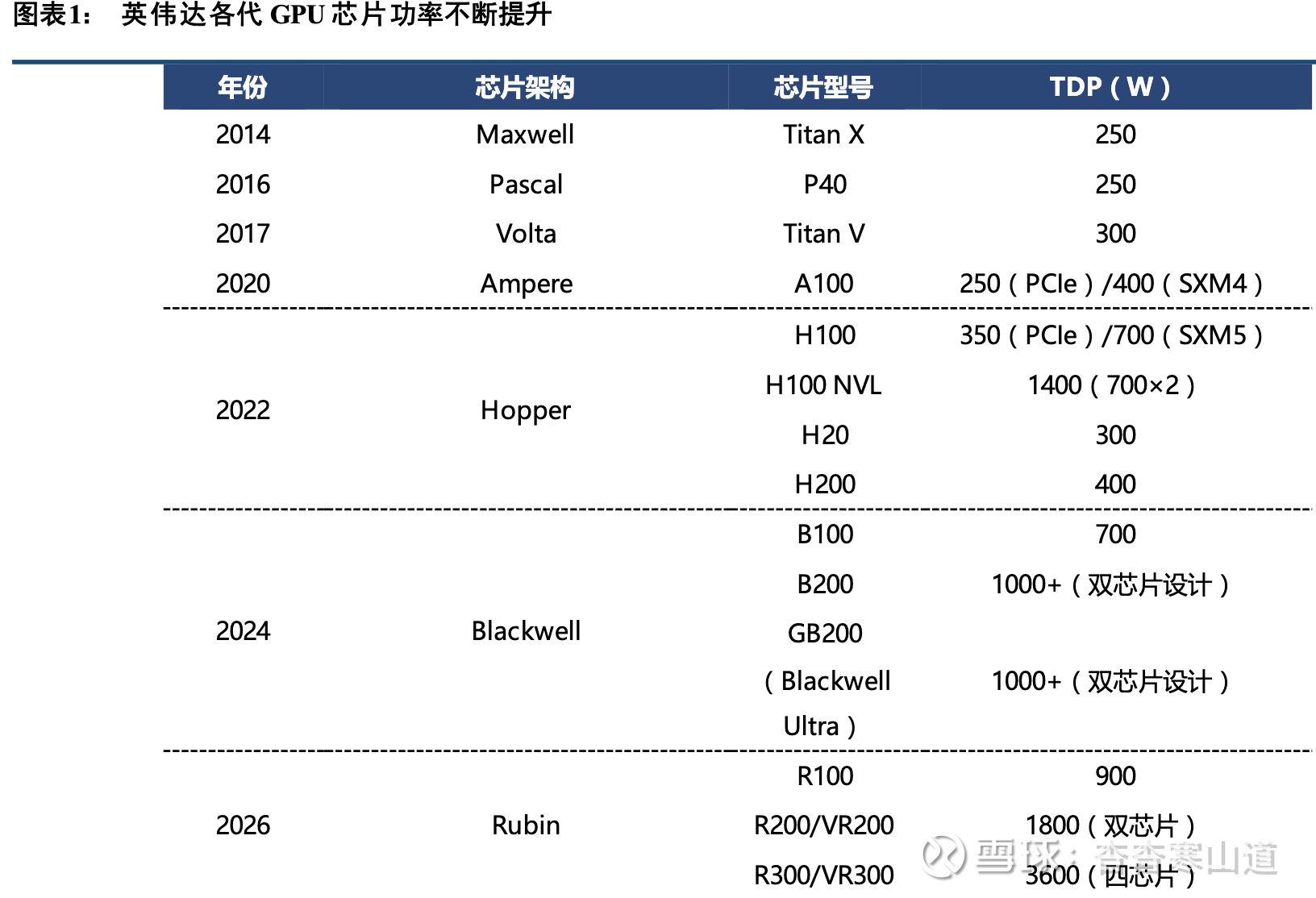

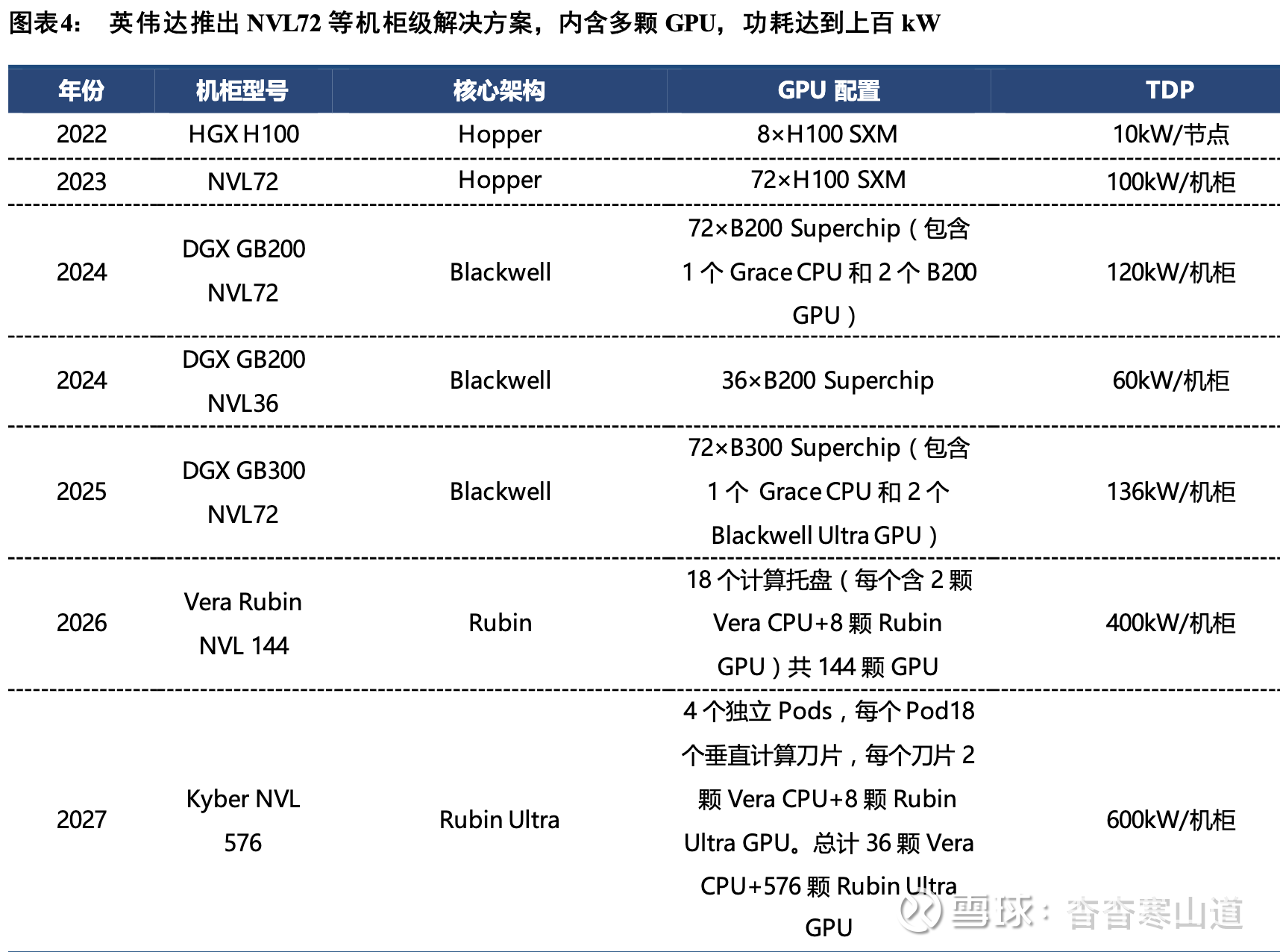

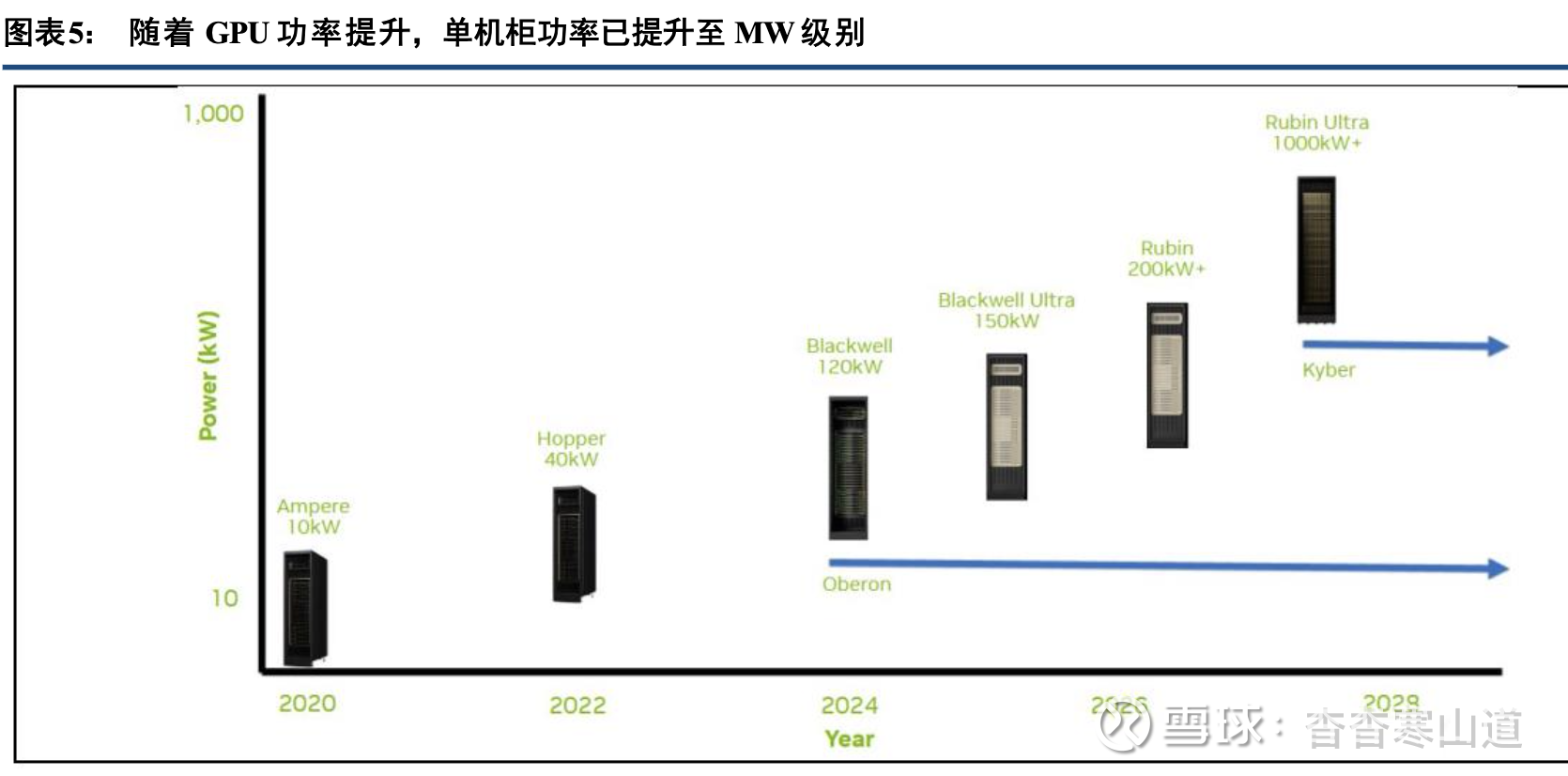

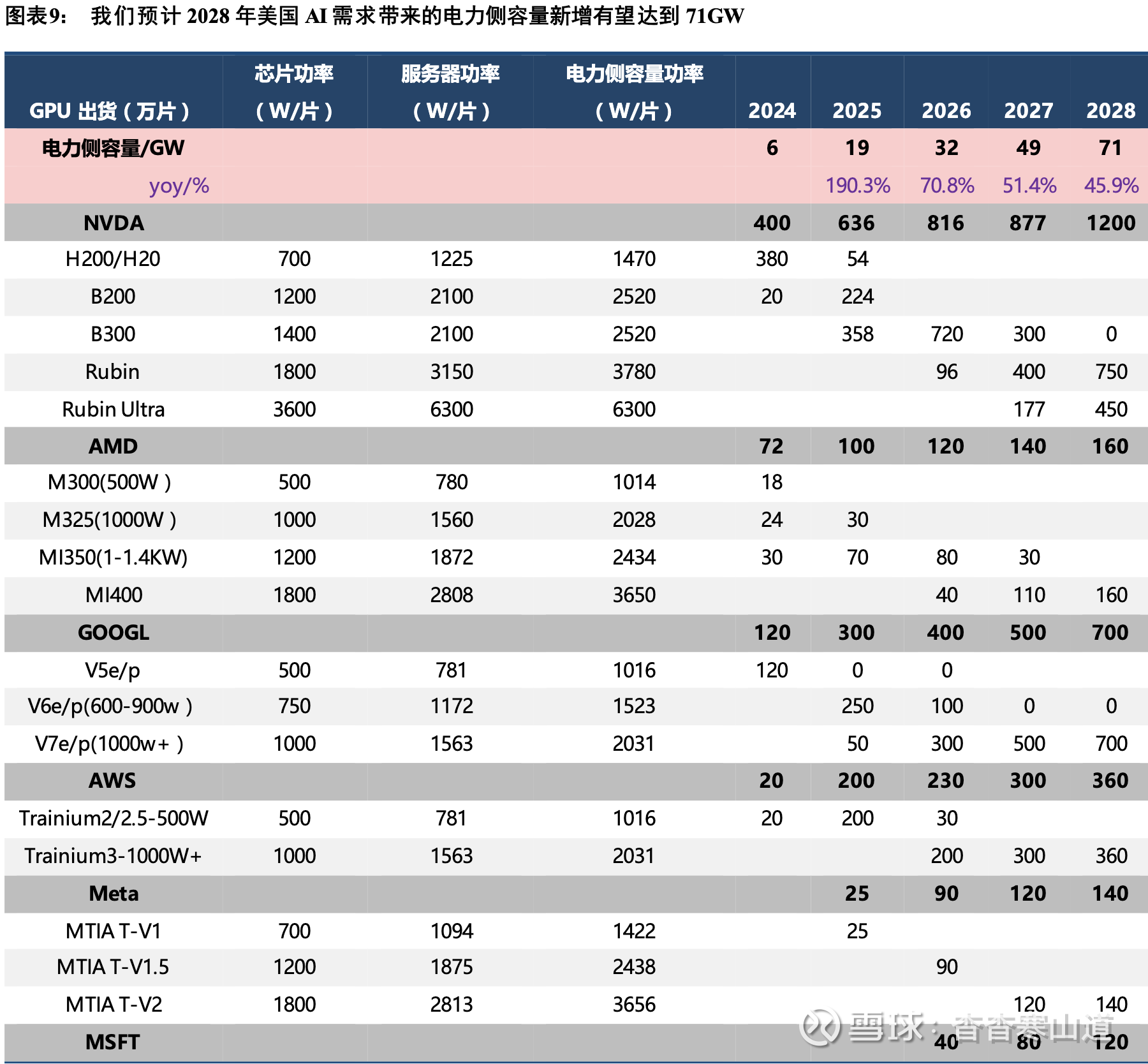

以英伟达为首的AI芯片厂商不断迭代升级其最新AI芯片的功率。英伟达已从Maxwell时代单颗芯片250W提升至B200芯片的超过1000W;谷歌、微软、Meta等自研芯片也向单颗1000W以上迈进。通过NVL72(英伟达)、Superpod(谷歌)等多芯片设计,单机柜功率进一步向MW级迈进。我们认为,至2028年北美新增AI数据中心功率可达71GW。

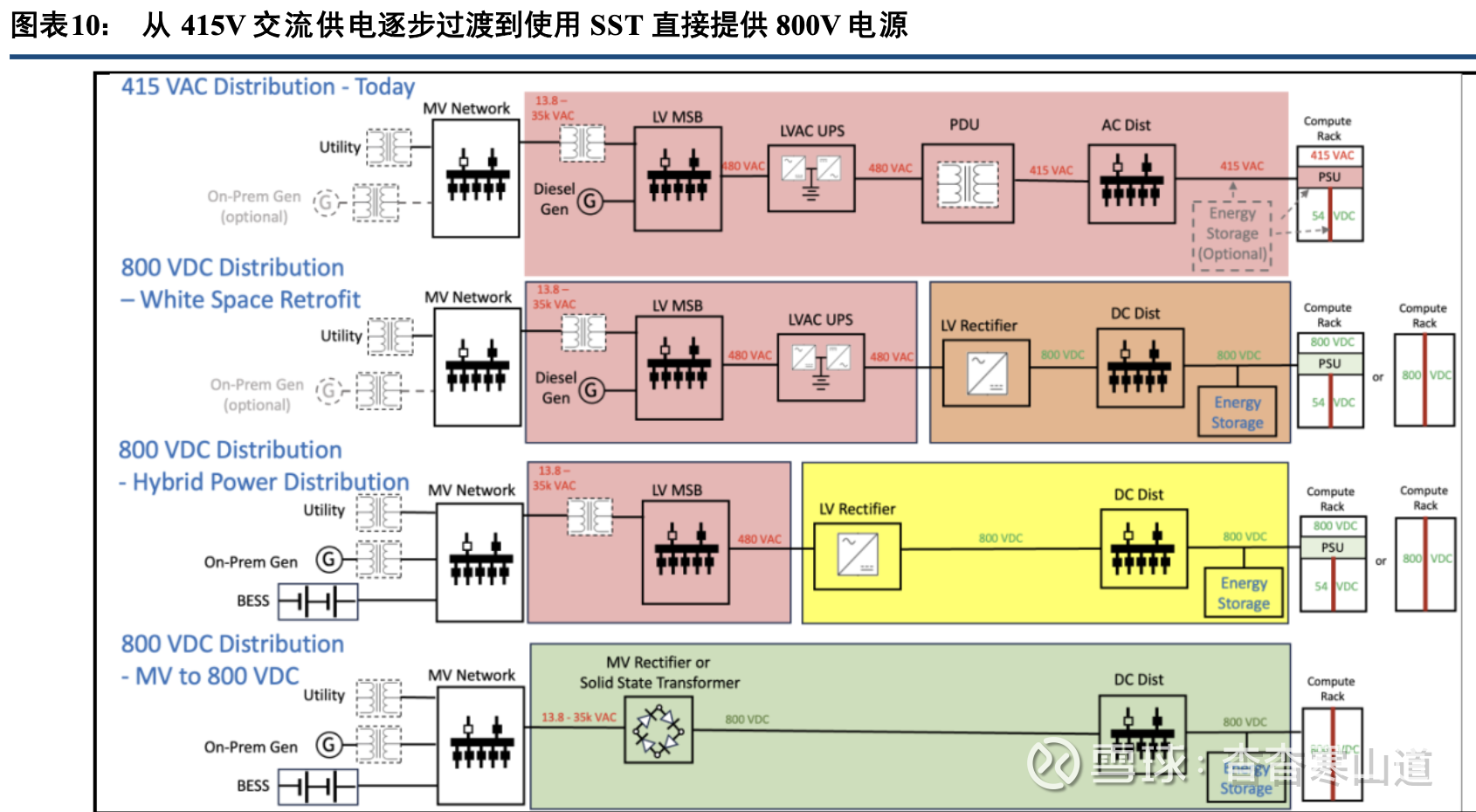

大功率化、高压化、直流化是AIDC电源迭代的主要方向英伟达发布的800V供电白皮书给出了交流→800V直流(低压整流器过渡)→800V直流(HVDC sidecar方案)→SST(固态变压器)的清晰迭代路径。同时OCP组织通过多批标准的迭代也确立了±400V的供电标准。但两者目的均是通过直流供电实现MW级机柜功率,也认可SST作为终极的供电方案。

从无到有,从小到大:供电方案迭代带来了哪些变化和增长?

从产品形态来看,集成多种设备和功能的HVDC Sidecar、SST主机能够实现一步降压、交直转换、备电和电能质量改善等多种功能。而其研发的关键难点在其中的功率变换模块(PSU)、高频隔离变压器等;从技术基础来看,第三代宽禁带半导体如SiC、GaN是电源能够实现高电压、高效率、高变比输出的关键,同时电路拓扑的设计对公司研发实力要求高;从增量环节来看,采用高压直流供电后需增设机柜内固态断路器、DC/DC电源、电子熔断器、垂直供电VPD等环节,同时为了保证供电可靠性和电能质量CBU、BBU也成为必须。

而储能则成为解决美国电力缺口和数据中心并网危机的最主要选择。

投资建议:产业趋势优先,兼顾弹性和公司α我们认为以下四大方向值得关注:(1)AIDC电源主机(PSU、HVDC、SST):阳光电源、麦格米特、欧陆通、金盘科技、思源电气、伊戈尔、科士达、科华数据、中恒电气、新风光等;(2)电站级储能:阳光电源、CSIQ(美股)、FLNC(美股)等;(3)核心增量零部件(固态断路器、电子熔断器、CBU/BBU、DC/DC、高频隔离变、VPD等):良信股份、蔚蓝锂芯、VICR(美股)等;(4)GaN、SiC等第三代半导体。结合公司α、业务弹性和进展,推荐阳光电源、麦格米特、欧陆通、良信股份、金盘科技等。

一、各厂商AI芯片向大功率不断迭代,推升单机柜功率迅速增长

1.1 以英伟达为首,各厂商历代芯片功率不断升级

英伟达作为GPU概念的提出者,历年来推出了若干GPU架构,每个架构代表GPU的代际划分,同时 每代GPU包含若干型号。从2014年Ma xwell架构第一次发布专用AI计算卡T itan X到最新的Vera Rubin架构中的R100/200/300 GPU,单颗GPU芯片的功耗已从250W提升至900W,并通过双芯片、四芯片设计进一 步提 升至1800W/3600W

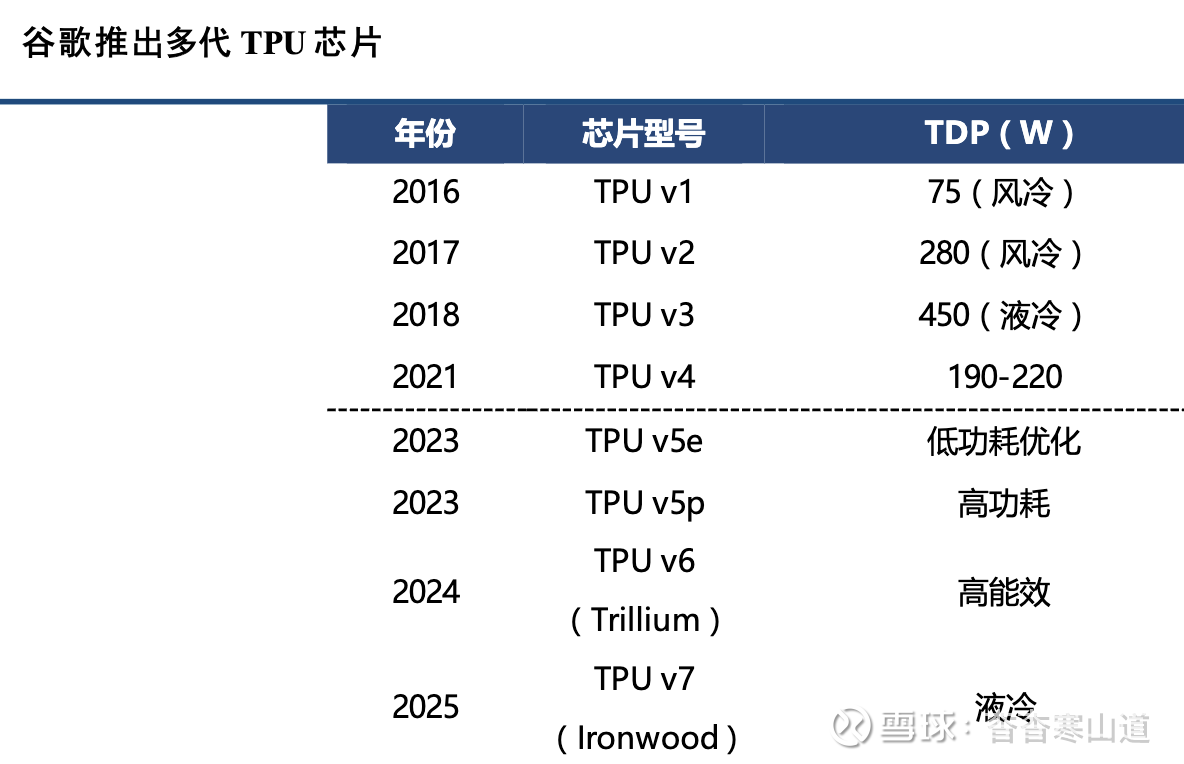

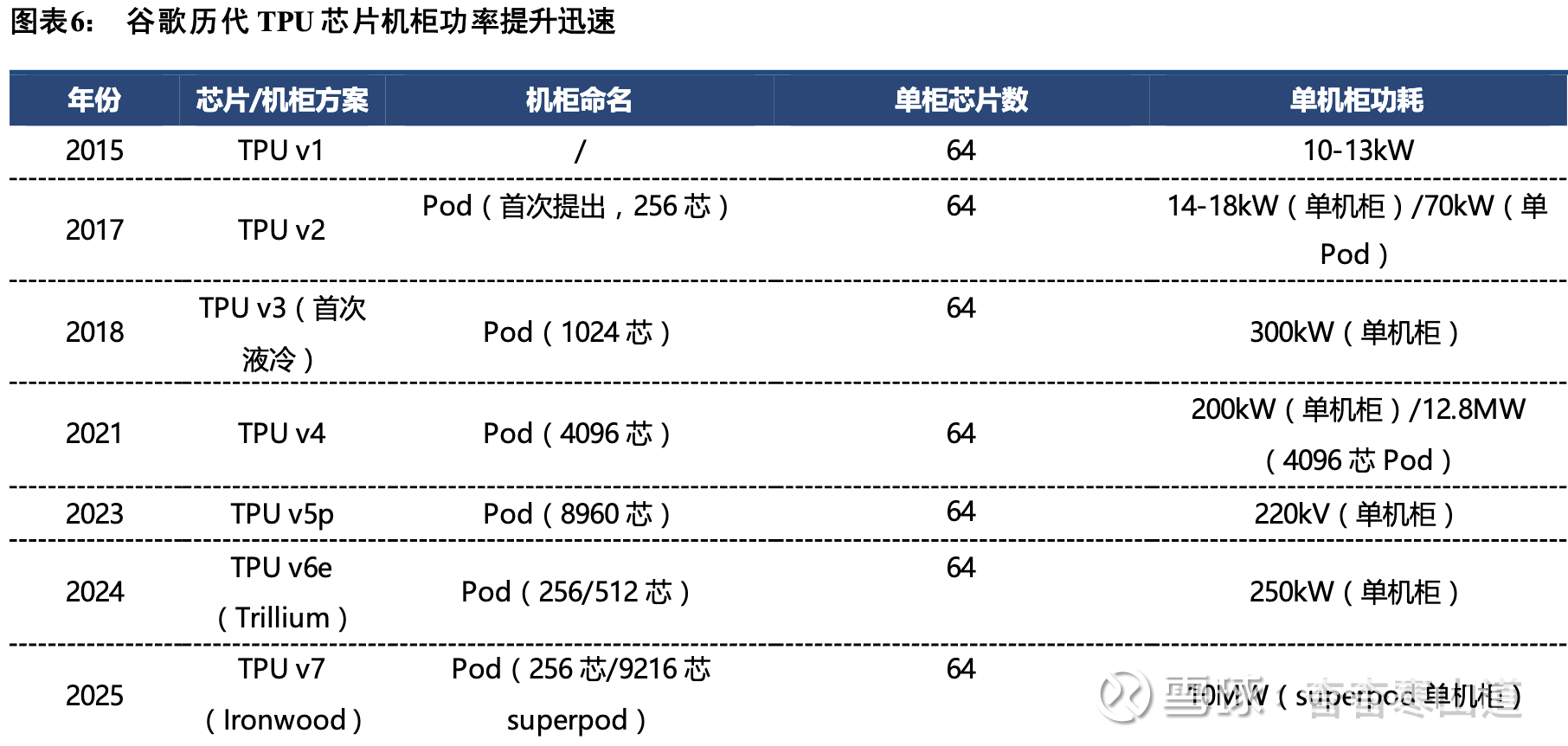

与英伟达(NVIDIA)的通用GPU(GPGPU)策略不同,谷歌的TP U (Tensor Processing Unit)是典型的ASIC(专用集成电路),主要用于谷歌自己的数据中心内部,通过Google Cloud对外提供算力,或用于加 速谷歌自家的业务(如搜索、YouTube、Ge min i模型等

谷歌TPU从2015年至今已发展7代,呈现出清晰的演进路径:从从单一推理到训练推理兼备,从低算力到超高算力,从电互连到光互连,从风冷到液冷。特别是最新的Ironwood,单芯片算力突破4.6 PFLOPS,是专为AI 推理时代设计的里程碑产品。除此之外,微软、Meta等头部AI厂家也推出了自己的AI芯片,但相比英伟达和谷歌,型号尚少 ,这 两家也大量应用英伟达芯片部署在自己的数据中心

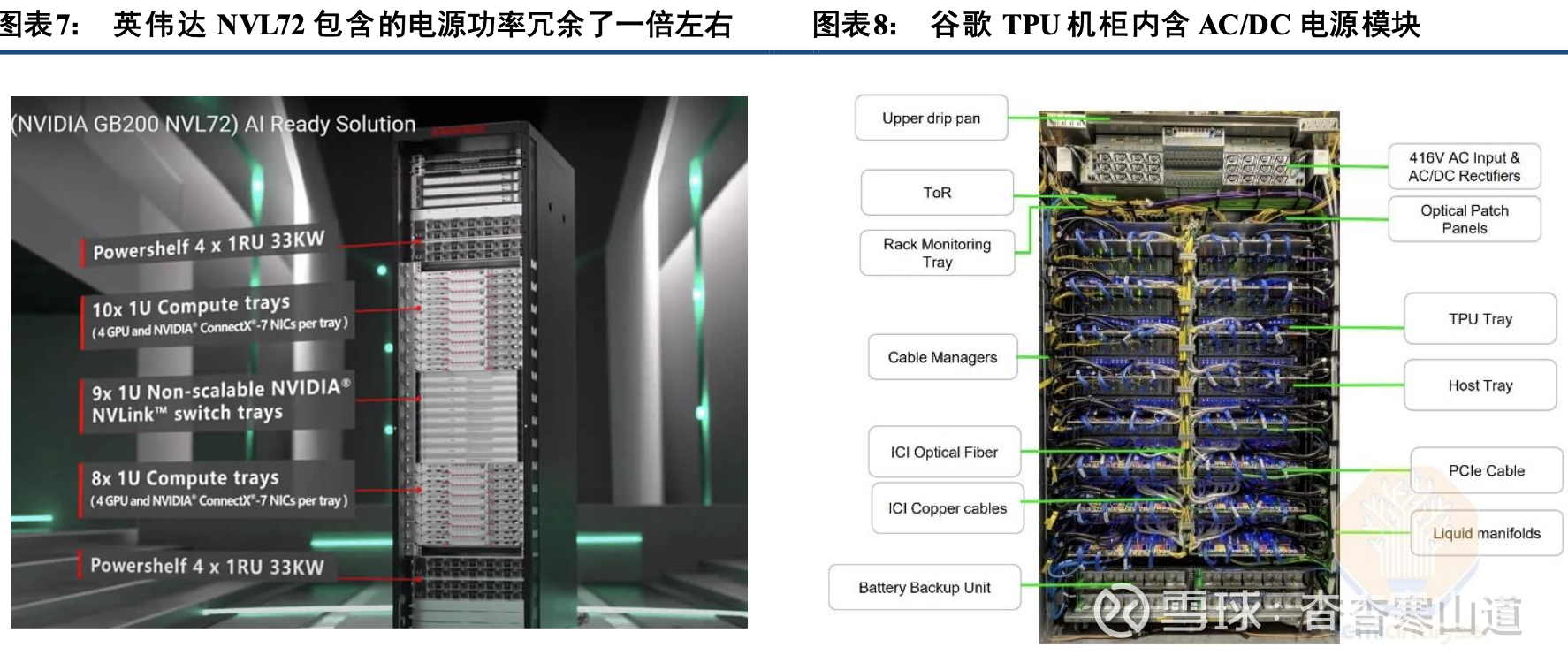

英伟达推出机柜级(Rack-Sca le)方案,代表其在AI基础设施领域从提供单卡或单机向提供统一架构 系统的战略转变。如英伟达推出NVL72,可使用H100、B200或B300芯片,内含72颗GPU芯片和36颗CP U芯片,单机柜功率达到100kW级别(考虑2N冗余后配置电源功率达到200kW级别)。在Rubin架构推 出后 ,英伟达推出的Kyber机柜结构将包含的GPU数量增加到576颗,单机柜功率达到600kW以上

同时,谷歌也为其TPU芯片开发了专用机柜系统,称为T PU Pod,类似于英伟达的NVL系列,但采 用完全不同的设计理念和互联技术。在Pod设计中,每个标准T PU机柜固定包含64颗T PU芯片(16个托 盘× 每个托盘4颗芯片),TPU和CPU之间通过PCIe连接。从TPU v3开始,谷歌全面采用液冷系统(之前v 1/ v 2主要为风冷),电源方面采用定制的高压直流(HVDC)供电,单机柜功率从v3的300kW到v7的10MW不等

作为ASIC阵营的代表,谷歌的TPU Pod方案虽与英伟达的NVL72等方案不同,但都遵循规模越 来越大 、功耗越来越高、使用液冷取代风冷等的规律。到2027年,普遍迭代至单机柜MW级规模,同时供电 方案 也由交流供电转为直流供电。

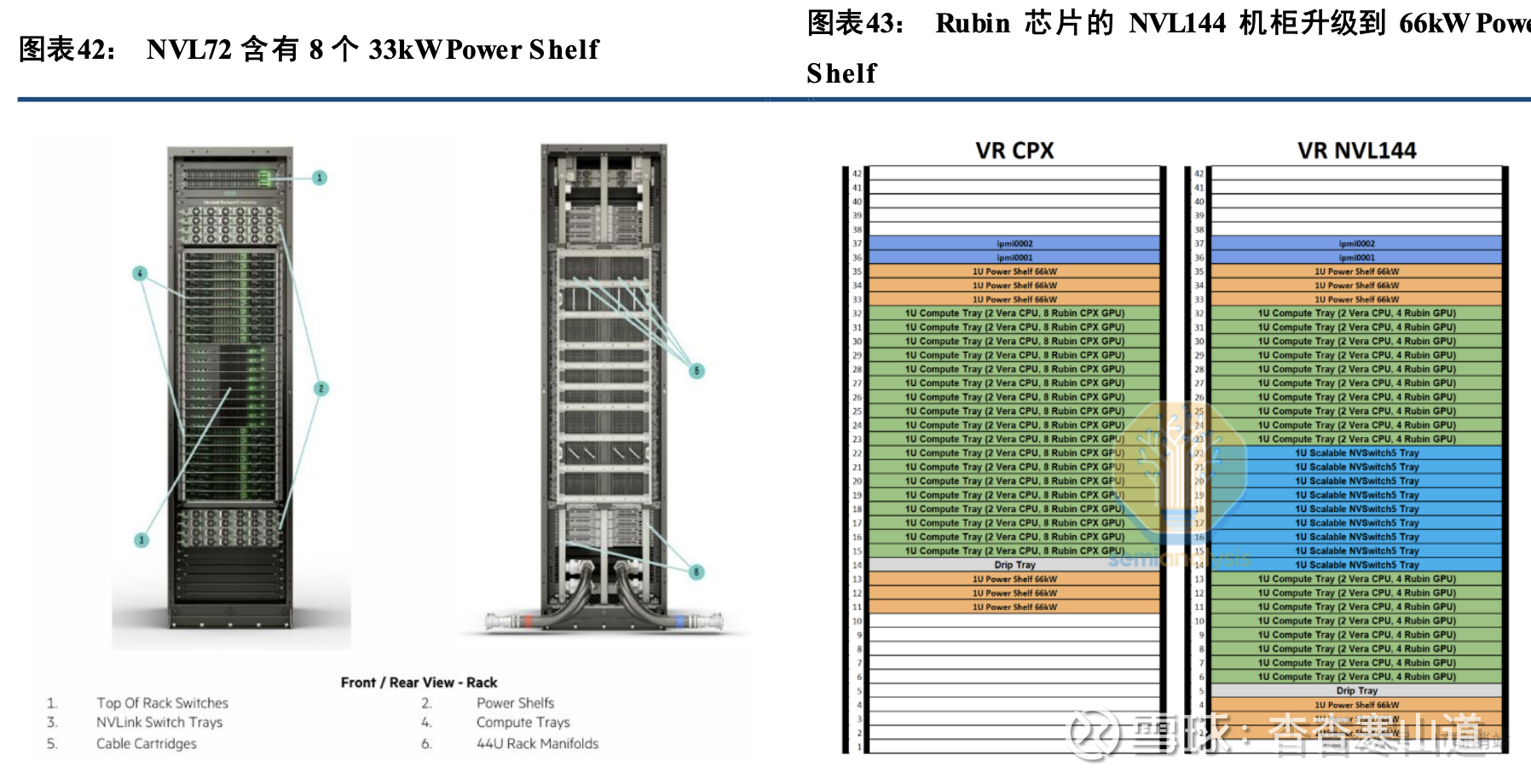

1.2 AI数据中心带来巨大的供电需求

由于一台机柜中往往除了GPU外,还含有CPU、交换机、内存、液冷等用电,以英伟达为例,典型的GB 20 0 NVL72机柜包含18个计算托盘,每个含4颗B200 GPU和2颗Grace CPU。单看72颗B200 GPU芯片的功率仅约86.4kW,但加上9个NVLink交流机之后功率增长到约132kW,而实际上标准的NVL72机柜配 置多达8套33kW Powershelf,总的供电功率达到264kW,相当于冗余了一倍。因此我们在考虑对应的数据中心 功率 需求时,大多按芯片总功率×2来考虑

谷歌的TPU机柜则使用内含16个TPU托盘,每个托盘含4颗TPU芯片。电源(PSU)则安装在机 柜上部,目前仍为交流供电方式,即引入416V交流电源,经过PSU进行AC/ DC整流后进入机柜内提供 电源 。从TPU机柜的电源配置来看,预计冗余倍数也为1倍左右。

2025年英伟达NVL72系列机柜出货量约在2.7-3.4万台,芯片主要是GB200,而2026年出货以GB 3 0 0芯片的NVL72为主,预计出货量将至少达到6万台,对应的机柜功率需求将达到18GW左右。谷歌而言,2 02 5年TPU芯片出货约150-250万颗,对应机柜出货约2.3-3.9万台,芯片型号主要为T PU v6e,v7将Q4小批试产;2026年TPU v7全面量产,受限于CoWoS封装产能,出货量约为310-420万颗,对应机柜数(芯片/ 6 4)约4.8-6.6万个;至2027年,TPU v7成为主流,出货预计达到500-700万颗,机柜台数达到7.8-10.9万 个。 对应2025、2026、2027年谷歌数据中心每年的新增功耗约为5GW、8GW、10GW

基于北美主要厂商芯片最新出货,我们测算2025-2028年美国AI需求带来的电力容量需求分别为19、32、49、71GW,三年CA GR约为55.7%。其中,对于英伟达考虑60%供美国本土,其他ASIC阵营则考虑 全部 供美国本土;

二、大功率化、直流化、高压化是AIDC电源迭代的主要方向

2.1、英伟达800V供电白皮书发布,供电方案演化路径日益清晰

2025年10月13日英伟达在OCP 2025年峰会上发布了800V供电方案白皮书,清晰地指明了供电方 案的演化路径:

AIDC供电由交流向直流演化是大势所趋

在白皮书中英伟达指出了清晰的供电方案迭代路径:

①415V交流供电:当前采用的供电方案,通过中压变压器降压、低压UPS提供交流电源,415V交 流入柜,柜内PSU进行AC/DC转换。②800V直流供电(过渡方案):其他不变,用低压整流器(LV Rectifier)+直流配电柜的组合代替PDU+交流配电的组合,接入UPS的输出侧,同时800V直流侧可以接入储能。这种方式仅需对现有的 供电方案进行小改,缺点是增加了更多转换环节,效率下降。③800V直流供电(进阶方案):取消UPS,用设施级A CDC整流器(功率达到1.5MW级)彻底取代UP S,减少了不必要的转换环节。仍需要从中压变压器低压侧引入480V交流电源。④SST方案(终极方案):探索中压整流器并进一步使用固态变压器(SST)作为未来方案, 容量 高达7.5MW,可从13.8kV或35kV中压交流直降800V直流,简化电力结构

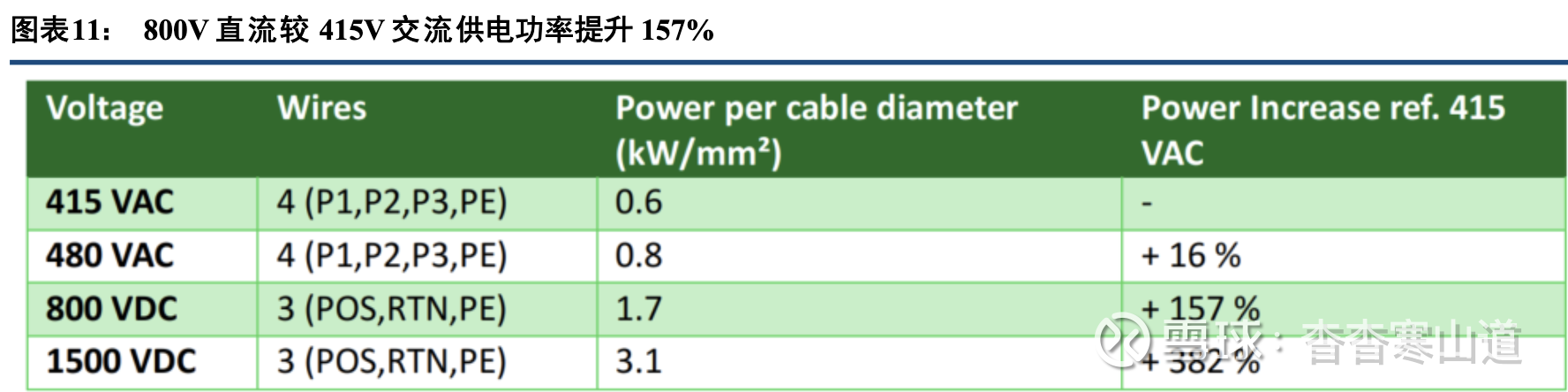

采用800V直流供电有诸多好处:(1)简化供电结构,减少铜材和接插件使用:通过更高的电压供电,可以在大多线缆额定的60A/100A传输电流的基础上输送更大的功率,从而减少电源转换级数和转换接口,简化供电结构

根据英伟达的说法,1MW功率需求下需要高达200kg的铜母线,1GW数据中心的机架母线需求高 达50万吨,若不提升供电电压等级,则难以满足高功率机架的需求

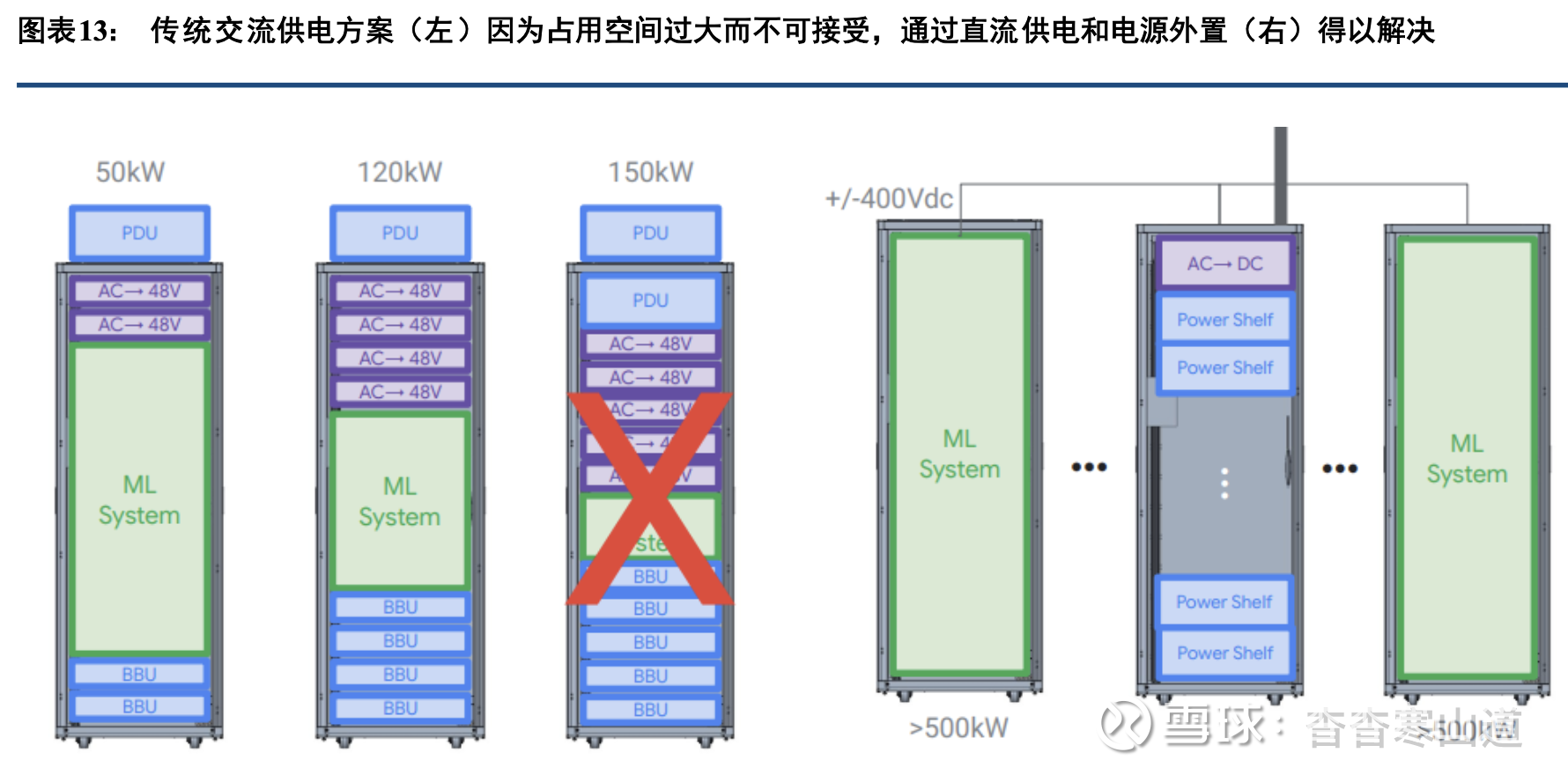

比如,为了传输500kW级的功率,若使用50V电压等级,铜母线线径将达到56mm直径,相当于可乐 瓶粗细,如果电压等级提升到400V,线径降低到20mm,如果进一步提升到±400V,线径下降到14mm, 相当 于口红粗细。(2)减少供电模块的空间占用:数据中心服务器机架的基本高度单位为1U(4.45cm)或1OU(4.8cm),电源、服务器等尺寸基本按 此设计。通常一座服务器机架高度约42U,1880mm,随着机柜功率要求的逐步提升,电源模块(power shelf、PSU等)所占用的空间也越来越大,逐步挤占计算模块(GPU、CPU、计算托盘等)所占用的空间。以下图为例,side power rack中集成了PDU(电源分配单元)、BBU、CBU、Power shelf等各类电源设备,而传统的AI服务 器机架中,以NVL72为例,33kW Power shelf要占4U空间(假设不增加冗余),若为Rubin Ultra等功率更高的芯片供电,机柜功率达到600kW级,power shelf要占16-20U,几乎占到机架空间的一半,显然不可接受

解决办法一是采用单个更大功率的power shelf、PSU,但若不改变供电电压,截至目前单个power shelf最大功率也仅达到72kW,由6个12kW PSU组成。而电压升级到±400V(或0~800V),且开始采用专门的power rack(sidecar)方案之后,由于电源机架外置,电源模块不再挤占计算模块的空间。

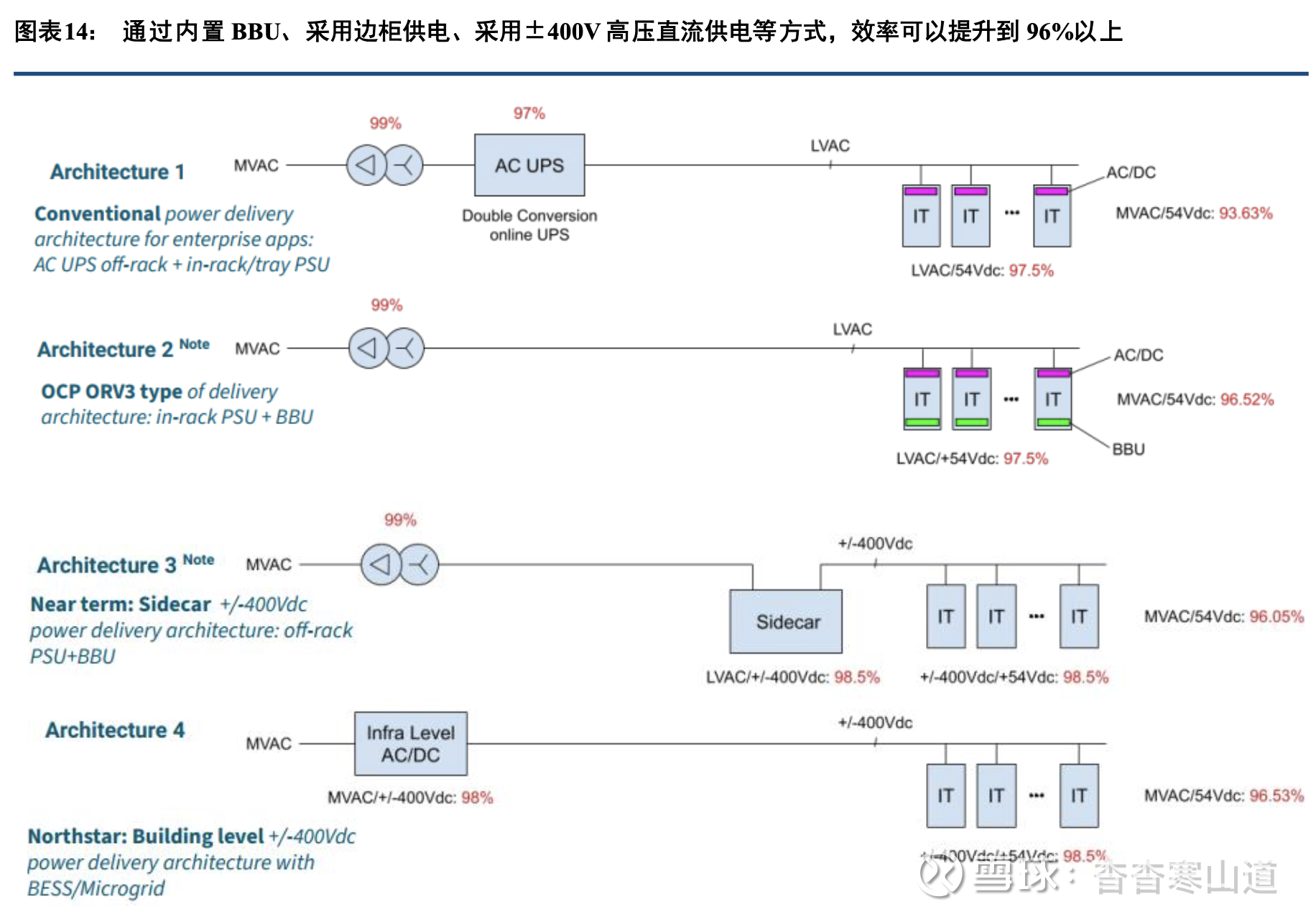

(3)提高电源转换效率:通过采用直流供电架构,HVDC系统通过AC-DC直接直流供电进入机架,相较交流供电中的AC-DC-AC,至少减少了一个交直流转换环节,从而具备更高的转换效率

根据谷歌在2024年OCP峰会上的报告,传统的中压交流——UPS——低压交流——IT机柜内转54V直流的供电方案,端到端效率约93.63%,而采用BBU替代UPS,综合效率可提升至96.52%,采用sidecar边柜 方案±400V直流供电,效率也在96%以上。而如果采用一步直降±400V直流(如采用固态变压器SST) 后, 综合效率可提升至96.53%。

SST是各阵营认可的AIDC终极供电方案

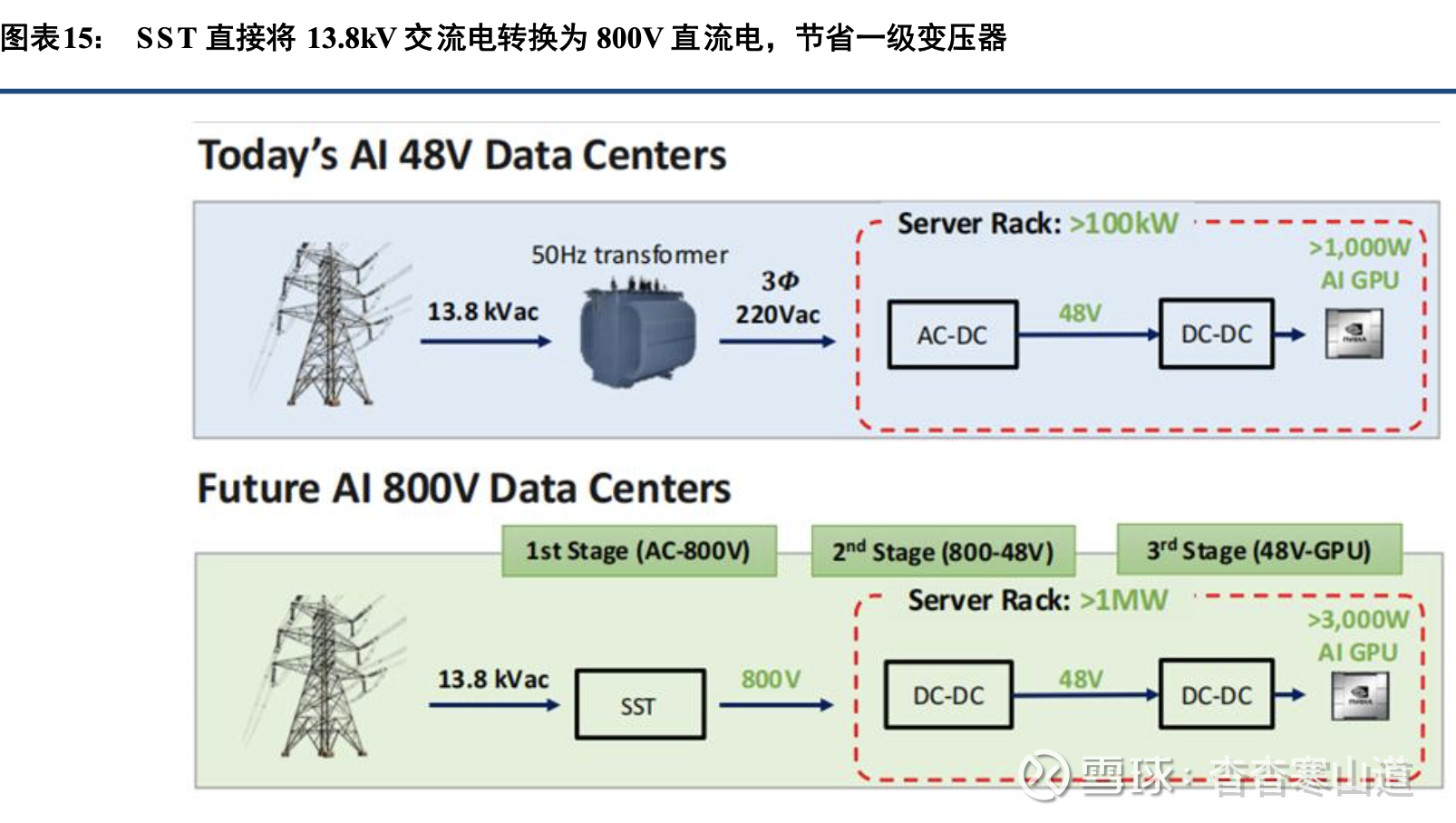

英伟达在800V白皮书中提出,SST(固态变压器)是提供800V直流的终极解决方案,能够将中压交 流电网提供的13.8/35kV交流电一步直降800V直流。在SST技术尚不成熟的当前阶段,也可以使用7.5MW级 别的工业级整流器,实现一步将中压交流电整流至直流,可以省去大部分中间转换步骤,减少能量损失。无 独有 偶,上图中谷歌提出的四个供电架构中的“架构4”,包含“infra level”的AC/DC环节,实际上也是指的 固态 变压器。固态变压器的优势包括:

(1)节省变压器,简化供电结构

固态变压器(SST)能够直接将高压交流电(10kV或13.8kV)转换为±400V或800V直流电源,相比 于传统的UPS方案,能够节省高压交流-低压交流-直流-交流三步传输环节。相比HVDC,也能够节省前端 变压 器降压环节

(2)提高转换效率:

传统工频变压器是铜线绕组,SST用可控硅等功率器件替代铜线等传统工频变压器,同时用高频电力 电子变换器取代50Hz或60Hz的传统工频,从而降低尺寸、提高效率。从图16中可以看到,SST取代 了变 压器+ACDC环节后,总体效率可达98%。

(3)适应多种电源输入,有利于绿电渗透

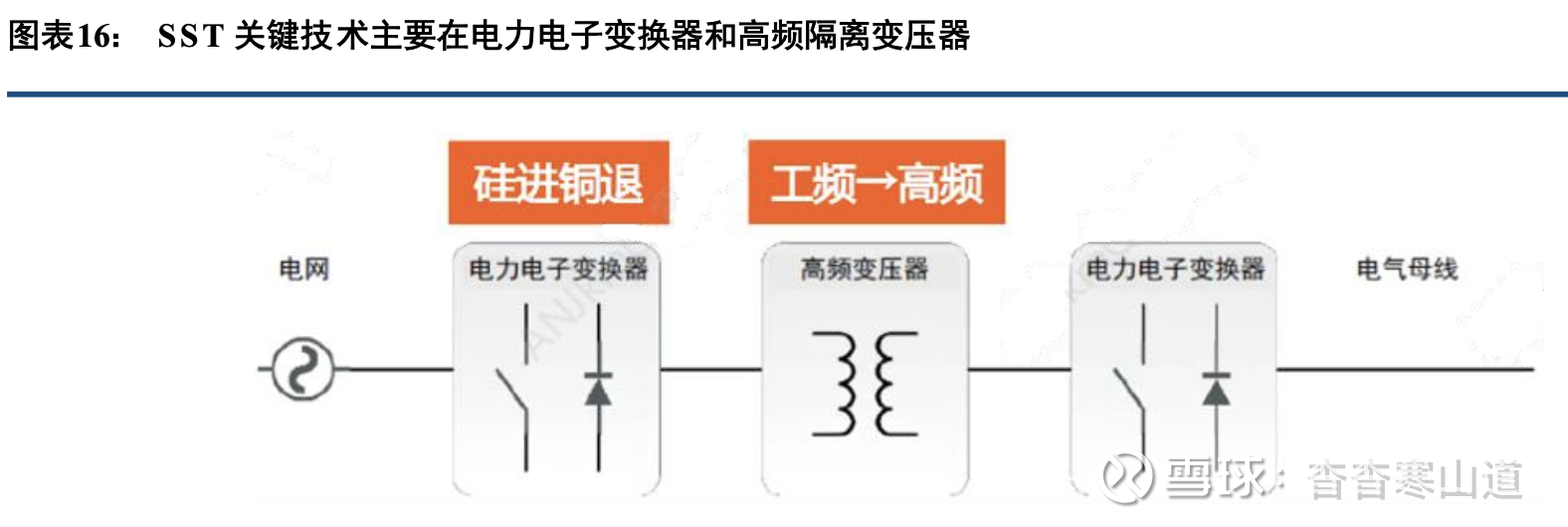

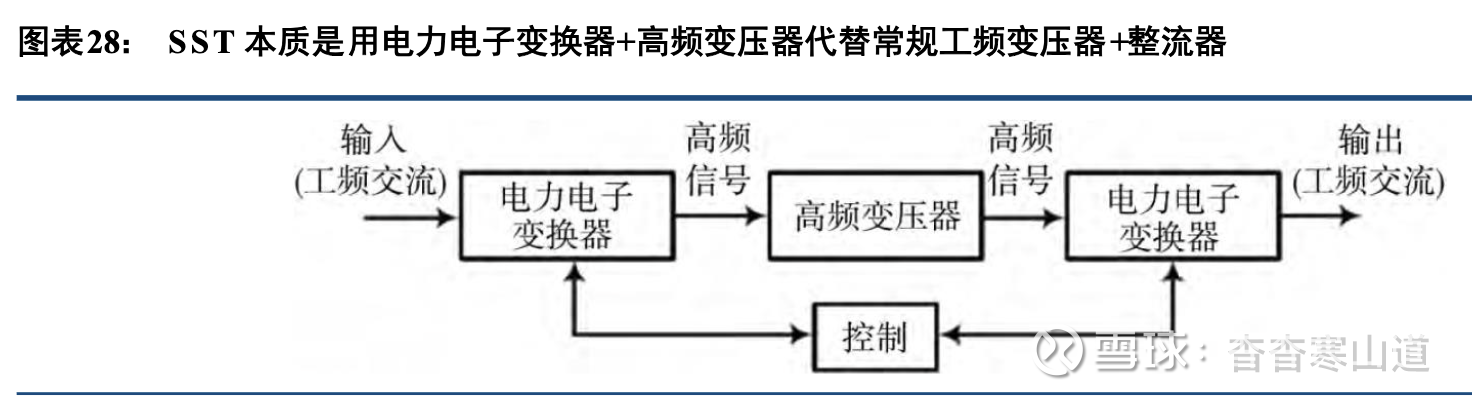

固态变压器的主要技术原理为:(1)将工频交流电通过电力电子变换器转换为直流电;(2)将 输入 的直流电转换为高频交流电;(3)通过高频变压器传输后再转换回直流电,实现电气隔离和电压等级调整;(4)再逆变为工频交流电或直接输出直流电,并确保电能质量

由于采用电力电子变换器替代工频交流变压器,固态变压器可以适应多种电压、多种频率的电源 输入 其适应于光伏、风电、储能等电源的能量输入,有助于提升绿电渗透率。

2.2、功率密度提升,催生供电设备技术不断迭代

OCP组织不断迭代供电技术,OR v3 将机柜内电压标准提升至50V

开放计算项目(Open Compute Project,OCP)是Facebook(现为Meta)于2011年联合英特尔、Rackspace、高盛和Arista Networks共同发起的开源硬件组织。2009年Facebook启动了一个项目,设计世界上最 节能 的数据中心,工程师从头开始设计数据中心的软件、服务器、机架、电源和冷却,建筑能效提高了38%, 运行 成本降低了24%。该组织主要目的是通过开放协作重构数据中心硬件设计,推动高效、可扩展且可持续的 计算 基础设施发展。

OCP推出了一系列数据中心的硬件、软件、网络、存储、冷却、供电、结构等方面的标准,对于供电方 案,OCP推出了V1到V3先后三个版本,主要针对越来越大的数据中心机架功率,在供电、散热、备电等方面作出了诸多改进。

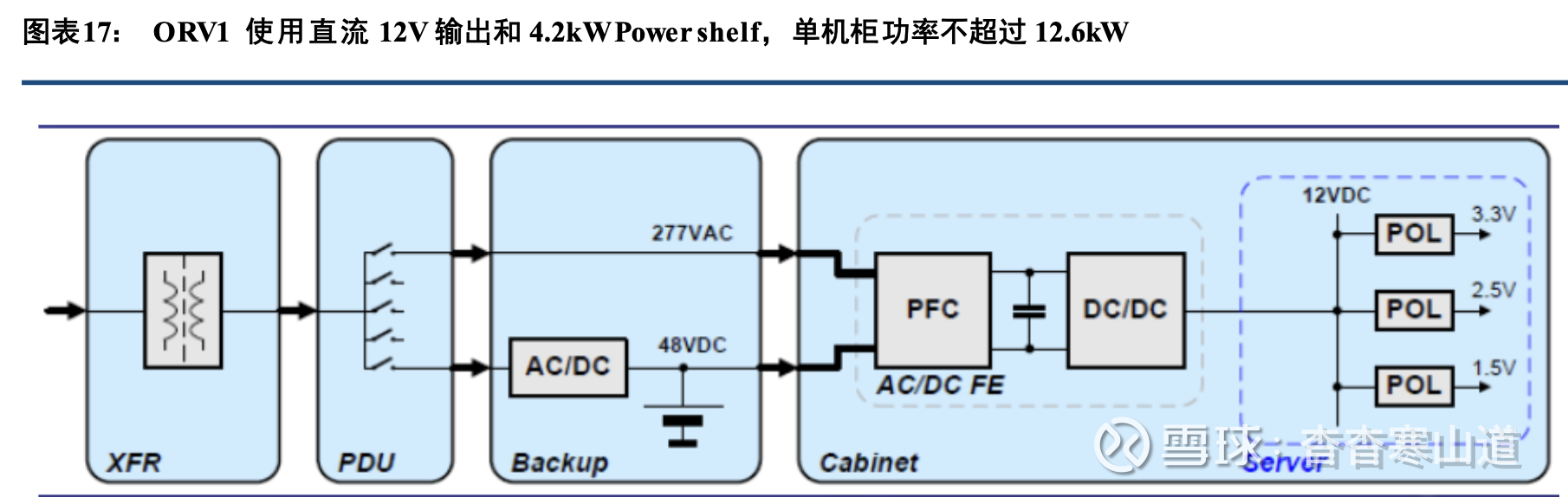

(1)2013:Open Rack V1发布,仍使用12V直流供电

2013年OCP发布Open Rack V1供电架构(ORV1),主要技术特征为:采用21英寸宽度机架(一般 机架为19英寸),其后布置三根母线(busbar)。采用“Power Shelf”概念,即在机架内放置3个Power Shelf(电源架),设备直接从Power shelf上取得电源。每个Power shelf由6个PSU组成,单个PSU功率为700W,整个Power shelf功率为4.2kW,而整个机架功率为12.6kW,效率为95.2%。同时,PSU向IT设备输出 的直 流电压为12.6V。此外,这一代供电方案使用铅酸电池作为BBU备电的电源

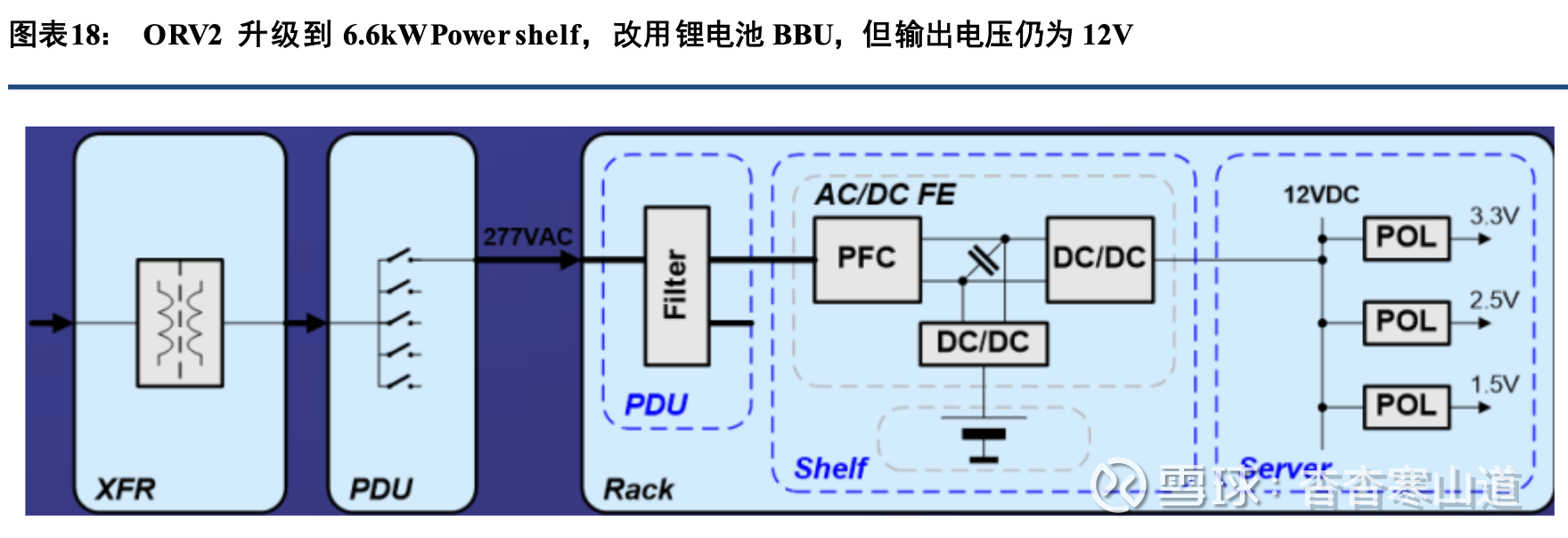

(2)2017:Open Rack V2发布,Power shelf功率升级,开始使用锂电池BBU

2017年OCP发布第二版标准,在该方案中,采用一根母线(而不是ORV1中的三根);采用6.6kW功率的Power shelf,其中包含2个PSU,每个PSU功率升级到3.3kW,同时效率提高到96%。同时,每个Powershelf中配备一个BBU,BBU采用锂电池供电(而不是ORV1中的铅酸电池),具备90s供电能力。整体输 出电 压仍为12.5V

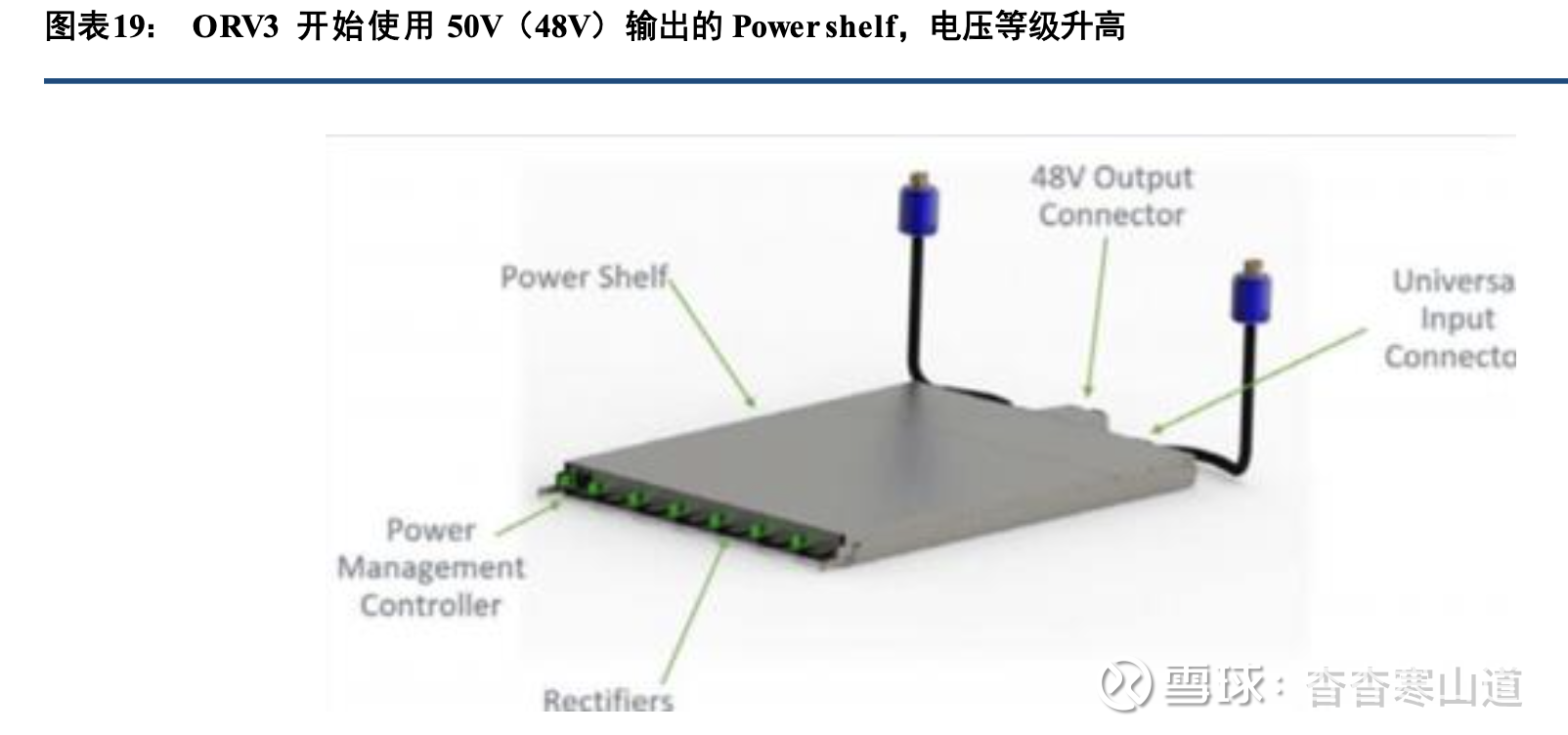

(3)2022:Open Rack V3发布,全面升级到50V电压等级

2022年,为了应对越来越大的机柜功率需求,OCP发布ORV3标准,创新性地采用了51V输出电 压,这样在输出功率相同的情况下,电流下降为原来的约1/4水平,母线直径得以减小,减少了对铜等金属的用 量。这一代标准中,母线形态升级为两面导电的汇流条形式,没有螺孔等位置限制,可以安放在机架内任意位置。Powe r shelf升级到18kW,由6个3kW PSU组成,效率也提升至大于97.5%的水平。同时,BBU电压也升级到48V,提供18kW功率,备电时间延长到240s

基于ORV3,Meta推出支持MW级供电的HPR供电方案

随着AI时代的到来,单机柜功率进一步升高,以Meta(原Facebook)为代表推出了ORV3 HPR(High Power Rack)供电架构,先后推出了HPR V1~V4共四个版本。(1)2024:HPR V1通过提高PSU功率,能够支持GB200芯片2024年Meta在兼容ORV3标准的基础上推出了HPR V1,采用5.5kW PSU取代了3kW PSU,整个Power shelf由6个PSU组成,因此单个Power shelf的输出功率提高至33kW。正常情况下,采用3套Power shelf时,能够支持的机柜最大功率为93.5kW为了适应GB200芯片的高功率(NVL72服务器功率达到132kW),HPR方案下,一台机架至少 需配备4套Power shelf,若考虑冗余,则需配置更多

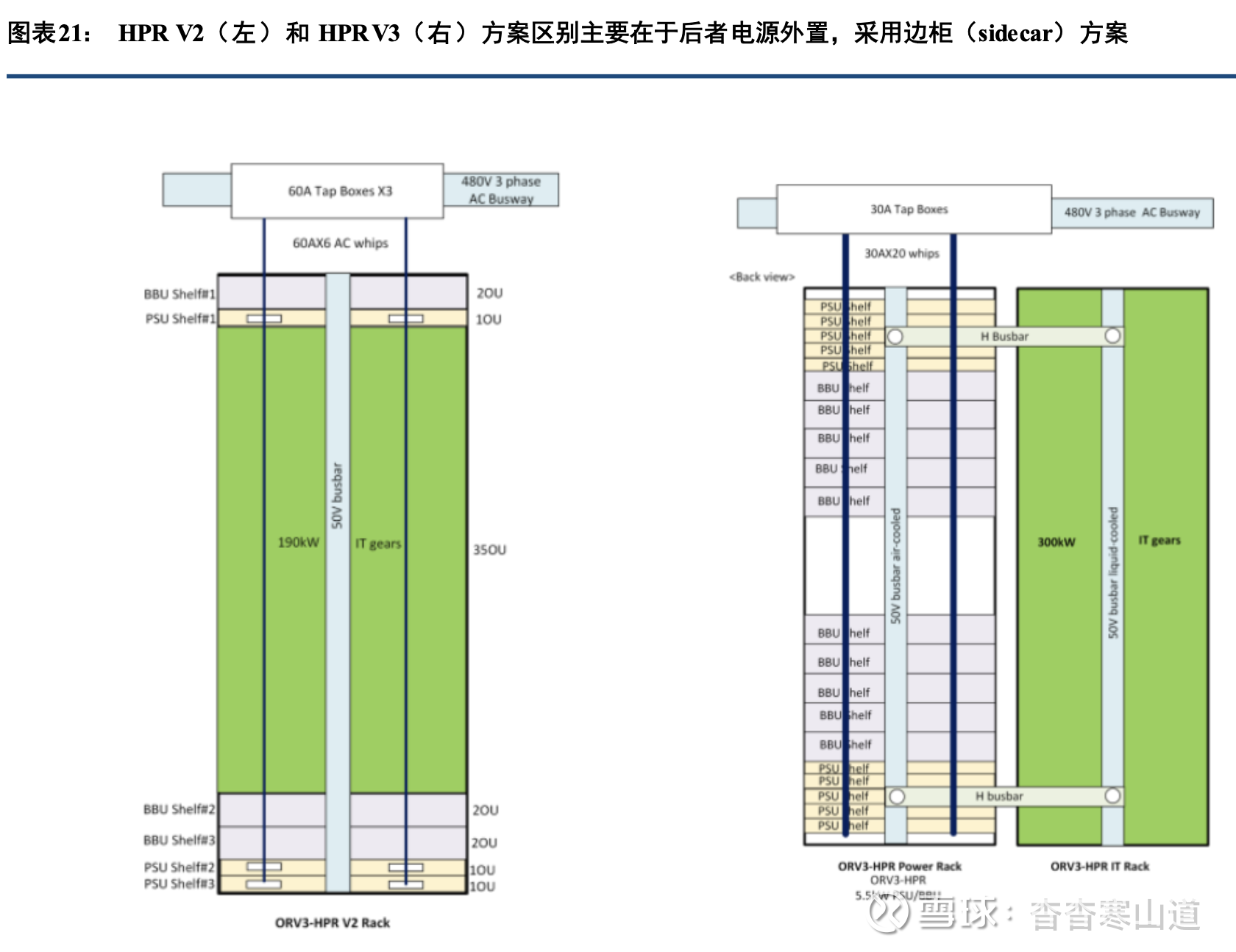

(2)HPR V2进一步提升PSU功率至12kW,可支持200kW级机柜2025年Meta已开始采用HPR V2版本,该方案将PSU和BBU模组的功率从5.5kW提升到12kW,从 而单个Power shelf的功率从33kW提升到了72kW。这样,在考虑一定冗余的基础上,HPR V2能够支持的机柜 功率达到200kW级。在这一代供电框架中,也将超级电容托盘(Capacitor trays)纳入,能够应对GPU启 动时 的快速负载变化对电压造成的影响。(3)HPR V3更进一步,通过电源外置实现对300kW级机柜的支持Meta在2024年的OCP峰会上提出了HPR V3方案。由于机柜空间有限,而功率要求越来越高。因 此HPR V3将电源部分外置到单独的电源机架里,而将计算部分(GPU和CPU)放在另一个机架里,用母线 将二 者连接起来。

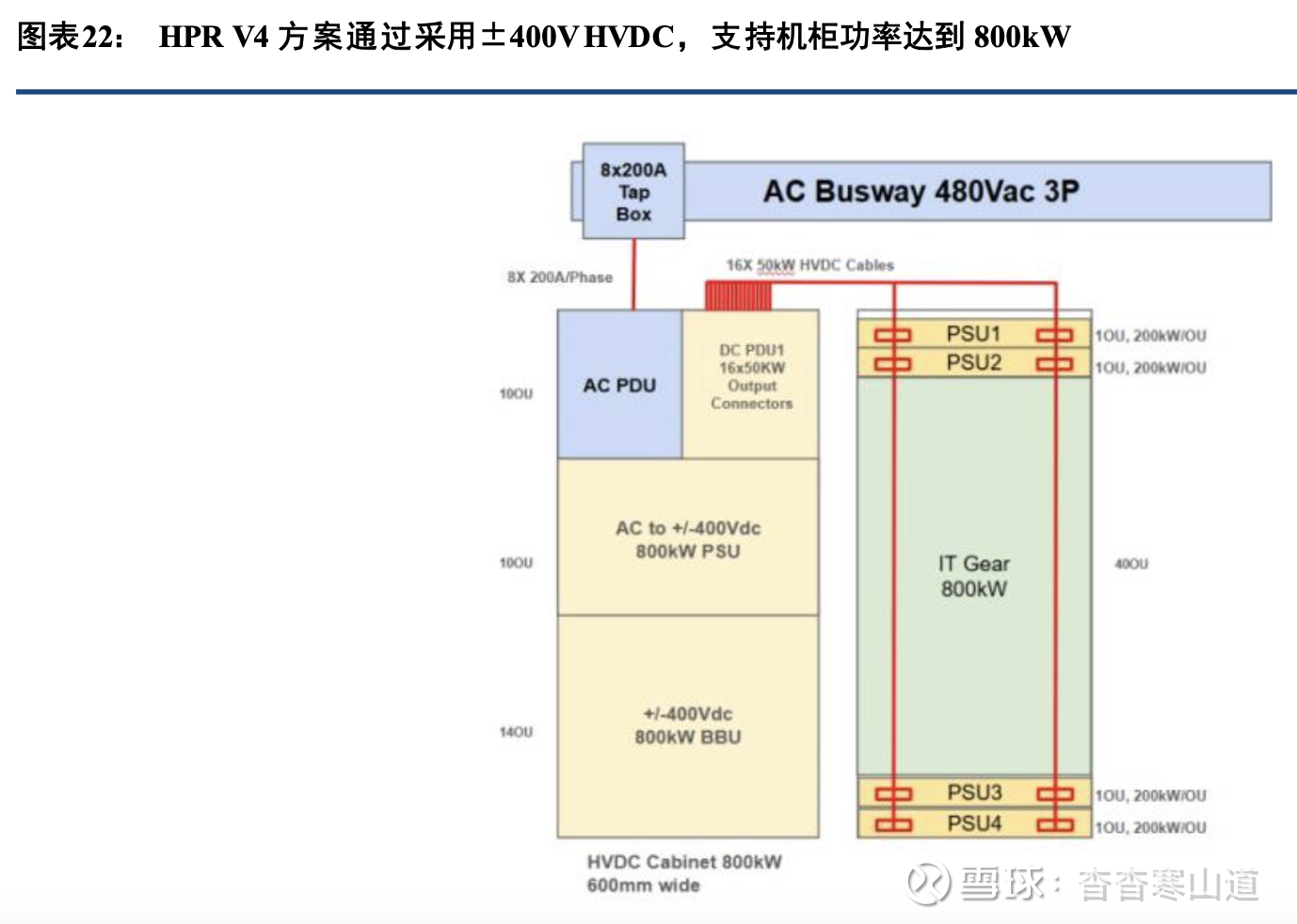

单独电源机架又被称为边柜(sidecar),Power shelf、BBU shelf均内置在边柜中,同时Power shelf仍旧采用50V输出,由6个单12kW功率PSU组成,交流侧仍旧使用480V交流供电。HPR V3可以支持300kW级机柜供电,限制主要在所采用的空气冷却方式上。(4)HPR V4抛弃传统50V供电架构采用±400V直流供电,可支持800kW级机柜供电2024年Meta提出了HPR V4方案,预计将在2026年投入使用。该方案放弃了一直沿用的50V直流输 出电压,改为±400V高压直流(HVDC)输出,PSU、BBU的输出电压也都提升到±400V。同时,由于电压 提高 ,电源柜和计算柜之间的连接改用直流电缆,而不是母线

在该方案中,由于服务器仍使用50V直流电压输入,因此在计算机柜中必须增设一个400V转50V的DCDC降压环节,作用跟之前在服务器机柜中的PSU类似,因此在上图中也被称为PSU。另外,由于单机柜 功率 显著增长,液冷开始成为必须

除此之外,在HPR V3、V4等供电架构中,电源柜还需要使用液冷母线,以规避风冷母线155kW的最 大功率限制。HPR V4中,电源柜到计算柜的母线可被电缆所替代,主要是电压的升高使得电流减小(电源 柜中 仍需使用液冷母线)。总的来看,机柜功率需求的不断增加催生技术方案不断迭代,目前机柜支持功率已从2013年ORV1的12.6kW,提升到了HPR V4的800kW,电压等级从12V上升到±400V(或英伟达主导的800V),HVDC是下一代主流供电方案逐步成为共识。

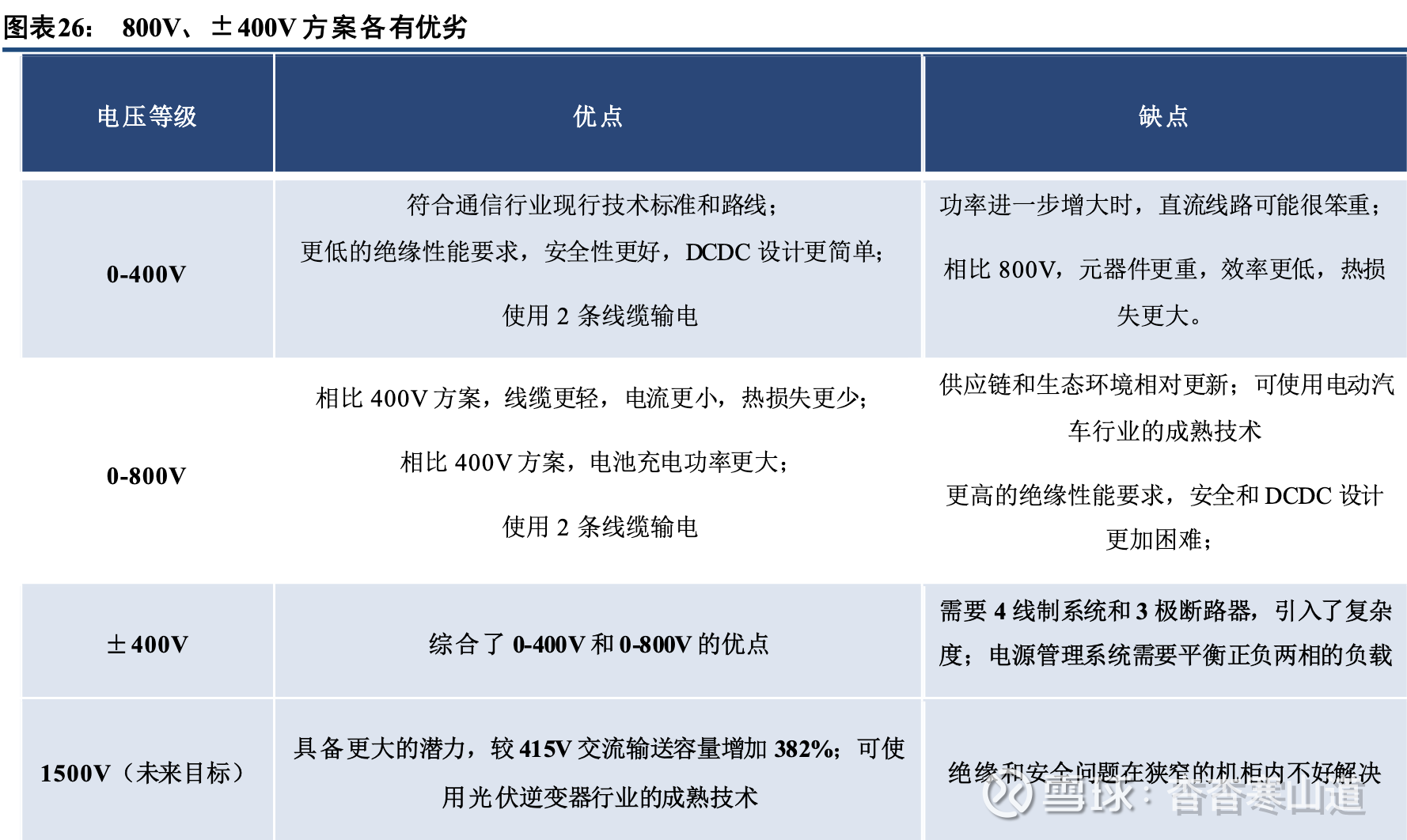

800V/±400V方案各有优劣,但MW级机柜采用HVDC技术趋势不变

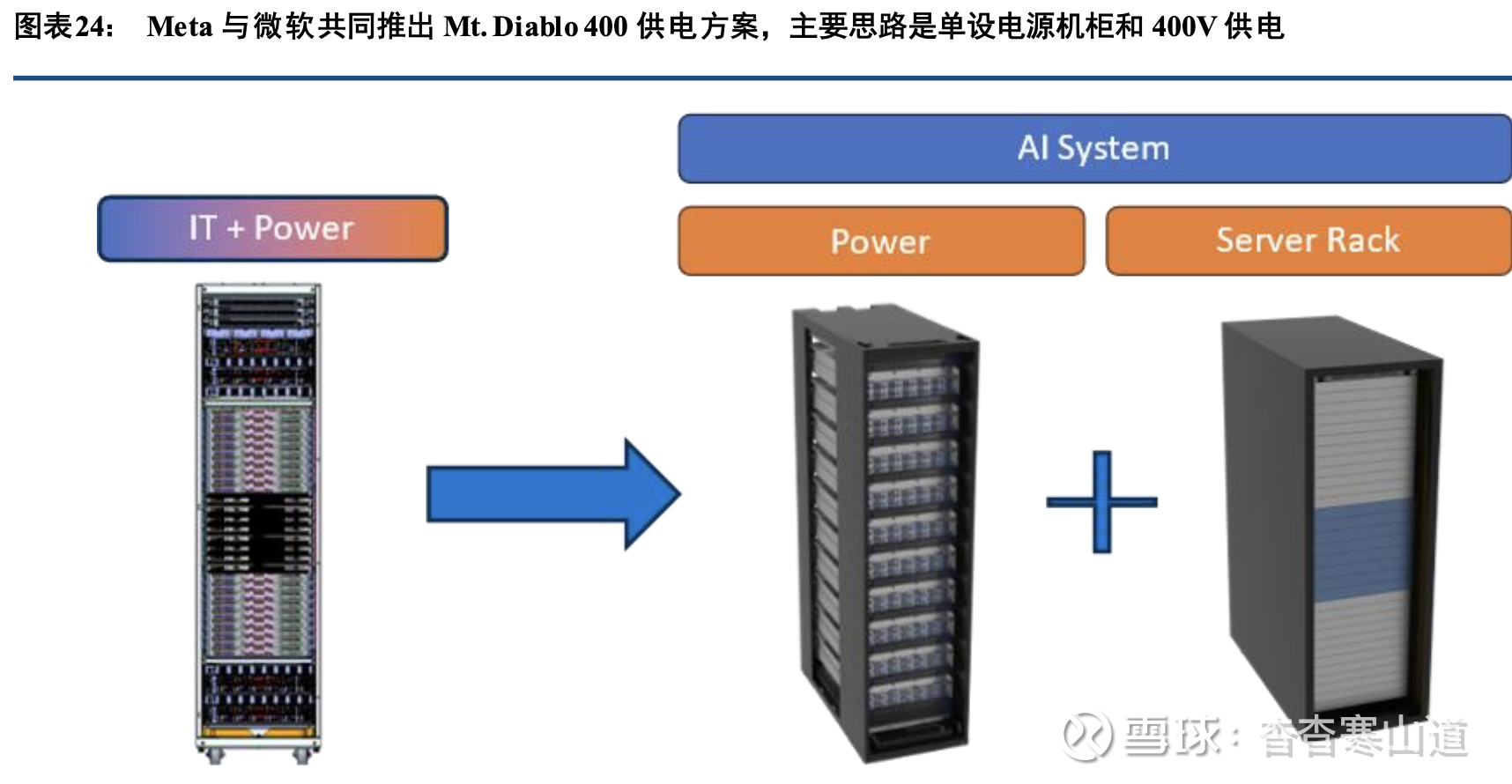

同为OCP成员的Meta和微软合作提出了Mt. Diablo 400供电方案,旨在将±400V方案标准化。 在Mt. Diablo 400方案中,最主要的改变在于将单个机架拆分为电源机柜和服务器机柜,并将输出电压改为400V(或双极±400V),为此也需要在服务器机架中增设DCDC模块。这与Meta提出的HPR V4方案基本相同±400V高压直流供电方案,事实上,HPR V4可被视为Mt. Diablo 400的第一个实施范例。

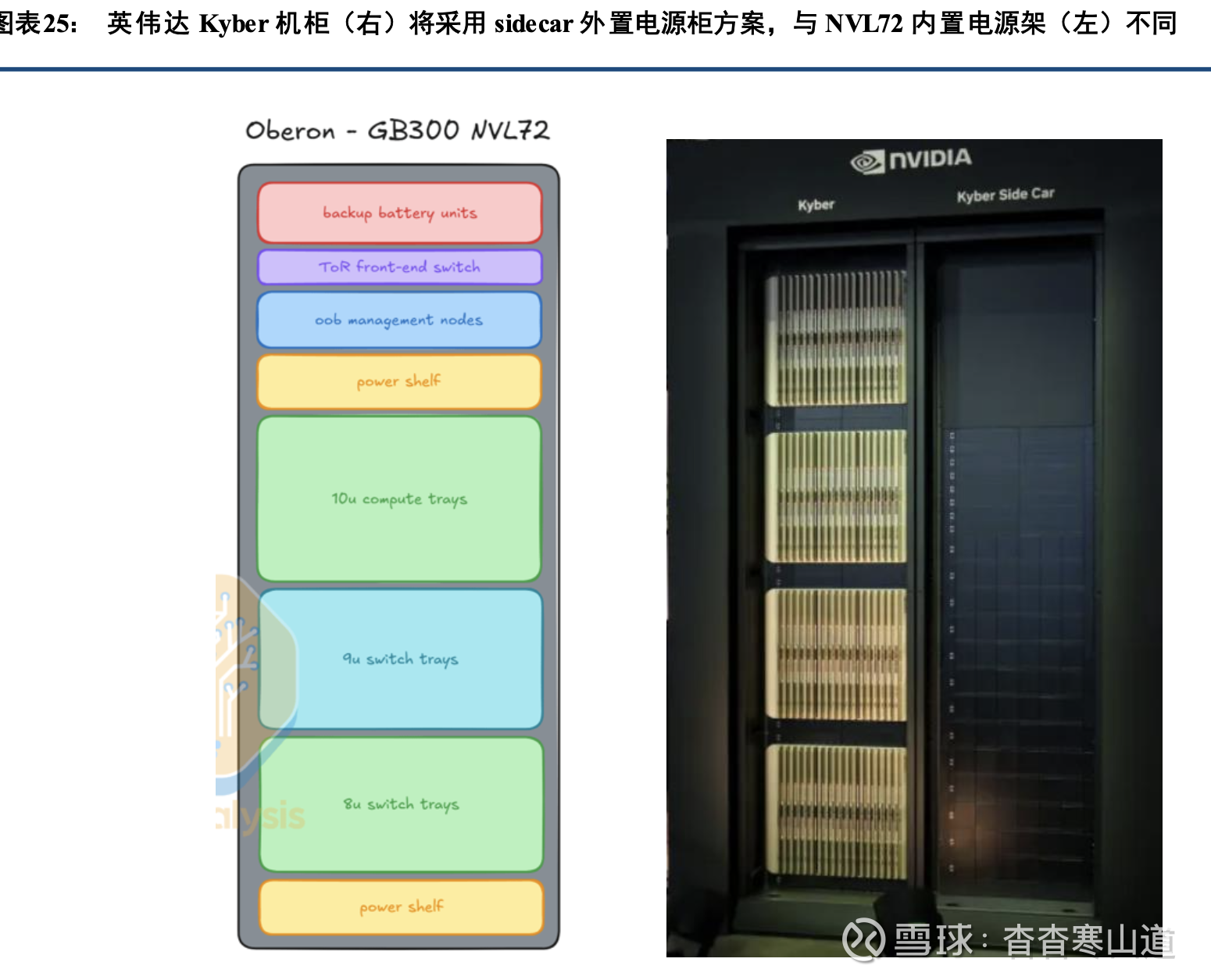

同时,2025年5月20日英伟达在其开发者页面上也宣布了其高压直流供电方案,与Meta、微软不同 的是英伟达采用了800V电压等级。英伟达认为,为了支持2027年开始的1MW级功率IT机架,必须使用800V高压直流供电方案。在MW级的Kyber服务器机架上,如果采用传统50V直流供电,占用空间将达到64U,从而没有放置计算卡的空间。与Meta类似,英伟达在下一代Rubin Ultra芯片上,采用电源、服务器机架分离的方式。包含144个Rubin Ultra计算芯片的服务器机架被称为Kyber,而在旁边邻近放置边柜(sidecar),为Kyber机架提供电源

英伟达800V方案与Meta等提出的±400V方案,主要不同在于是否提供一个中性零点。两种方案各 有优劣,英伟达认为800V方案可以利用成熟的电动汽车产业链零部件,同时仅需正负两根线缆,避免了±400V方案需要零线的问题,但800V入柜后的降压较为困难,需要64:1的DCDC环节。而OCP等组织推荐的±400V方案对绝缘性能和DCDC等环节的设计难度更低,但需要3根线缆供电,并使用4极直流断路器,同 时正 负极之间需要进行负载平衡。未来,英伟达推荐使用1500V直流供电方案,能提供更高的功率密度,但目 前机 柜内的绝缘和安全问题不好解决。

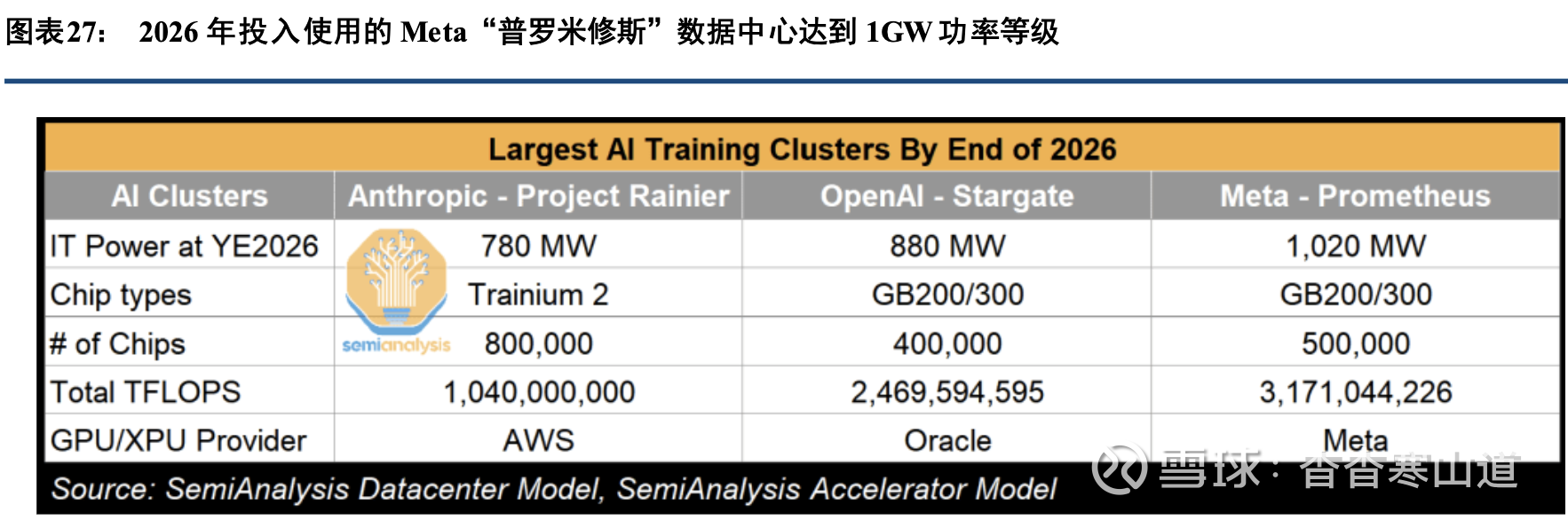

从节奏上来看,由于英伟达800V方案主要是为Rubin Ultra芯片制定的,而采用B200、B300芯片的NVL72机柜供电方案已经确定采用传统的内置Power shelf的方案。因此英伟达800V HVDC方案至少要到2027年Rubin Ultra芯片大规模出货后才能放量,并且可能会被固态变压器SST所取代。Meta提出的“普罗米修斯”数据中心建设方案,预计将于2026年Q1建设GW级数据中心,将使用HPR V4,即±400V HVDC方案。后续Meta还将启动更大规模的数据中心建设计划,2027年底Meta将建成2GW的Hyperion数据中心集群。这些项目有望使用±400V高压直流供电

三、产业链进展和方向:哪些环节有变化?

3.1、一次电源:HVDC/SST主机

SST:难点主要在电力电子变换器和高频隔离变压器

固态变压器又称电力电子变压器,是一种基于电力电子技术与高频电能变换技术的新型电能转换设备 。它通过半导体器件(如IGBTMOSFET、SiC/GaN等)替代传统变压器的铁芯和铜绕组结构,实现电压变换、电气隔离及电能质量控制等功能

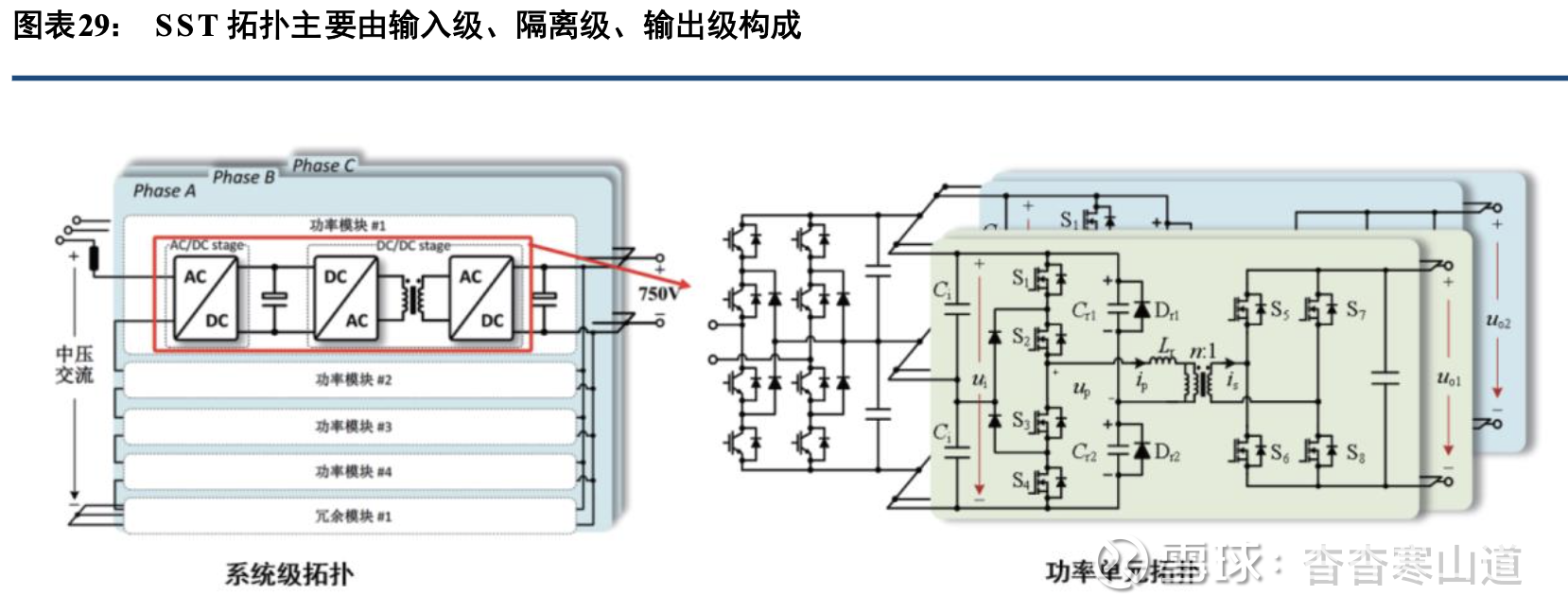

从结构来看,固态变压器供电系统主要由输入级(AC/DC)、隔离级(高频DC/ DC)、输出级(DC/ D C)三级结构构成。各环节作用分别为:1)输入整流AC-DC,将输入的工频交流电整流为直流电,提供 稳定 的直流母线电压。通常通过脉冲宽度调制(PWM)技术实现电压的初步调控,将高压工频信号转换为高频信号。2)DC-DC/隔离,通过高频变压器实现电气隔离与电压等级变换;将直流电压通过高频DC-AC逆变电路 转换 成高频交流电,驱动高频隔离变压器将高频交流电整流回直流电。有些拓扑采用高频隔离DC-DC技术实现 电压 变换和隔离。3)输出逆变,通过电力电子变换器,逆变为所需的工频(或其他频率)交流电压给负载供电 。对 于直流输出的应用场景,可以简化或省略此环节

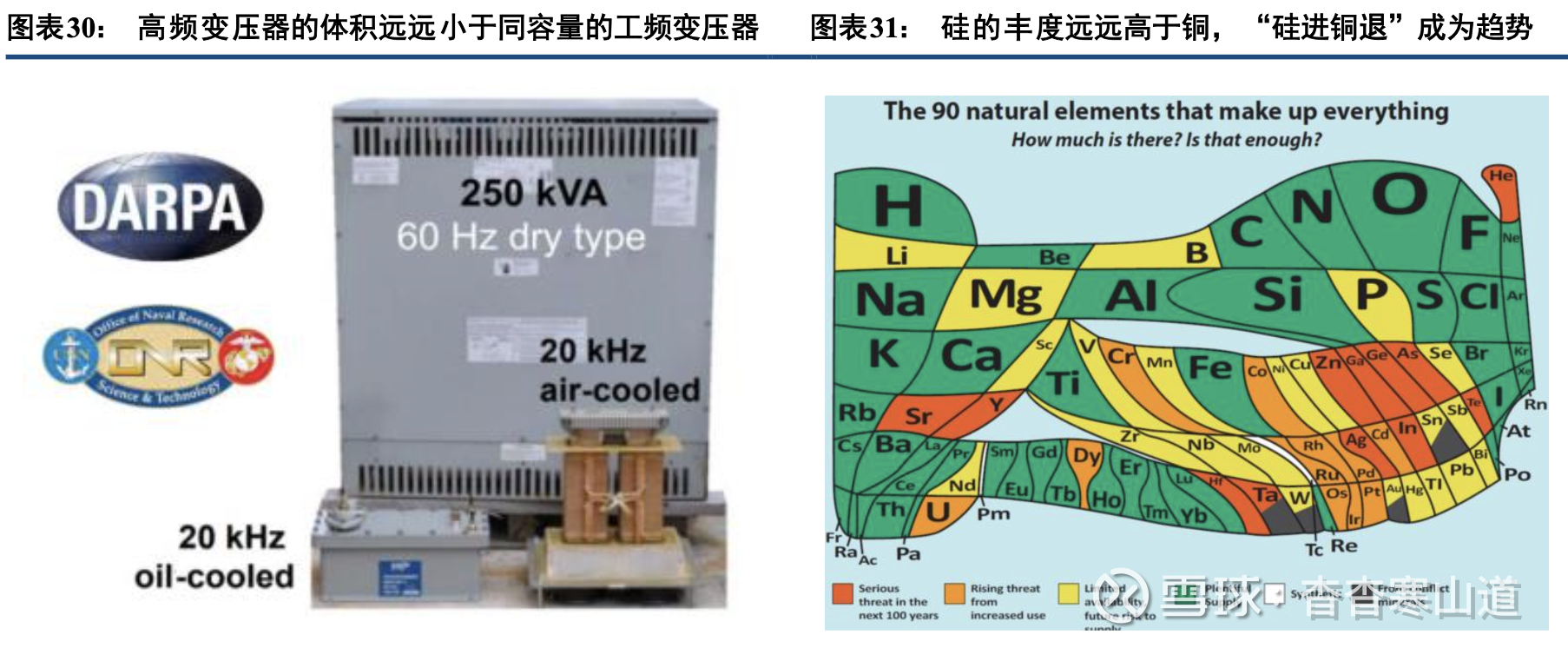

SST之所以能实现体积重量的大幅减轻、提升效率和可靠性、实现故障隔离等功能,关键在于用高频 开关技术替代了传统的工频(50/60Hz)电磁变换,在同样的磁通密度条件下,高频变压器的体积相较工频 变压 器可以大幅缩小。隔离级中的高频变压器是最核心、最关键的零部件,也是技术难度最大的环节

由于硅在地壳内的元素丰度远远高于铜,通过使用高频变压器代替工频变压器可以大大减少铜的 使用 量,从而规避近年来逐步高涨的铜价,也能部分解决目前变压器产能不足的问题。中压高频变压器在SST中起着十分关键的作用,首先能提供一二次侧之间的电气隔离,并实现中压输 入到低压输出的变换,是能量双向传输的通道,直接决定整个系统的功率容量和传输效率,并影响整个系 统的 功率密度、效率和成本,决定了系统的上限。

中压高频变压器的技术难度较大,需要解决:

(1)高频绝缘问题:高频下绝缘材料更容易产生局部放电,从而加速绝缘老化并导致击穿。需采用特 殊的绝缘材料和工艺。(2)新型磁性材料:传统硅钢片在高频下涡流损耗大,必须使用软磁铁氧体、非晶合金/纳米晶合金或 磁粉芯等高频低损耗材料。(3)散热问题:随着频率升高,磁芯中的铁损和绕组趋肤效应导致的铜损都会急剧增加,但变压器体 积大大缩小,因此发热密度大大提高,导致散热困难。

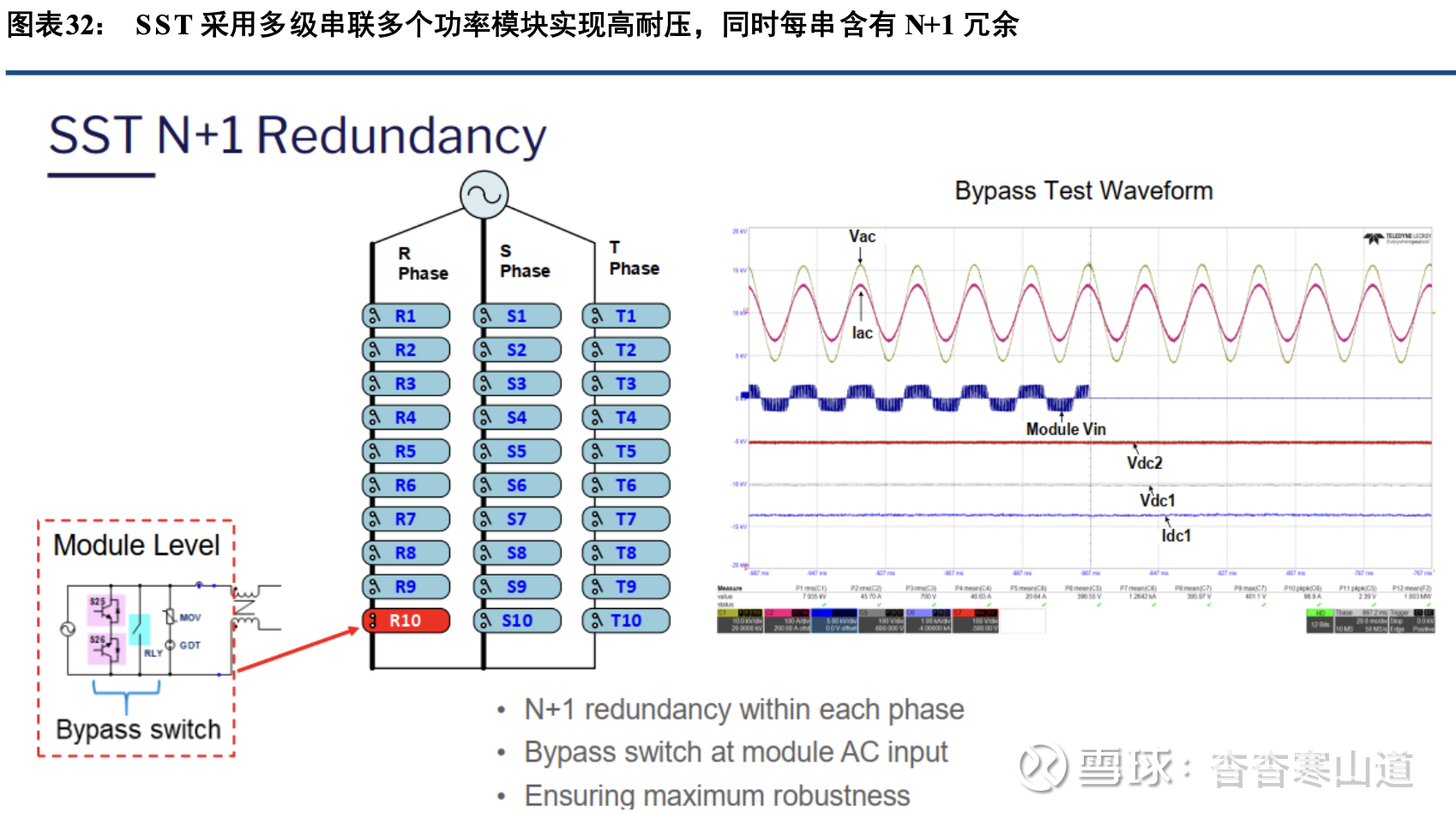

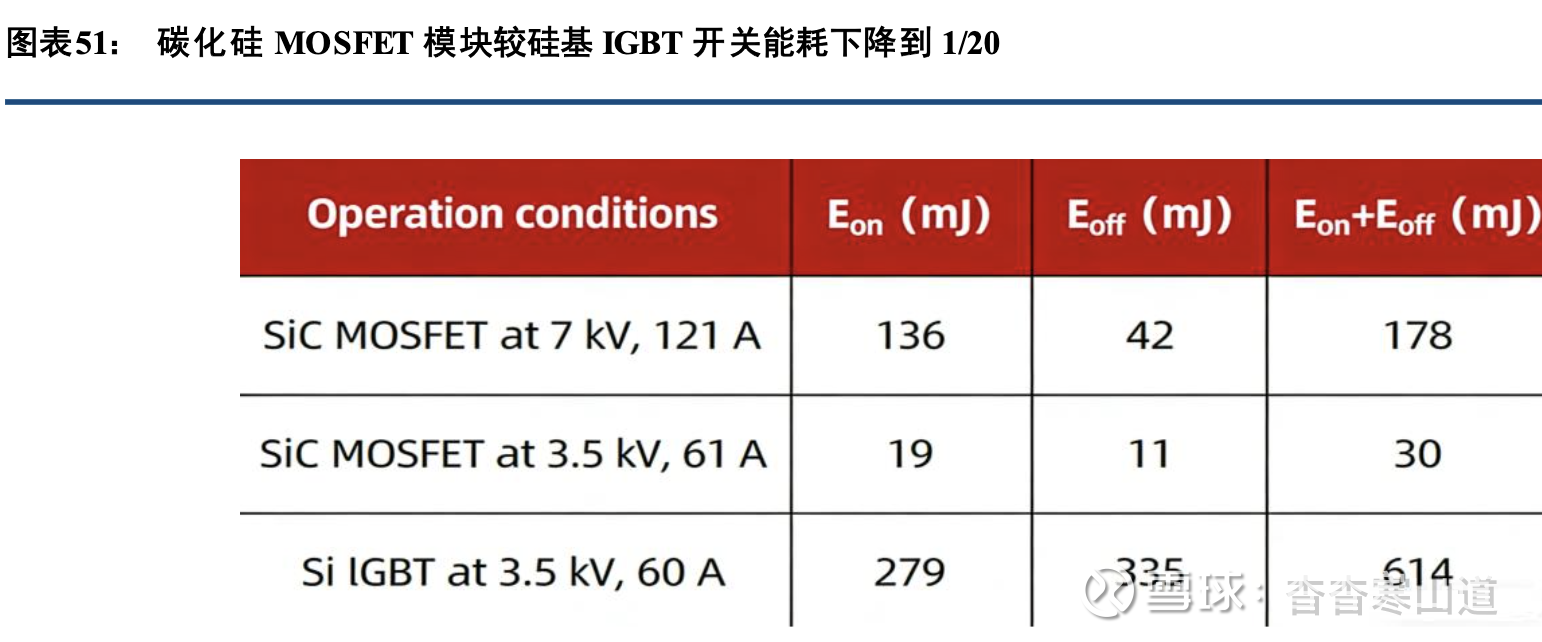

需搭配散热系统,包括散热器、风扇、柜体、液冷系统等而对于电力电子变换器,技术难度主要在耐压,因必须直接面对中压(10kV级别,如13.8kV甚至35kV)的交流电。解决方法一是需采用第三代宽禁带半导体材料,如IGBT,SiC MOSFET, GaN HEMT等,Si基I G BT耐压最高可达6.5kV,而SiC MOSFET耐压可达10-15kV,同时可降低开关导通损耗、优化系统性能;二是 采用多级方案,类似于高压级联储能,将功率模块进行串联,提高系统耐压能力

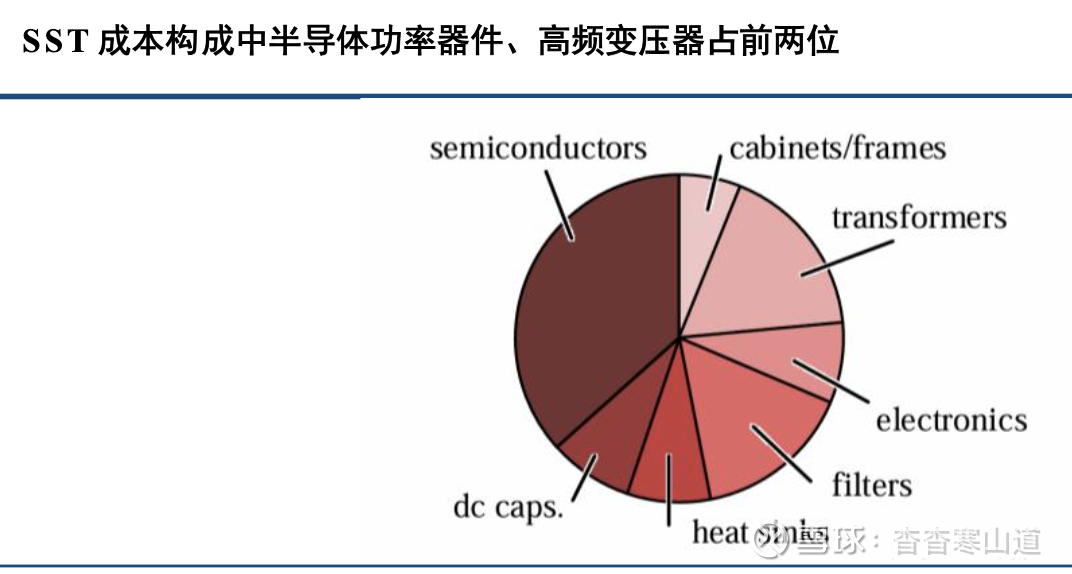

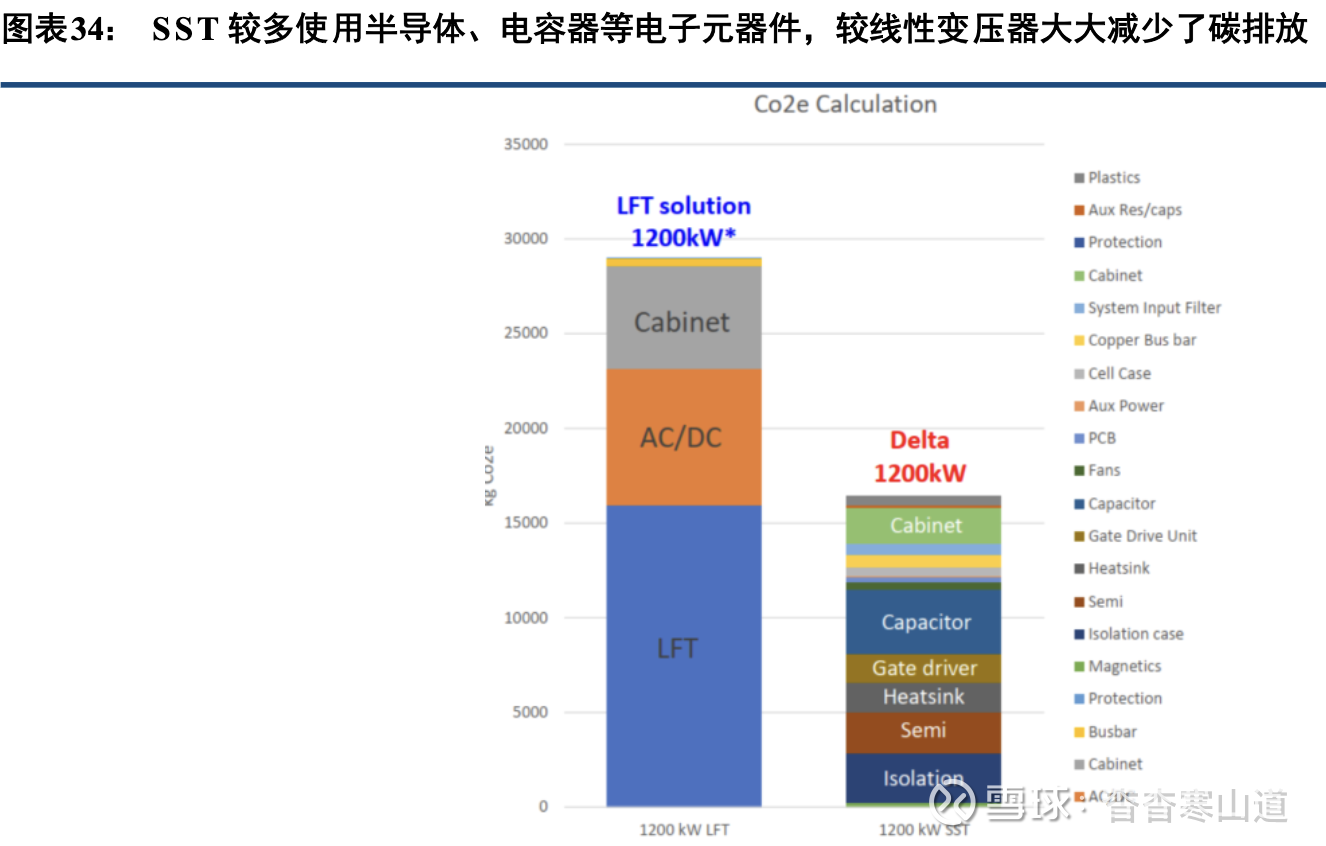

从成本拆分来看,固态变压器成本主要由功率半导体、高频变压器、直流电容、散热系统等组成。其中 ,功率半导体器件成本占比达到30-40%,高频变压器成本占比10-20%;半导体器件、高频变压器为SST核 心器 件

功率半导体器件在高压高频场景中优先采用SiC MOSFET。SiC MOSFET优势在于在高压高频下,具 备更低的开关损耗、高dv/dt能力可显著降低总损耗、提升效率,并具备体积优势。相较于GaN耐压能力 更强 。因此综合考虑下,SST系统中的半导体器件以SiC MOSFET为优选。

高频变压器成本包含磁芯(铁氧体、纳米晶、非晶合金等)、绕组铜线、骨架/线包框架、绝缘材料等。高频变的性能、效率和可靠性很大程度上取决于所使用的磁芯材料。铁氧体、纳米晶和非晶合金等先进 材料 更受青睐,优势在于:①低涡流损耗。铁氧体和非晶态材料的高电阻率可最大限度地减少产生热量的循环 电流 。②高磁导率。确保磁通量集中并在绕组之间有效传输。③减少磁芯损耗。低磁滞和涡流损耗可提高整体 效率 。④紧凑的尺寸:这些材料使得变压器更小、更轻等。

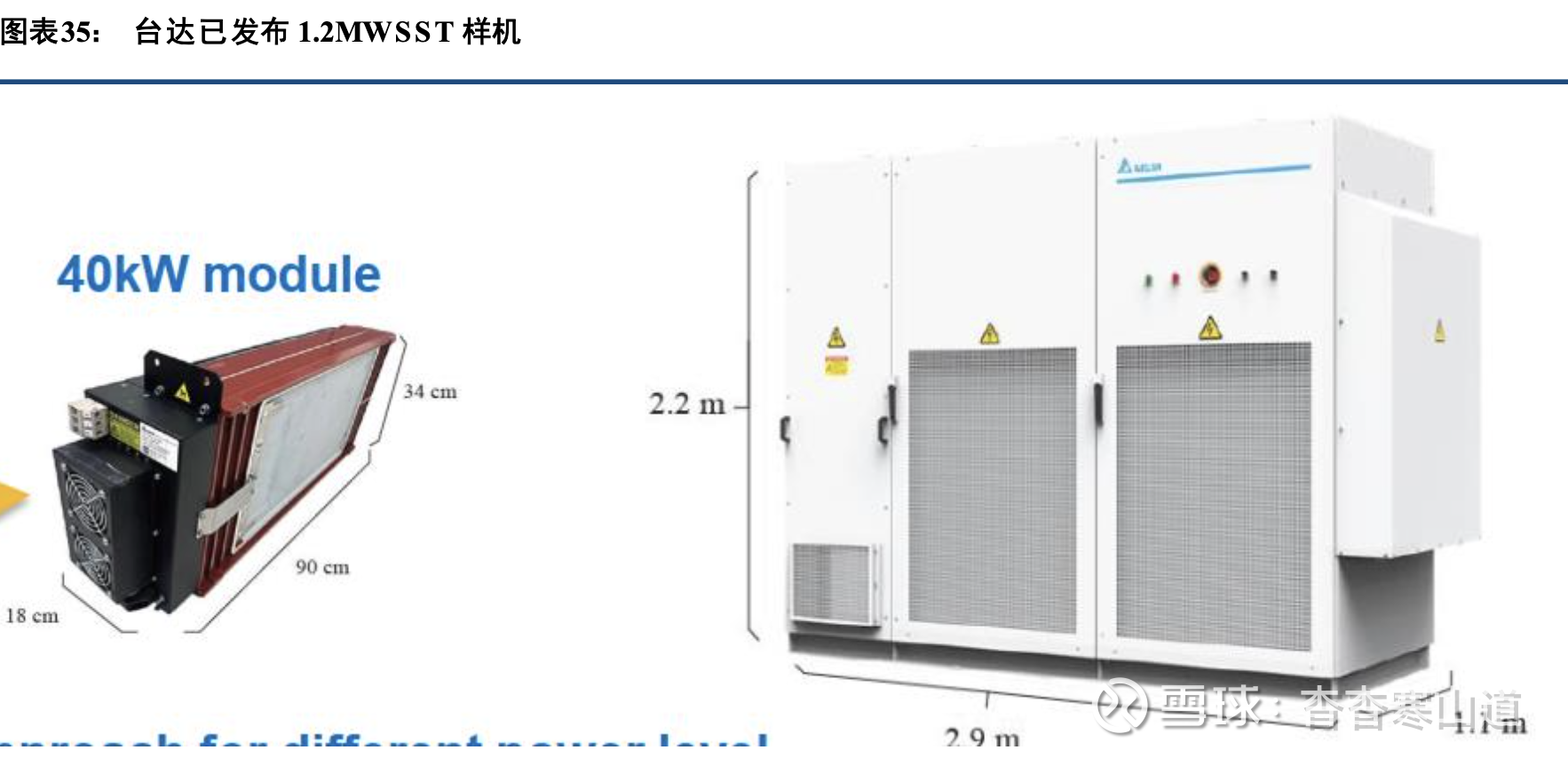

台达已发布1.2MW样机,通过30个40kW模块实现13.8kV交流直接转400V直流输出。西安西电电 力电子公司曾交付SST的试点产品,具备10kV交流输入直接输出240/336V直流的能力,额定容量达到2. 4M W。SST今年将陆续进行前期的供货的试验工作。由于存在电压制式及拓扑器件成熟度问题,在可靠性, 可维 护性及使用规范方面面临着挑战,现在仍以试点为主,需要业界产品生态的进一步完善.

HVDC主机:边柜(sidecar)和集成化成为趋势,模块功率不断提升

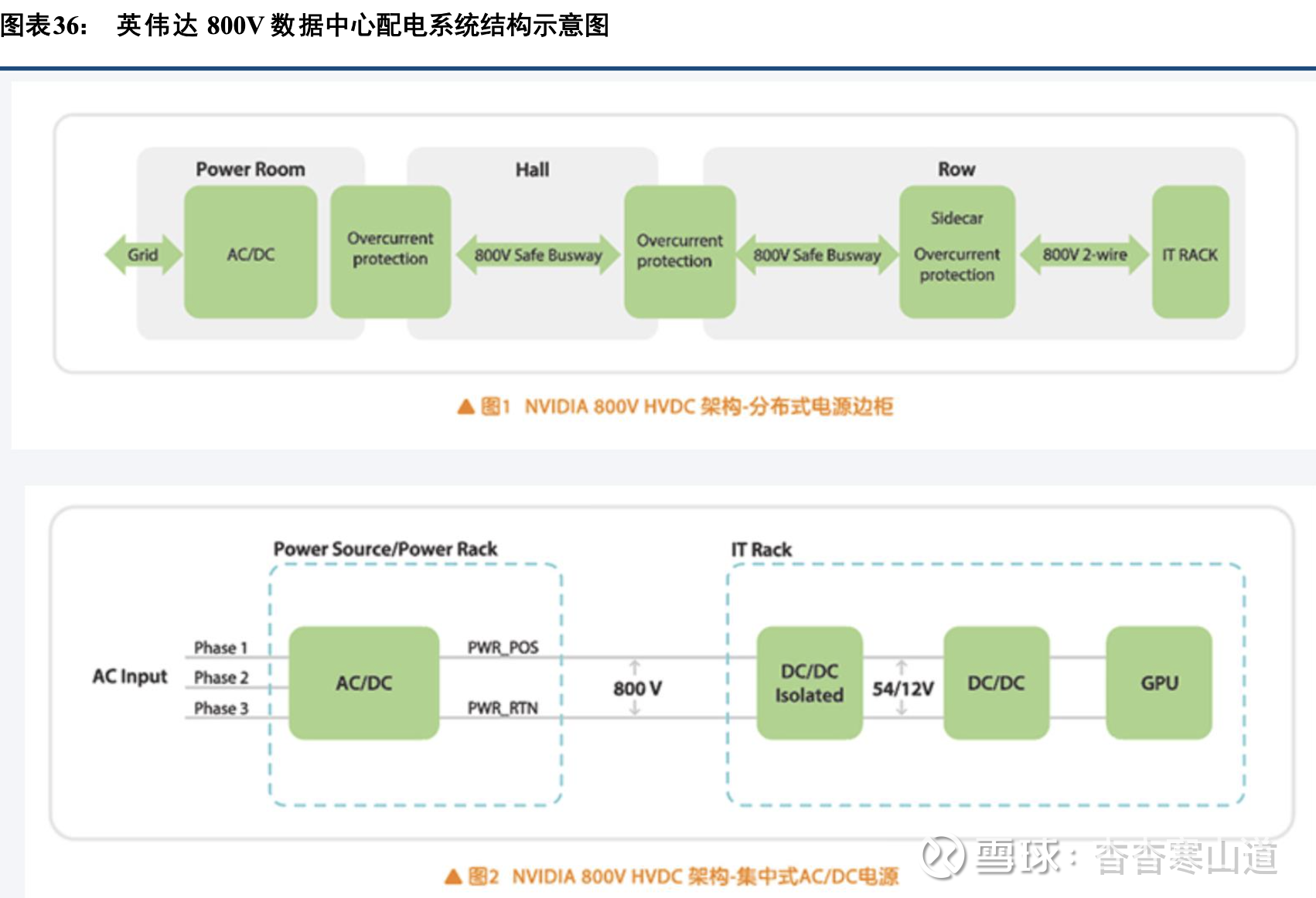

HVDC系统已明确向800V等高压化迈进。英伟达明确提出未来800V HVDC架构,产品形态包含两 类,1)分布式电源边柜Sidecar,内置储能锂电BBU和超容CBU,输出800V HVDC,且至少末端的800V HVDC是稳电压输出。2)电源间放置的直连电网的集中式AC/DC中压直流电源,输出800V HVDC,Server输 入电 压为800V,两级DC/DC转换为54V/12V至GPU。同时整个供配电链路包括直连电网的集中式AC/DC电 源、 新型过流保护装置、800VHVDC安全母线(金属屏蔽层+惰性气体密封)、分布式电源边柜Sidecar,为邻近 的IT机柜提供800V HVDC供电

HVDC系统的电源模块而言,主要由功率器件与功率模块、磁性元件与电容、检测/控制与监控、配电、机柜与内部铜排/布线等单元组成。高压电源架构中,断路器、熔断器是配电单元中必不可少的器件。在800V高压化趋势下,超级电容、BBU等电力电子器件亦成为必选项

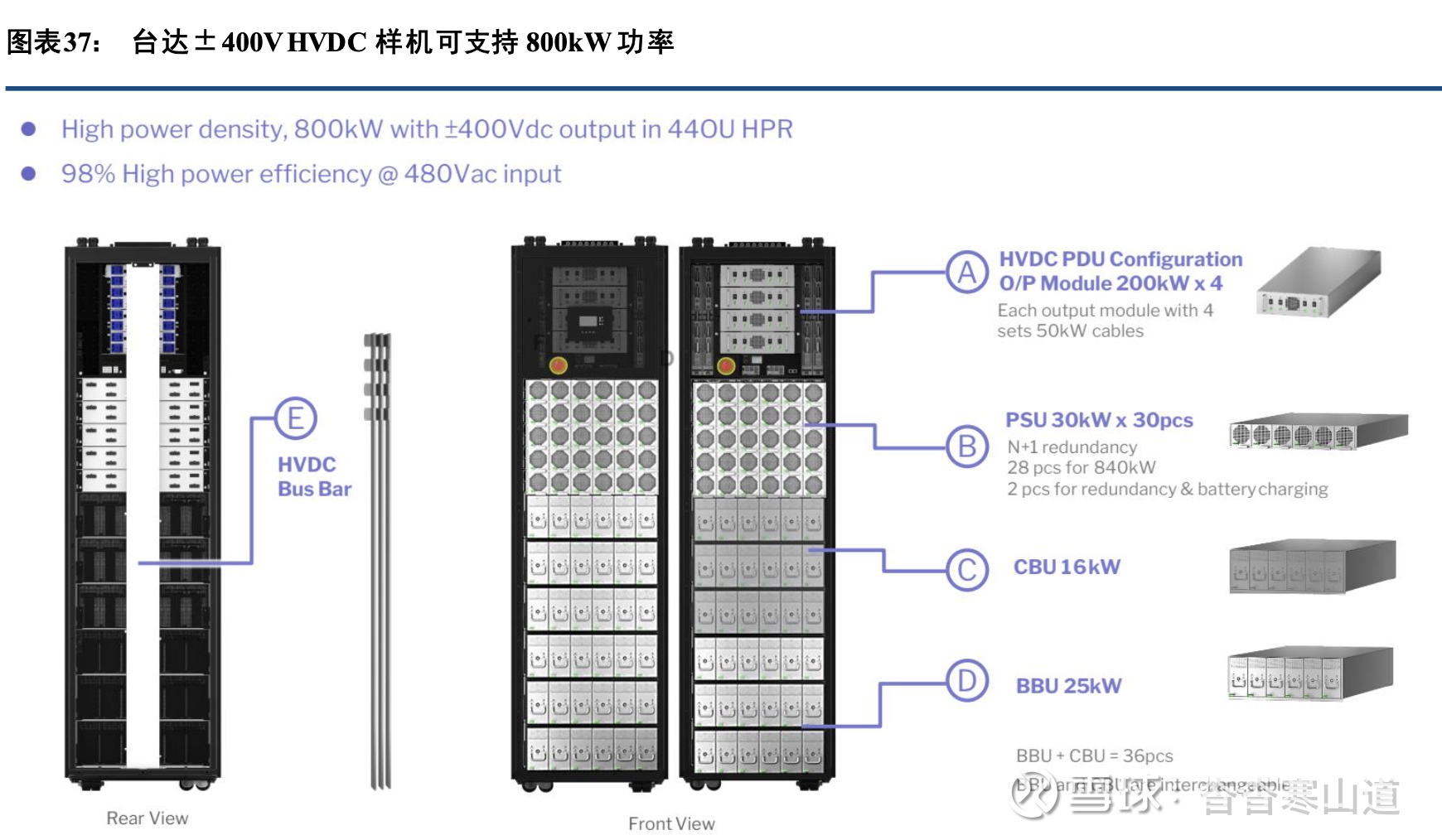

以台达推出的符合HPR标准的HVDC样机为例。该样机包含4个输出功率达200kW的PDU单元 ;30个PSU,每个输出功率达30kW,28个PSU为正常供电之用,另2个PSU用于冗余和为电池充电;此 外还 包含CBU(电容备份单元)和BBU(电池备份单元)共36个,两者之间可视需要互相替换,单个CBU输 出功 率为16kW,单个BBU输出功率为25kW。整台HVDC可输出800kW功率,高度为44OU,输入电压为480V交 流,输出电压为±400V直流,效率达98%,以边柜(sidecar)形式布置在机柜旁,一台HVDC即可解决 所有 的供电、配电、备电、平滑负荷曲线的作用,从而给机柜中的计算设备让出了空间。

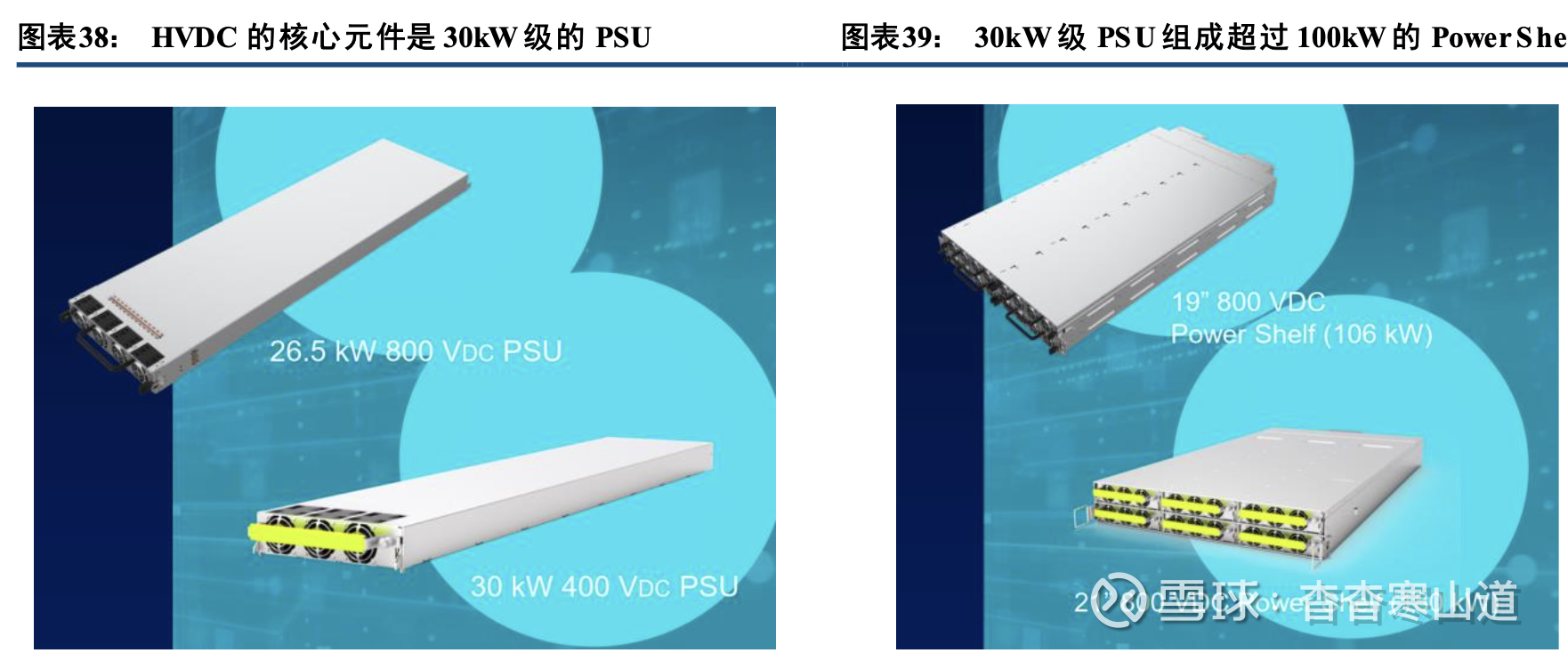

HVDC的技术难点主要在其中的PSU功率模块,执行AC/DC转换功能,目前推出的HVDC样机中的PSU模块单体功率已达到30kW级别,相较目前广泛使用的5.5kW级别的PSU功率密度上有巨大提升,技 术难 度较大。

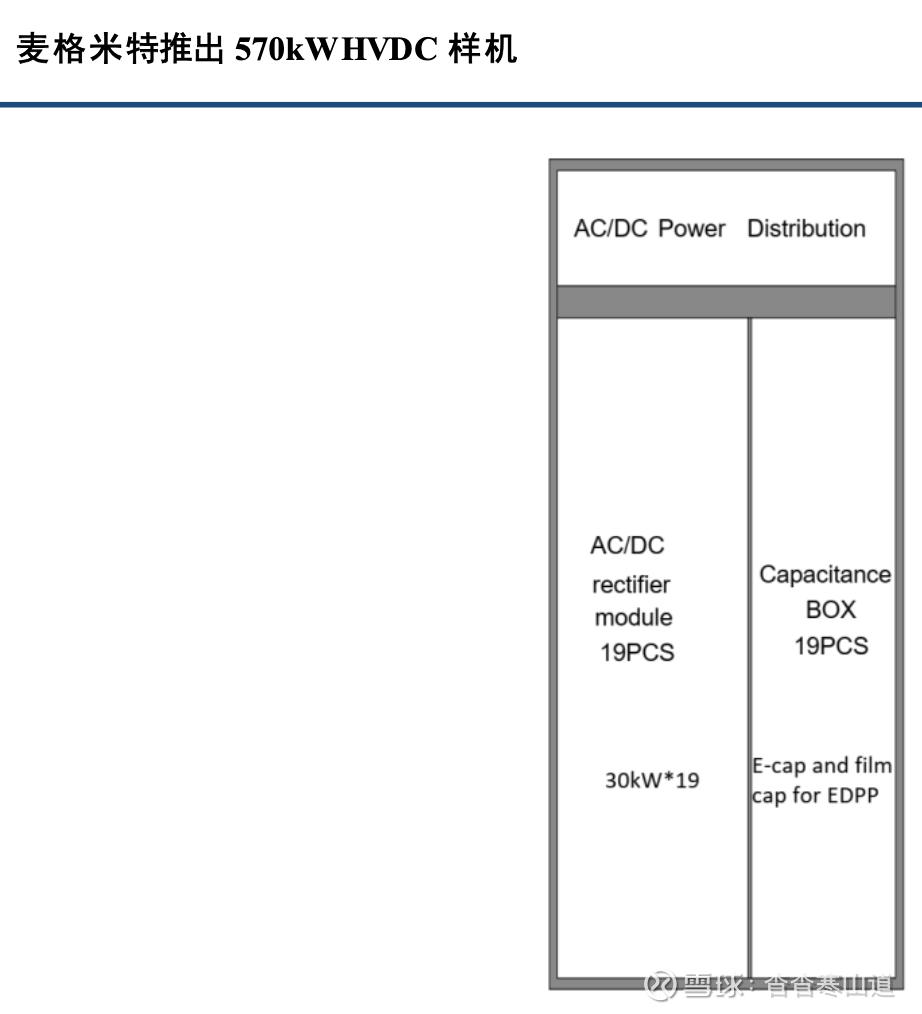

目前,大陆企业也在紧密跟踪HVDC技术趋势,麦格米特在2025年4月的OCP亚太会议上推出了570kW的HVDC样机,包含19个30kW PSU,超级电容、配电部分等

3.2、二次电源:PSU、Power Shelf以及机柜级DC/DC环节

PSU:实现AC/DC的基本单元,由数百W向数十kW级别迭代升级

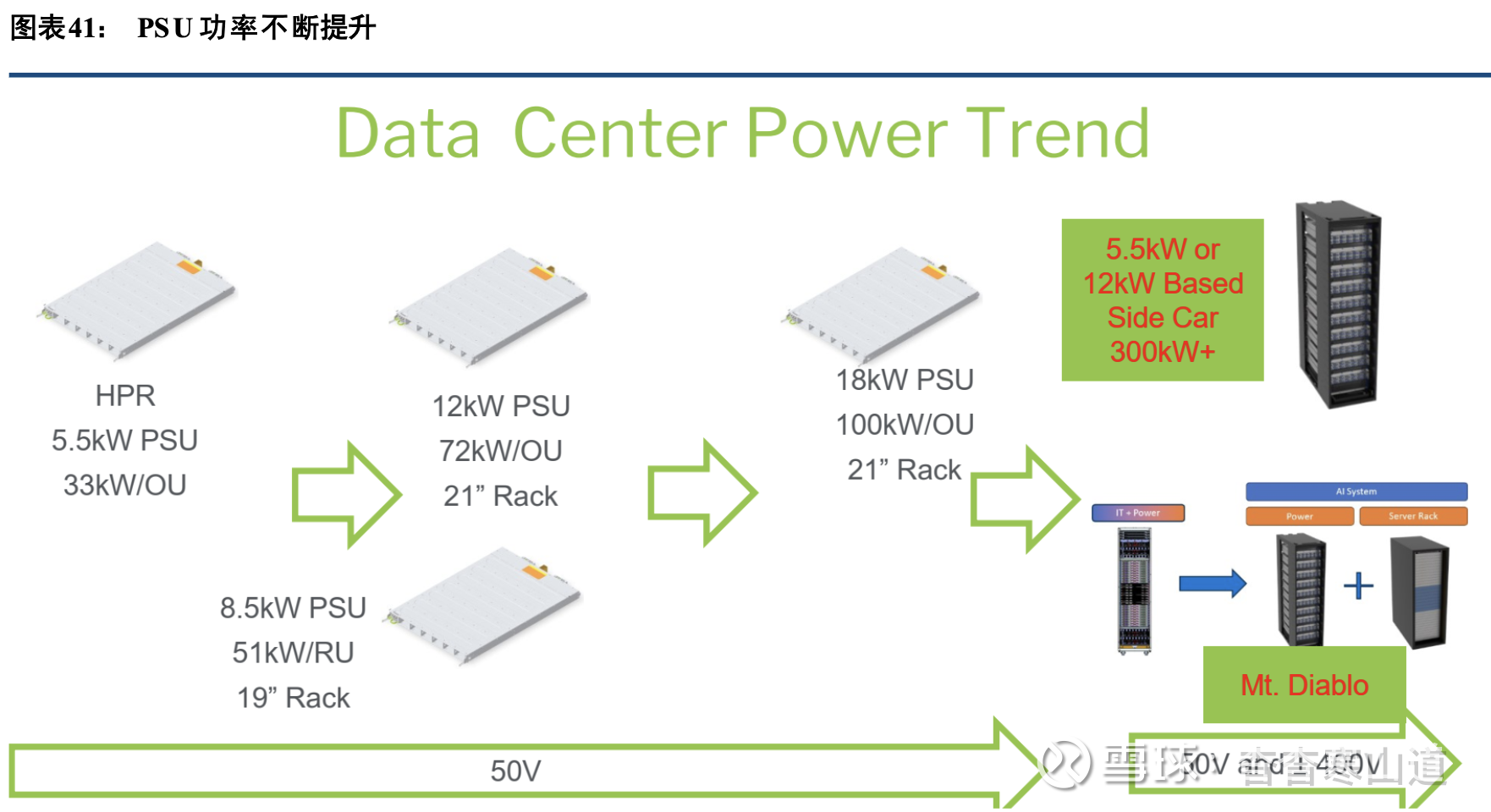

PSU通常指服务器机架上的AC/DC电源,主要将一次电源提供的415/480V交流电降压、整流为50V(当前广泛应用规格),其同时具备降压和整流作用。因为其体积层面受到机架限制较大,伴随服务器整 体功 耗快速提升,其功率密度也需要快速提升。目前采用B200、B300芯片的NVL72机柜,仍然采用5.5kW PSU,6个PSU成组为Power Shelf后功率为33kW。将来,随着HVDC逐渐开始使用,PSU从计算机柜中被挪动至HVDC sidecar中,同时,单体PSU功率水平提升至30kW级别,成组Power Shelf后提升至180kW级别

PSU通常成组使用,称为Power Shelf,如GB200 NVL72上使用了8个33kW Power Shelf,每个Power Shelf由6个5.5kW PSU组成。多个PSU成组可提升供电稳定性和冗余度。而在Vera Rubin这一代芯片的NVL 144机柜上,将升级至6个66kW Power Shelf

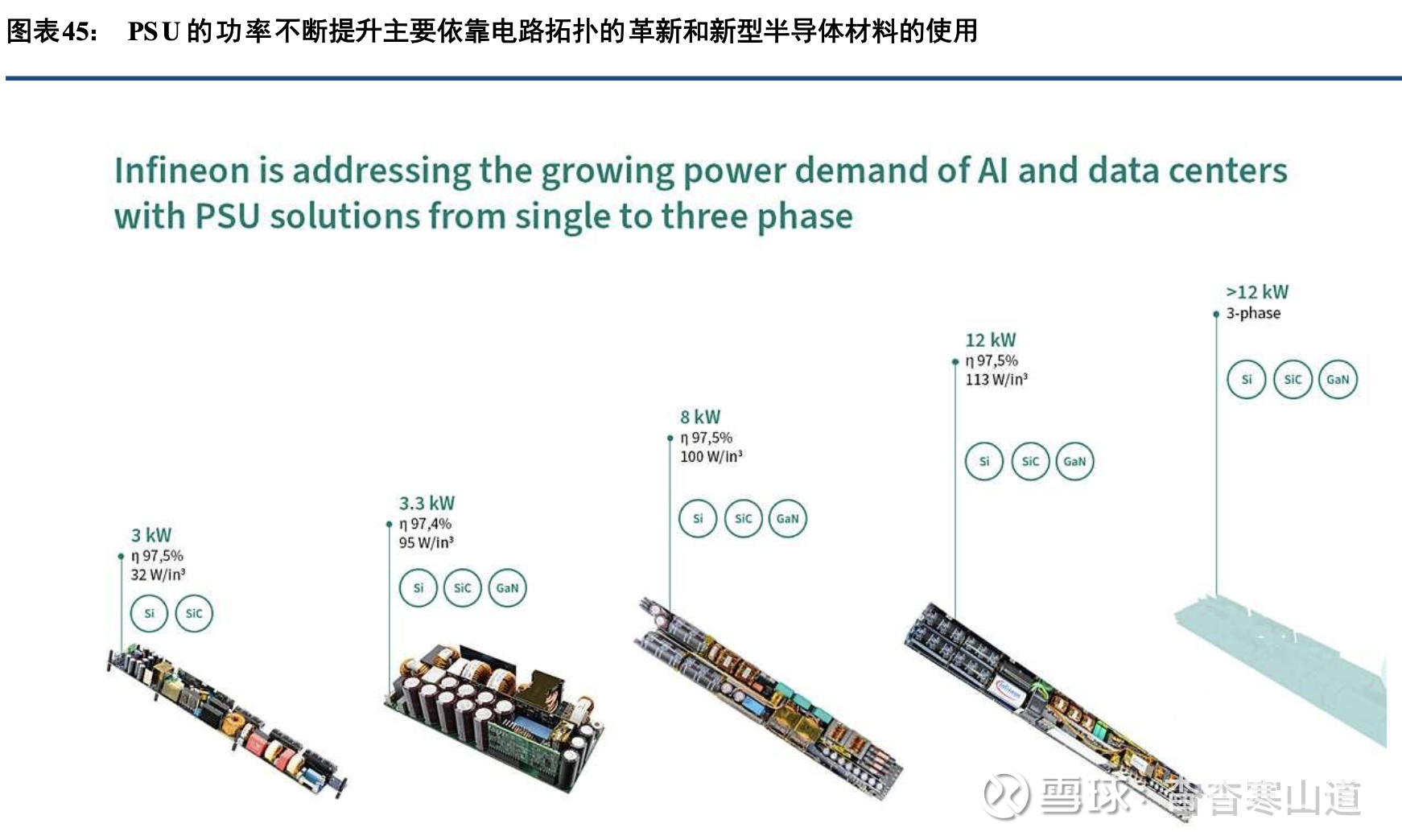

复盘ORV1到ORV3,再到HPR V1到HPR V4的产品迭代过程,我们可以发现PSU单体功率越来越 大,且能量转换效率越来越高。受限于机架尺寸,更好的材料、更优的拓扑、更多的集成是功率密度提升 的主 要途径,而较为集中市场格局与稳健的毛利率上升则确保了从成本到价格的路径传导,并直接带来电源在 服务 器整机中的价值量提升

PSU需要在体积受限制的情况下,实现功率提升,主要迭代路径是:(1)采用SiC、GaN为代表的宽 禁带半导体取代硅基半导体;(2)采用新型电路拓扑结构

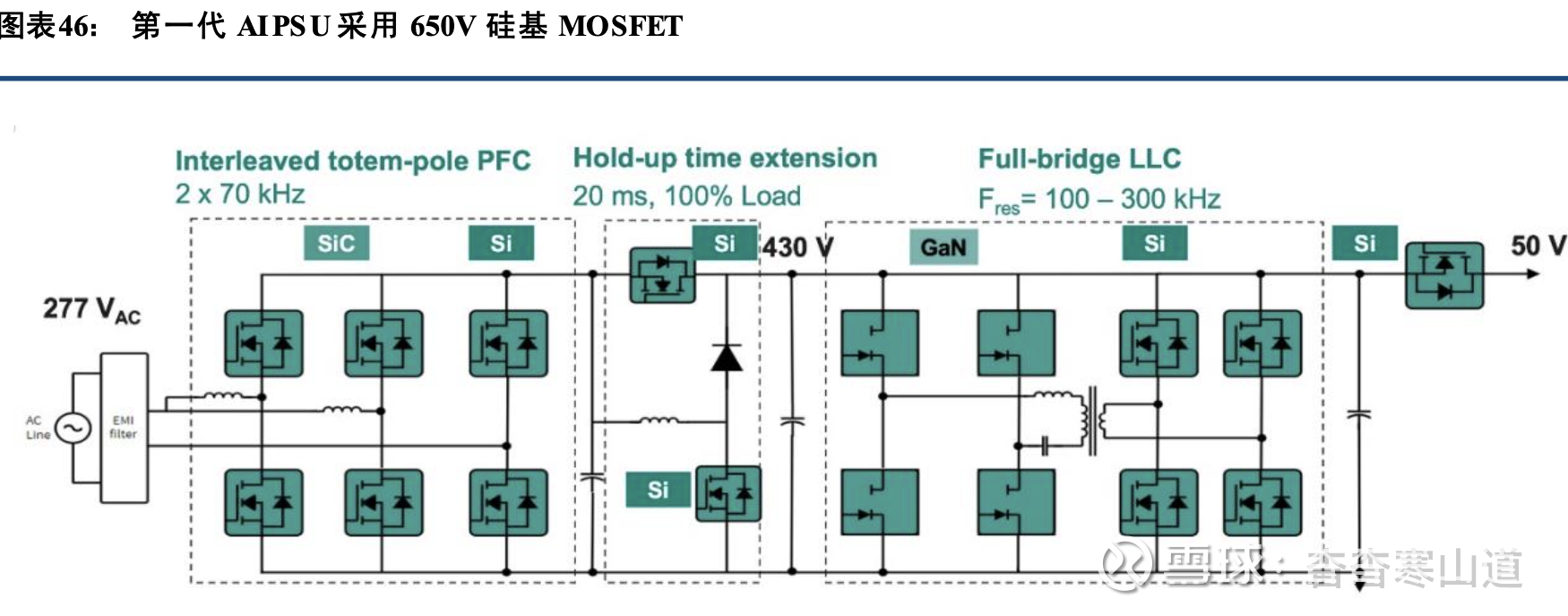

(1)采用更新的电路拓扑第一代AIPSU大多遵循ORV3 HPR标准,功率为5.5-8kW,采用277V 交流输入、50V直流输出。尽 管每个Powershelf都通过400-480V交流三相输入,但每个PSU的输入仍为单相(230-277V交流)。在第一 代AI PSU中,输入级采用两个交错的图腾柱拓扑结构,采用碳化硅MOSFET和硅基MOSFET混合形式; 次级 全桥整流器使用硅基MOSFET。

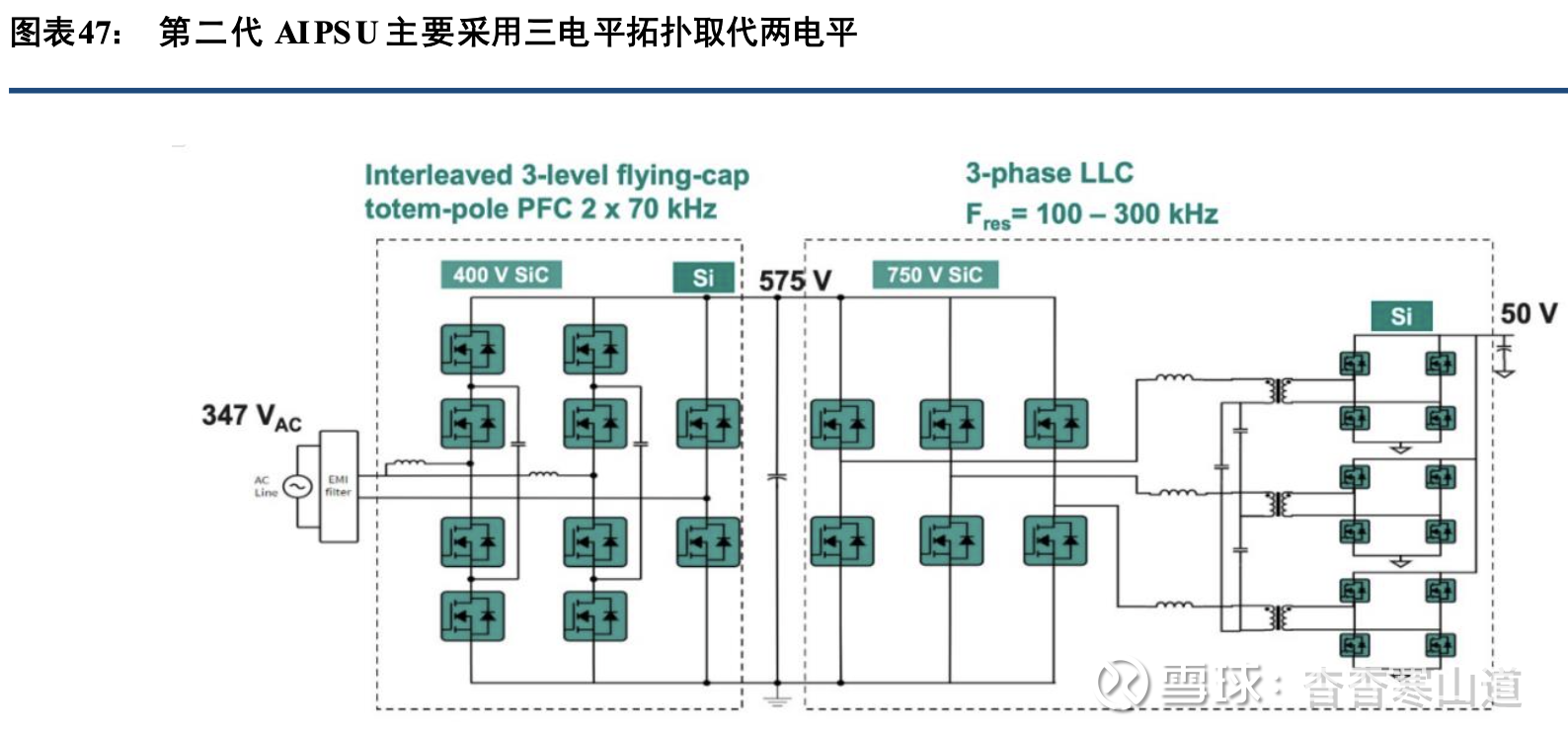

第二代PSU应对机架功率增加到300kW以上的情况,PSU单体功率提升至8-12kW,仍采用单相交流 电输入,但电压等级从400/480V提升至600V,而输出仍保持50V直流。此时由于输入电压升高,输入级PFC的输出电压也提高到575Vdc,传统650V器件的耐压无法满足要求。因此第二代PSU采用400V 硅基MOSFET的三电平飞电容图腾柱PFC,能够使用较低额定电压的开关器件的同时,支持更高的输入电压。输出级则采用750V硅基MOSFET,并采用全桥输出级

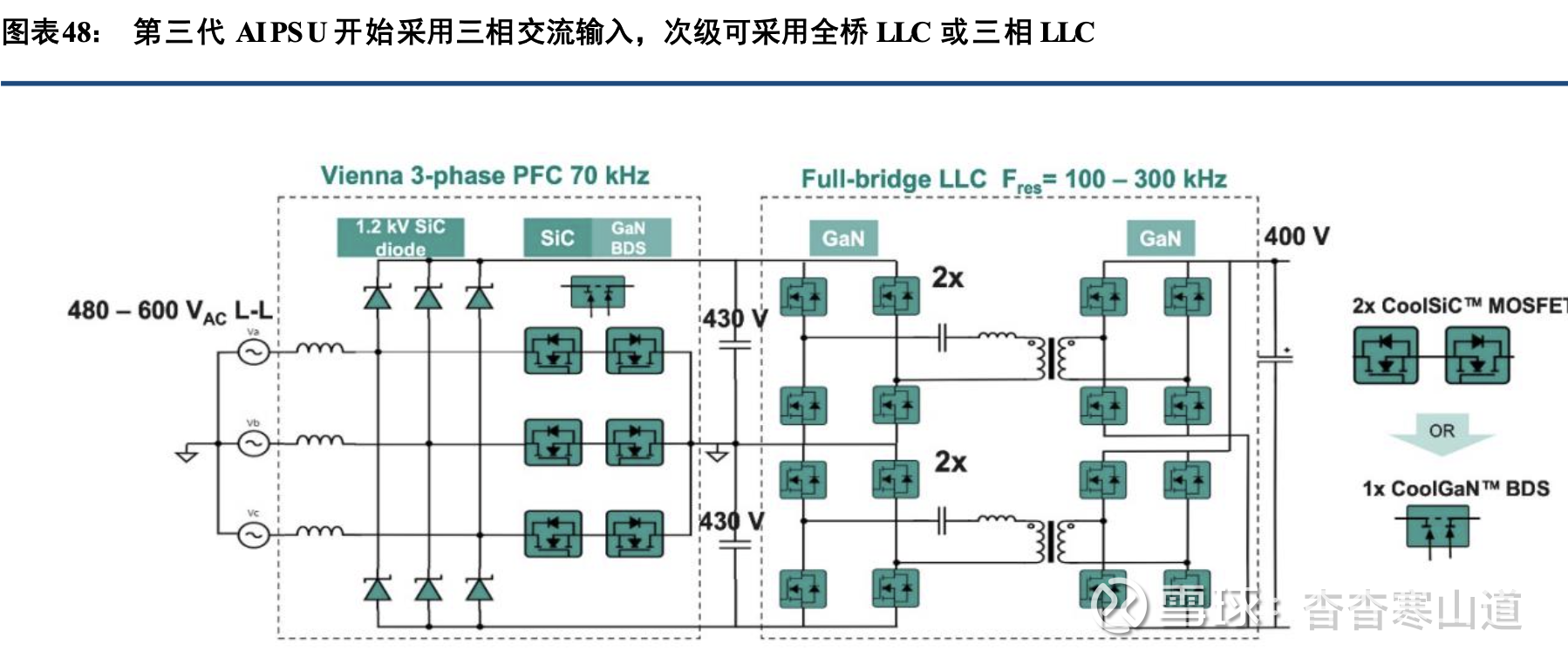

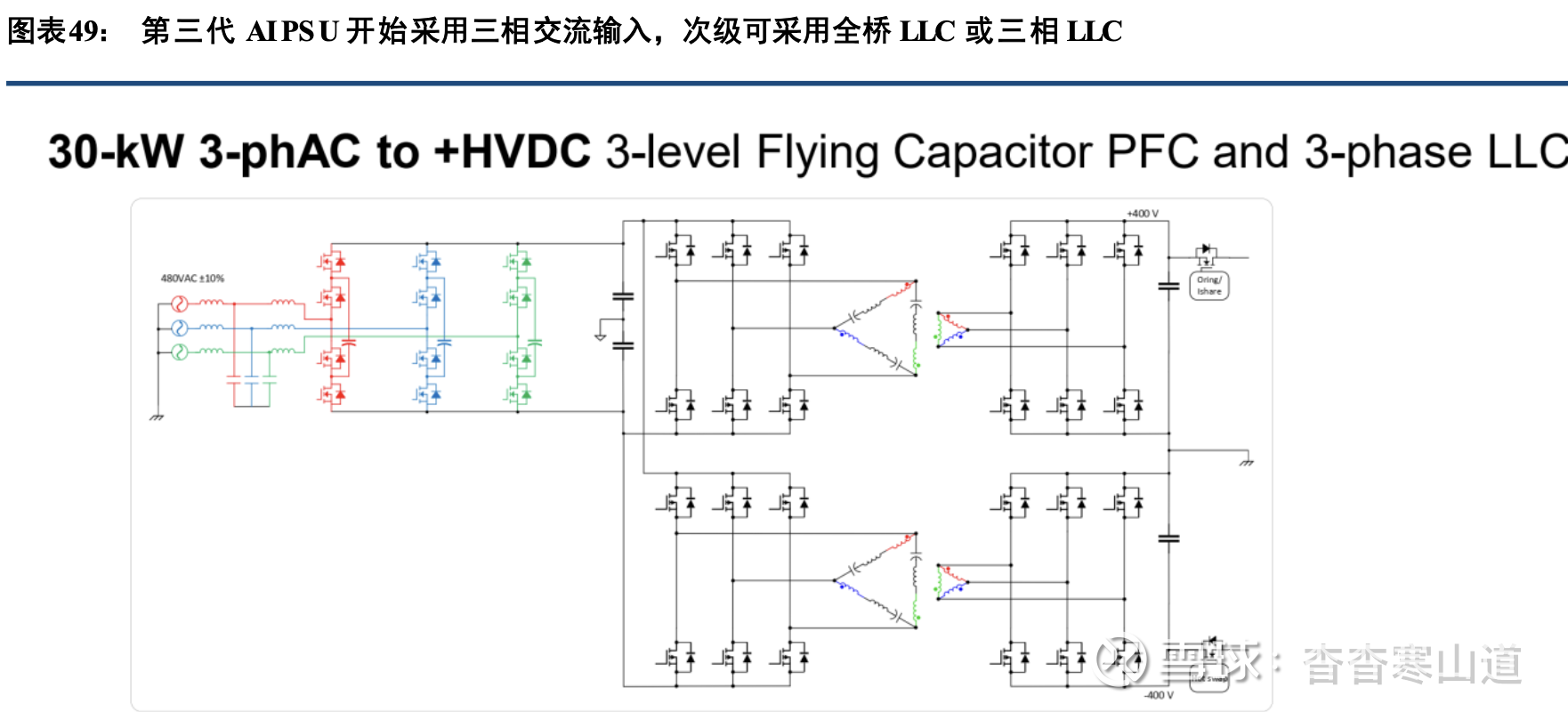

为了进一步支撑更高的机架功率,第三代AI PSU最高功率达到22kW,采用三相交流480-600Vac输入 ,同时采用400Vdc输出,以降低母线电流、损耗和成本。PFC输入级采用Vienna整流器,采用650V 碳化硅MOSFET和1200V碳化硅二极管。输出采用两组430V电容器,为全桥LLC转换器供电,在初级和次级均使用650V GaN晶体管

对于800V HVDC系统,其实现AC/DC转换的PSU模块通常采用三相Vienna输入级(PFC),将400V交流电转换为800V交流电,再通过三相隔离式输出级(LLC)将800V交流电转换为800V直流电。输入级(PFC)采用三电平结构,可以提升耐压能力和减少纹波。输入级(PFC)可采用耐压1200V的SiC二极管,输出级(LLC)采用耐压650V及以上的GaN元件,可以实现低导通电阻和高开关频率,减少损耗,提升转换效率

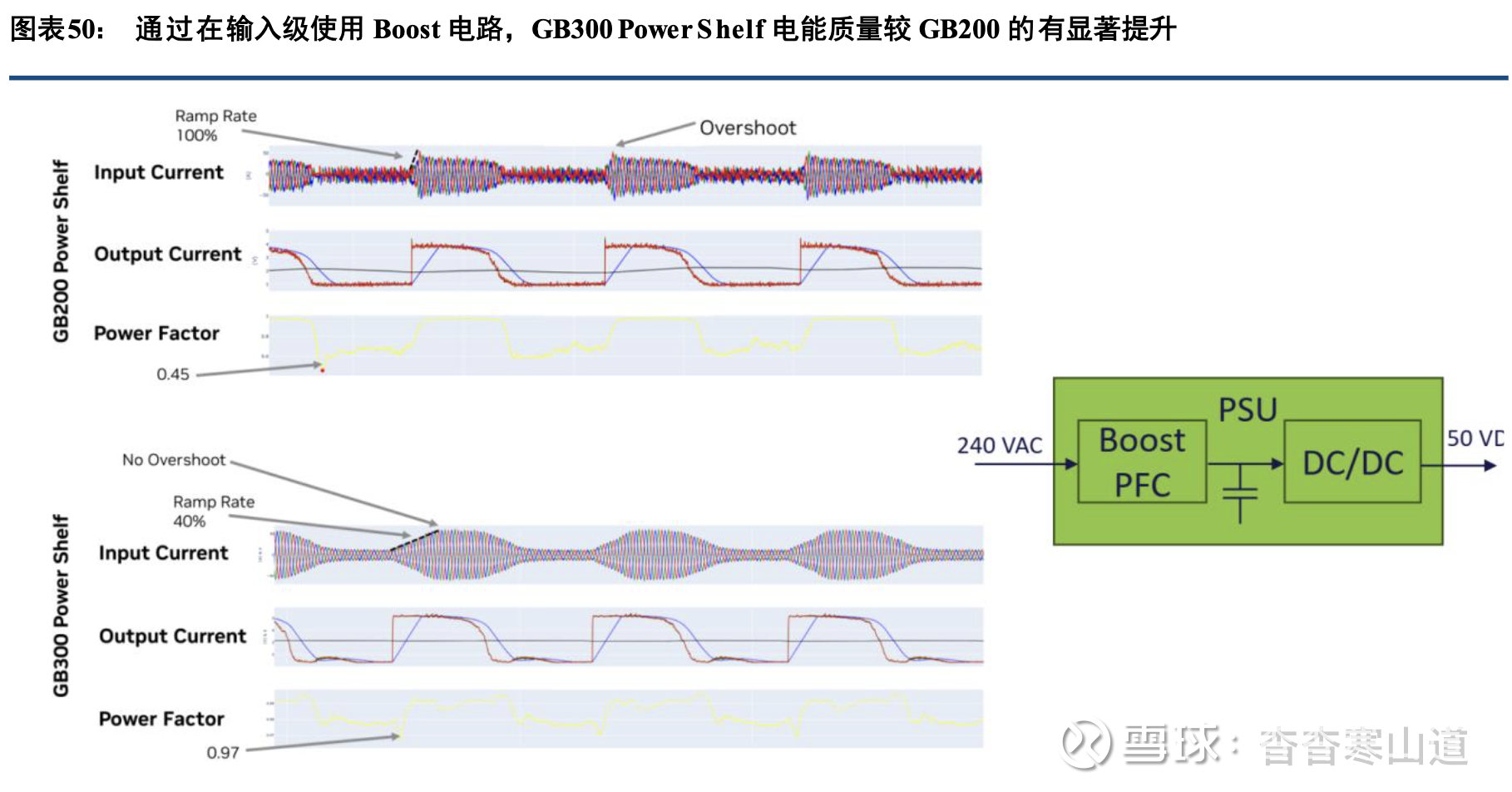

此外,随着芯片功率的提升,对PSU输出电源电能质量的要求也在提高。根据英伟达800V供电白皮 书,通过在PSU输入级(PFC)使用Boost电路,大大减轻了输出电流波形的过冲现象,同时将电源功率因数从0.45提升至0.97。

2)采用宽禁带半导体

功率器件与功率模块在HVDC系统中起到至关重要的作用。传统240V/336V HVDC场景中常采用IGBT或者SiC,而随着电压等级提升至800V,使用宽禁带半导体(如SiC、GaN)能够在更高的开关频率下,实现 最佳效率和更高的功率密度以降低损耗与体积,成为AIPSU的理想选择

800V HVDC 架构中,电压等级升高带来电流减半与线路损耗按平方下降,但要真正把效率、功率密度 与可靠性做上去,核心在于功率器件的材料与器件物理。SiC与GaN具备更高的禁带宽度、更高的击穿场 强、更低的比导通电阻与更优的高频特性,因而SiC/GaN在高压整流、直流母线与隔离降压等环节显著降低损 耗、 缩小体积并提升系统可用度

SiC与GaN等宽禁带半导体器件可用于多个环节并发挥降低损耗、提升安全、缩小体积等优势。

1)整流与一次侧变换:在“13.8 kV AC→800 V DC”的集中整流、PFC/LLC 一次侧与高压DC-DC 中,SiC MOSFET/模块以低开关与导通损耗、良好热性能支撑高效率与高可靠运行,适配行级/机架级母线与配电。该环节是降低链路损耗与铜耗的关键。

2)机架内隔离降压与负载侧:GaN HEMT 在800→12/48/50 V 的DC-DC、中间总线与POL 中凭借高频软开关与低损耗,显著缩小磁性件与电容体积,提升功率密度与瞬态响应,满足GPU/CPU 高动态负载需求。

3)固态变压器与中压直转:SST(固态变压器)作为中压到800 V DC 的关键环节,采用大量SiC(含6500/3300/2300/1200/650 V 等规格)以实现高效率、高频化与模块化,是未来设施级配电的重要方向

由此可见,宽禁带半导体SiC与GaN器件将在大功率PSU模块中起到重要作用。

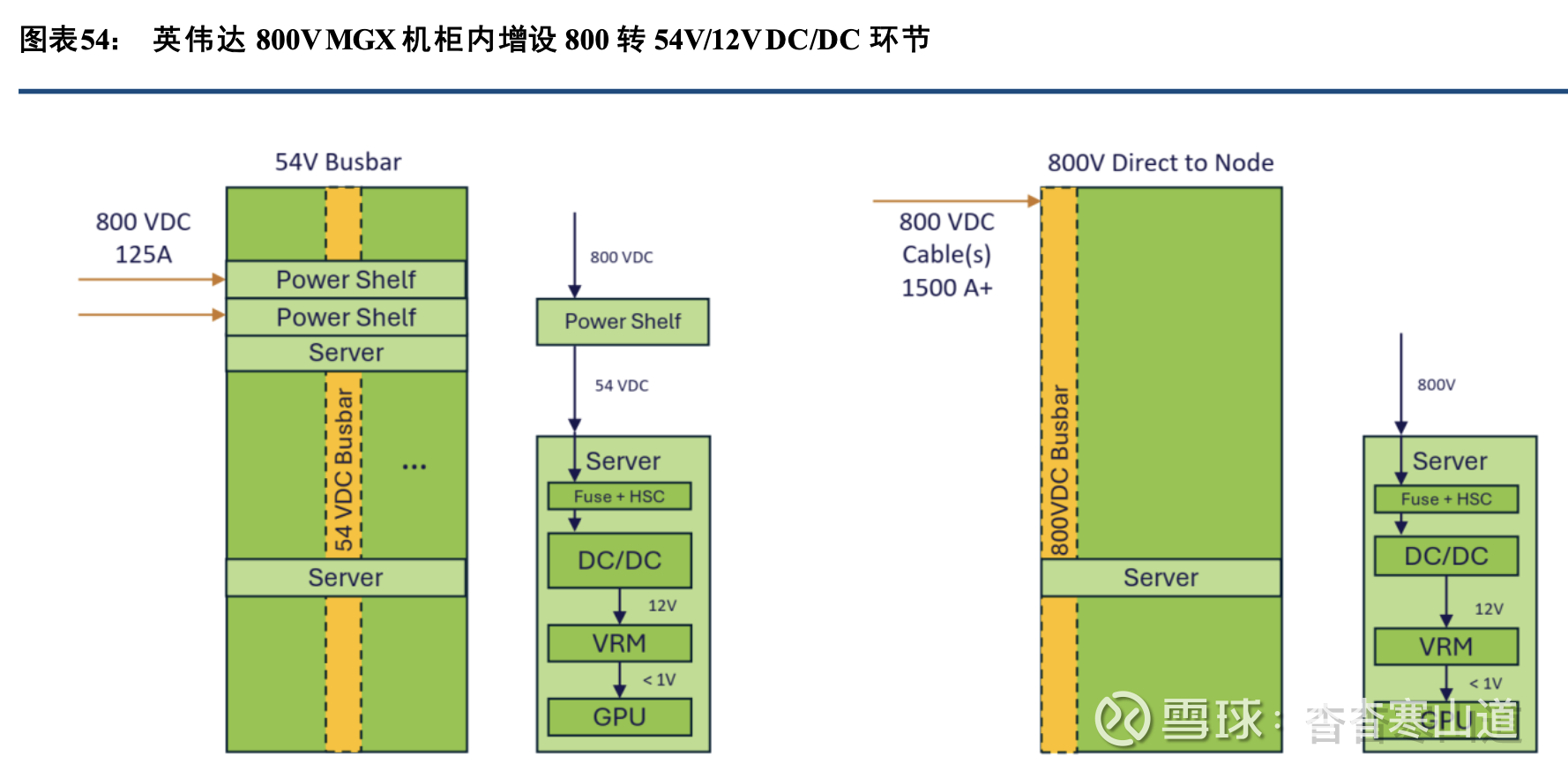

HVDC高压直流输出使得机柜级DC/DC环节成为必需

采用HVDC后,尤其是采用边柜(sidecar)形式的HVDC后,执行AC/DC转换的PSU从计算机柜被 移出至HVDC sidecar中,计算机柜内不再含AC/DC环节。但HVDC输出的800V/±400V直流电入柜后,计算 卡无法直接利用这么高的电压,需增设800V/±400V转50V/12V的DC/DC环节,安装在原先属于PSU的 机柜 内部空间中

在英伟达800V白皮书中,为了减少转换层级和接插件的使用,英伟达建议将DC/DC环节置于尽可能 接近GPU的位置,并将HVDC输出的800V直流一步直降12V直流,供GPU周边的VRM使用。通过使用64:1变比的LLC转换器和矩阵变压器,800V直流电可被一步降压至12V直流,这样就省去了800V降50V和50V降12V的环节,可提升转换效率达1个百分点,并节省GPU周边26%的空间.

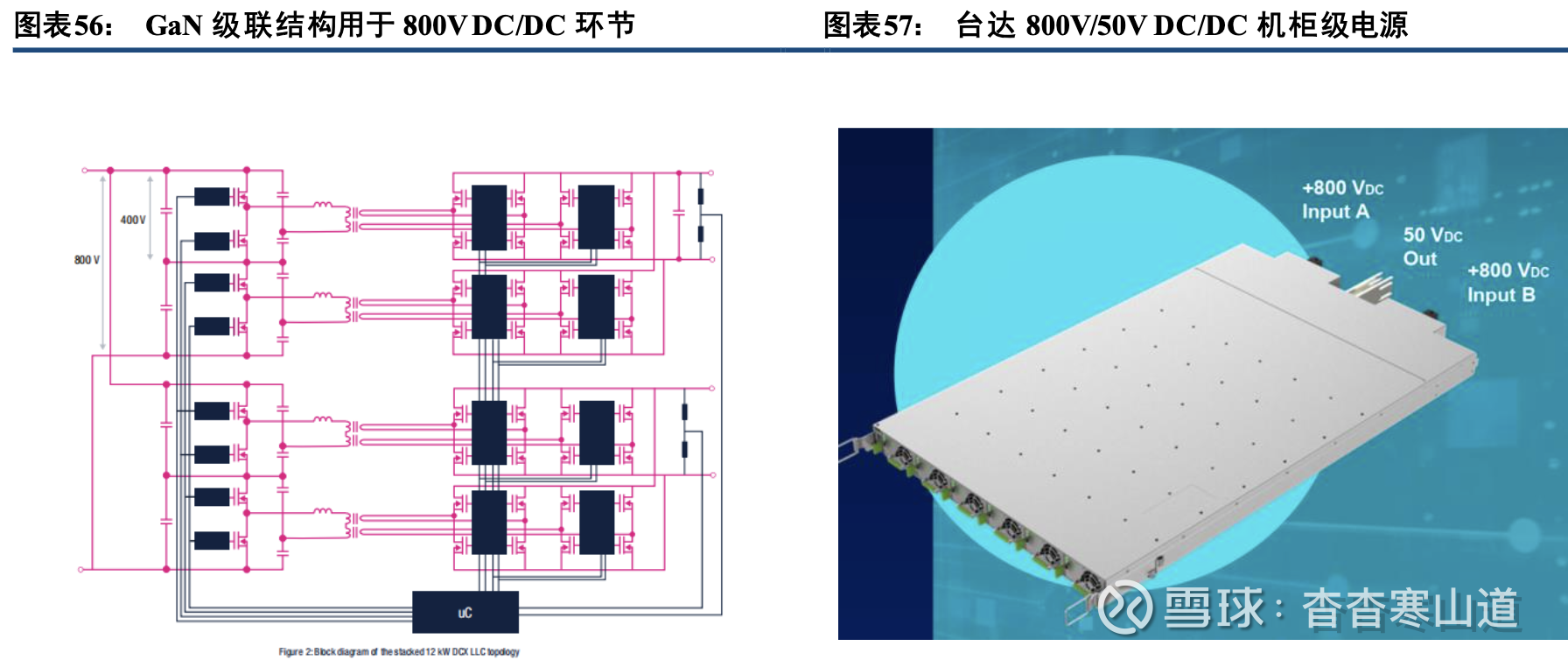

对于800V-50V DC/DC环节,GaN器件已经是实现高密度转换器方案的首选。可以采用GaN器件的级 联三相式LLC拓扑结构,通过1MHz以上的开关频率,进一步缩小变压器及周边元器件尺寸;同时级联结 构输 入端由两个LLC转换器串联,每个由400V电源供电(占800V母线电压的一半),在输出端并联,从而降低Ga N器件的耐压要求,并提升电流输出能力。纳微半导体在最近发布的白皮书中,也展示了一款10kW 800 VDC-50 VDC参考设计,在61毫米×116毫米×12毫米尺寸内将800V直流转换为50V直流,效率可达98%

台达也已推出了机架级的800V DC/DC转换器,单个1U厚度的器件可实现108kW的输出功率,由6个18kW模块组成。

3.3、三次电源:板卡电源垂直布局成为趋势

VRM(Voltage Regulator Module,电压调节模块)是所有高性能计算板卡(如GPU、CPU 板卡)上的核心供电组件,其作用是将板级的中压直流电(如TPU 机柜中的48V)精准转换为芯片核心所需的低压 大电 流直流电(如0.8–1.2V),同时保证电压稳定性和瞬态响应速度。其安装位置多位于板卡上,直接围绕在芯 片周 边,因为位置在一次、二次电源之后,因此被称为三次电源。

在英伟达GB200、GB300中,芯片被安装在Bianca板上,单块Bianca板集成2颗B200 GPU + 1颗Grace CPU。Bianca板上一颗GPU由24-32个VRM模块并联供电,一颗CPU则由16-20个VRM模块并联供电。

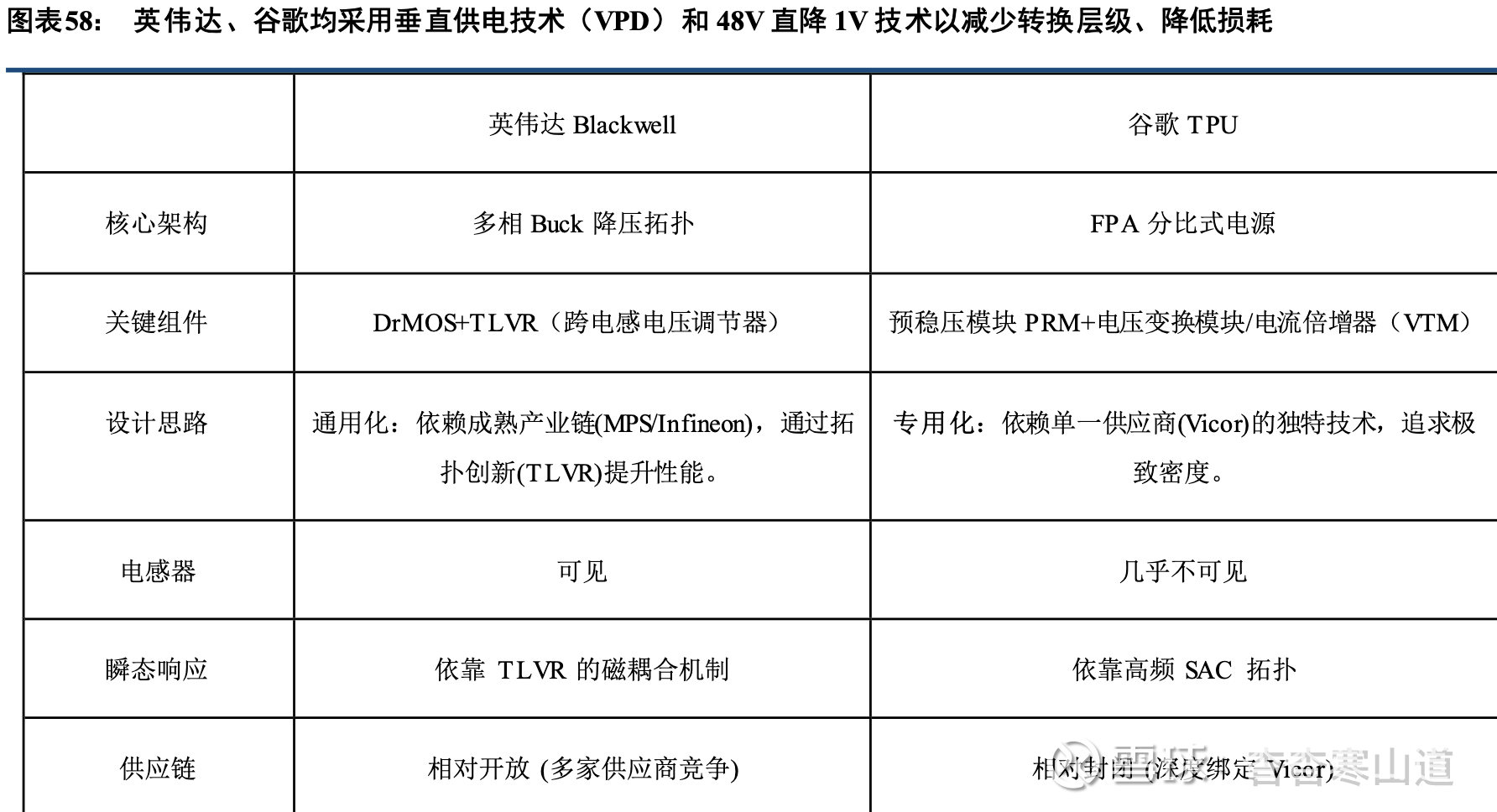

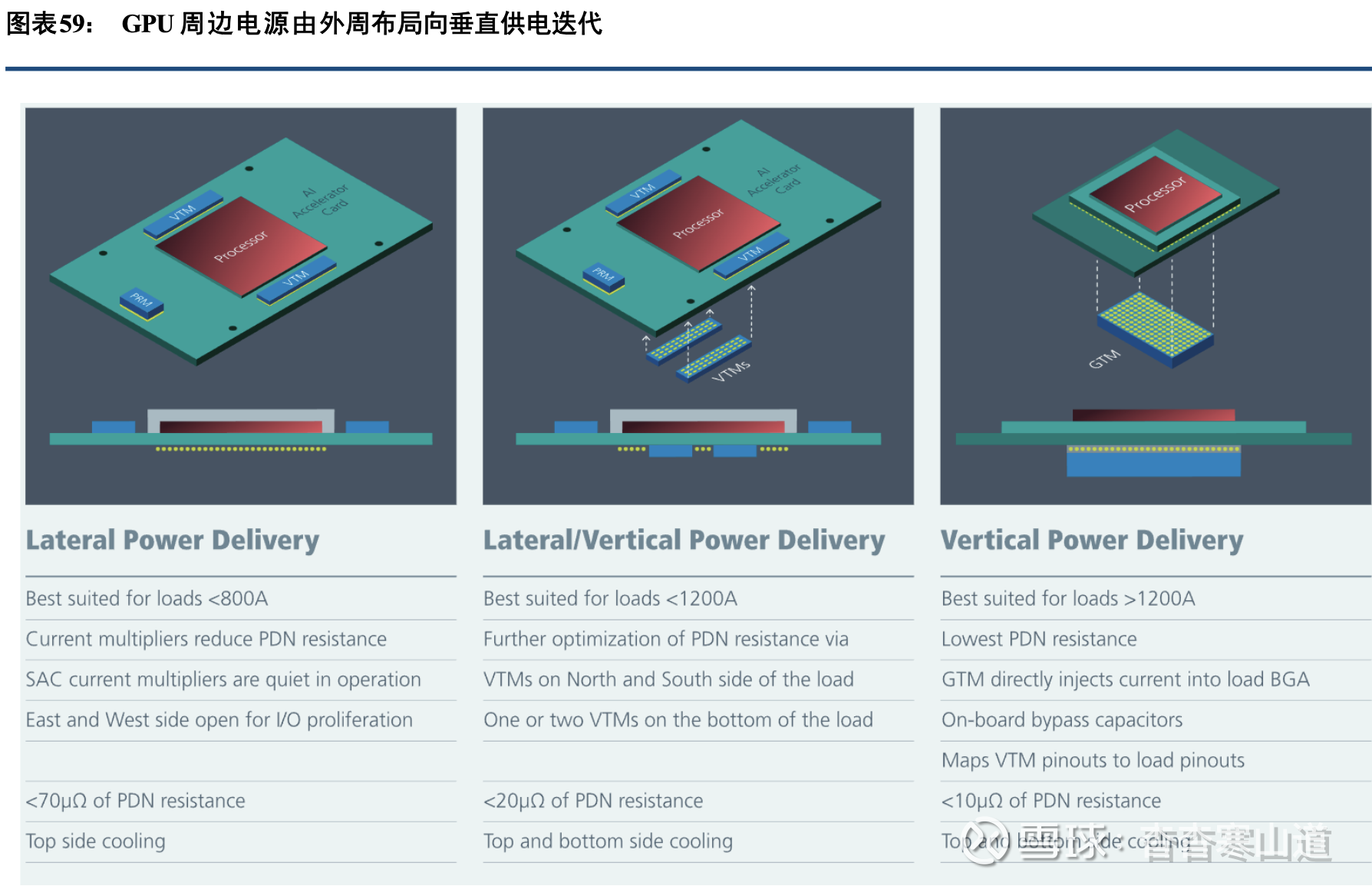

从B200开始,板卡上的VRM开始采用垂直供电技术(VPD),因为芯片面积巨大,如果电流从侧面进 入,阻抗太大会导致严重的电压跌落。针对这一问题,B200的Bianca板上VRM不再位于GPU四周,而 是直 接安装在GPU正下方的PCB背面,电流直接穿过PCB的过孔垂直向上注入GPU核心,供电路径长度大 大缩 短,并且节省了GPU正面空间用于布置HBM显存和NVLink连接器。同时,为了减少转换层级,Bianca板 上的VRM采用了48V直降0.7V的技术,主要由MPS、英飞凌和Vicor提供方案

谷歌TPU芯片的三次电源方案与英伟达不同,采用FPA架构(主要由Vicor提供),采用预稳压模块(PRM)和电压变换模块(VTM)结合,前者输出一个稳定的、受控的电压,但不进行大幅度的降压;后者为 电压 变换模块/电流倍增器(VTM)放置在极度靠近TPU芯片的地方,不负责稳压,只负责按照固定比例变压,如 将48V直流变成1V,同时电流放大48倍。同时工作在MHz级别的极高频率、采用软开关技术降低开关损耗,使 得谷歌的VTM模块体积极小,响应速度极快,可以像积木一样堆叠在TPU旁边。并且谷歌比英伟达更早 大规 模应用垂直供电(VPD)理念

3.4、附属环节:CBU、BBU、固态断路器、熔断器等

CBU:提高柜内电能质量的必选设备

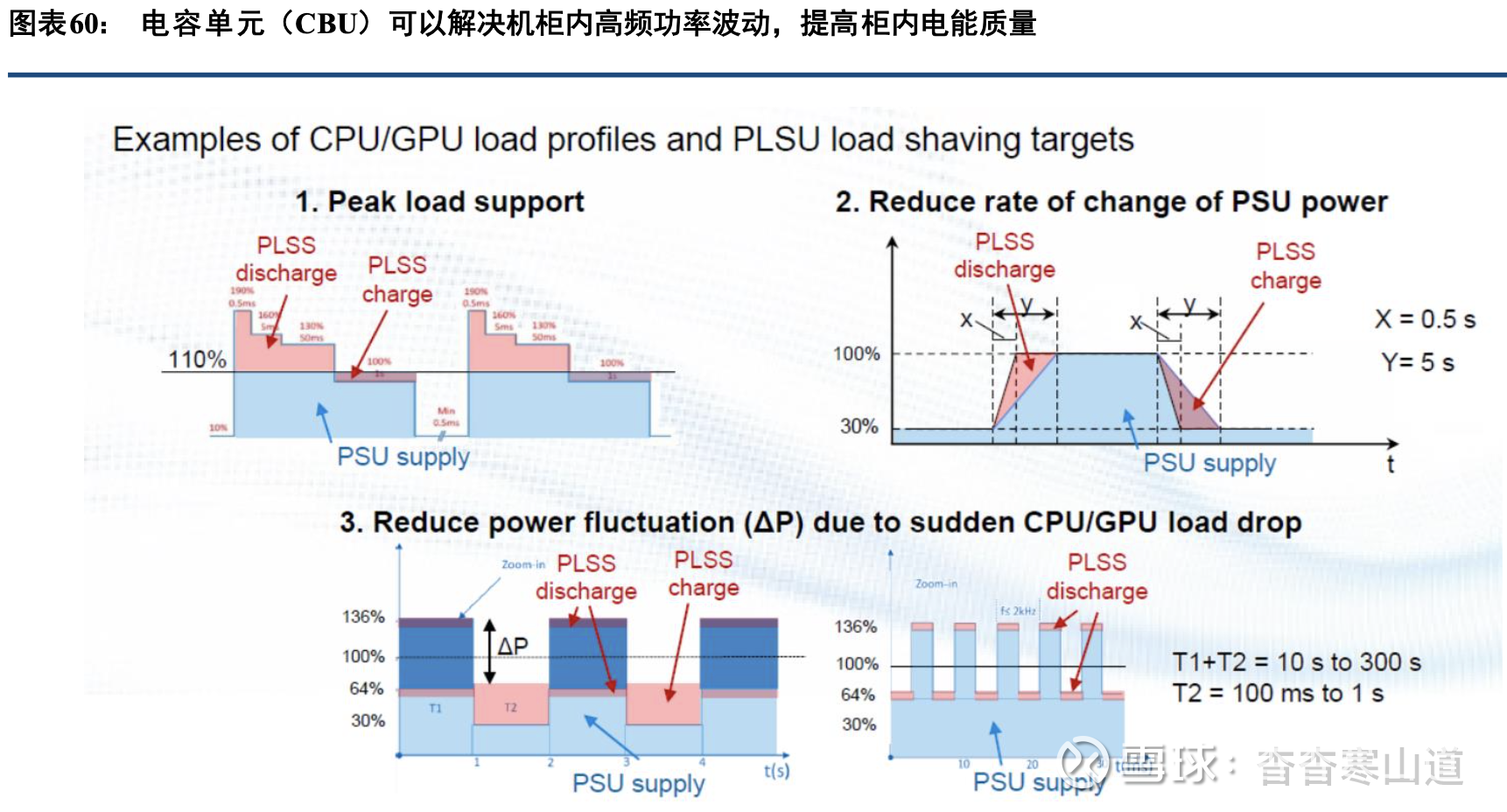

在800V HVDC系统中,典型GPU负荷波动周期可短至100ms,持续1-5s,然后几分钟后进入下一循 环。针对数据中心负荷波动的不同周期,英伟达提出了两级储能概念:①电容储能置于机柜内部,以解决100ms以下的波动为主;②电站级储能置于数据中心并网点,可以解决10s及以上周期的波动。

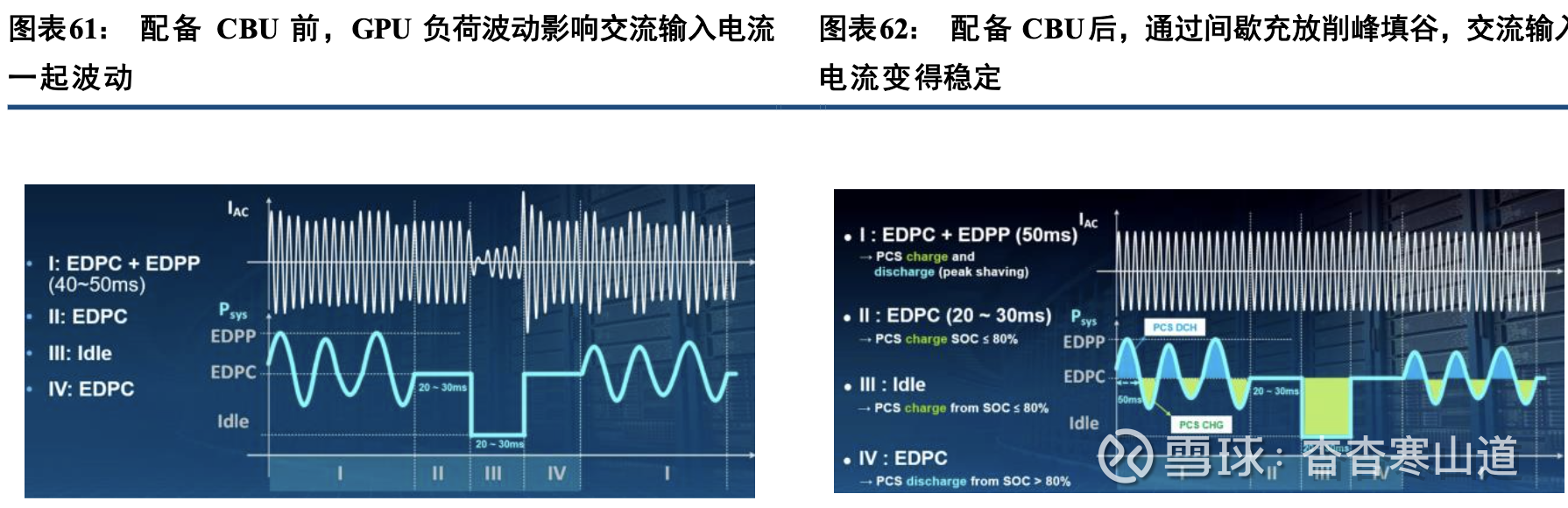

电容备份单元(Capacitor BackupUnit,CBU)是用于提高机柜内部电能质量的设备,可以快速充放电 ,用于解决数千Hz频率的GPU/CPU负载波动和PSU输出功率波动的问题。用于:(1)顶峰支撑;(2)降低PSU输出功率的变化率;(3)降低CPU/GPU的突然性负载波动

配备CBU后,通过CBU间歇性充放电(时间间隔在数十ms量级),可以有效平抑GPU负荷波动带 来的输入电流波动,从而减轻PSU的工作负担,并提高整个机柜的电能质量

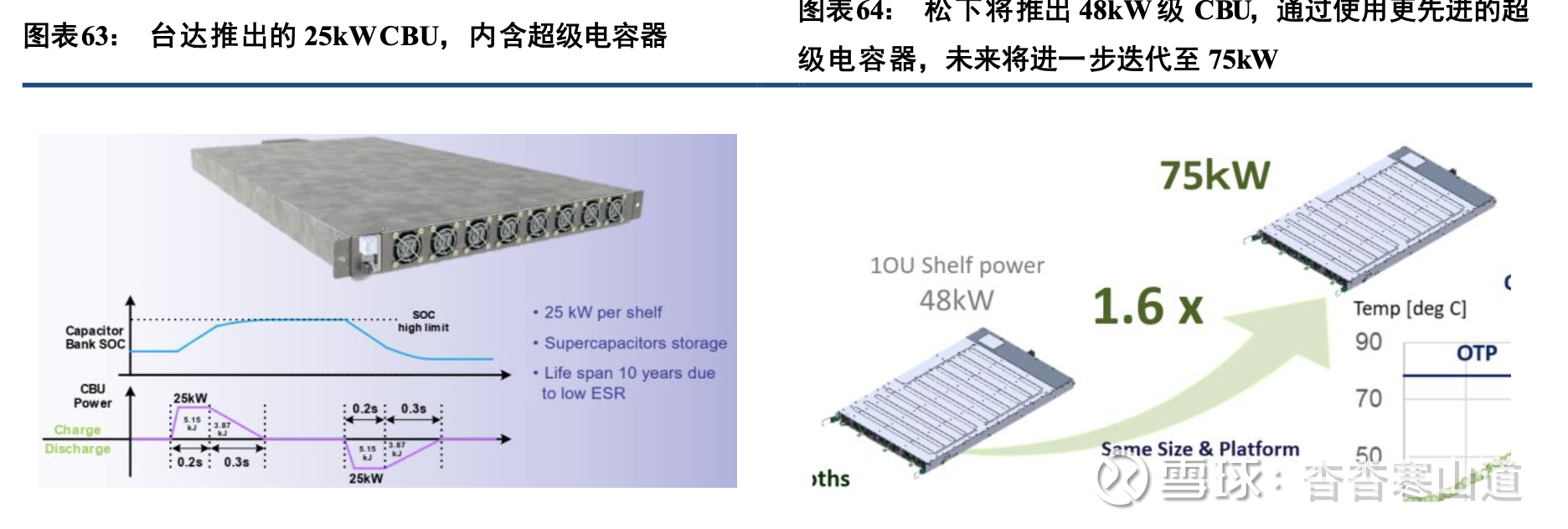

目前,推出CBU较为成熟产品的是台达和松下,台达已推出单体25kW的CBU shelf,目前松下的CBU shelf单体功率也在25-26kW量级。未来,2025年松下将推出48kW级CBU shelf,后续将进一步迭代至75kW

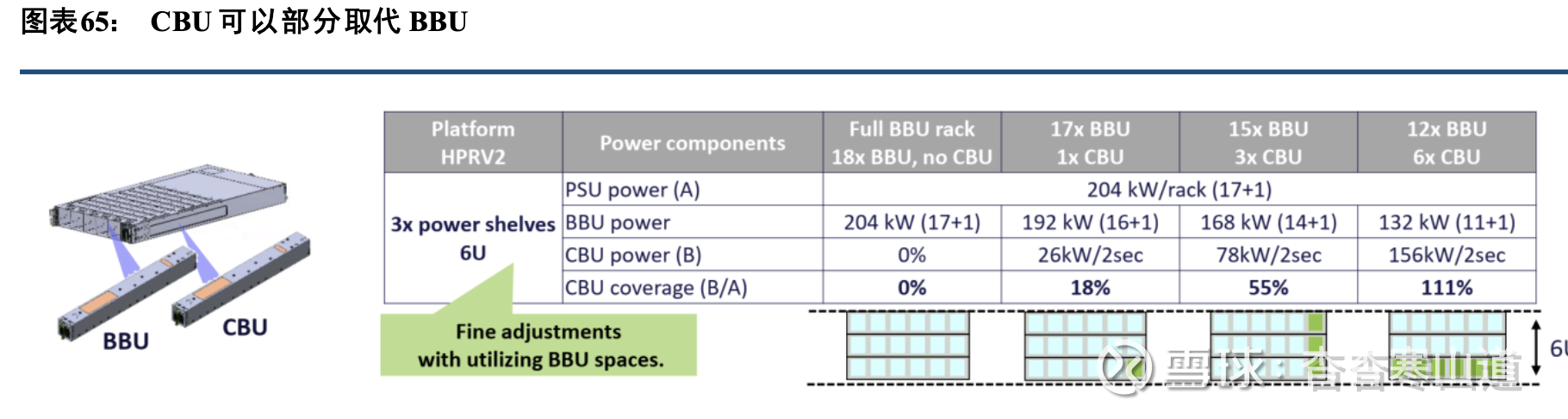

从用量来看,CBU/BBU(Battery Backup Unit,电池备份单元)的功率输出应至少等于PSU的电源功 率输出,同时在机柜中,CBU可以部分取代BBU的备电功能,两者可以互换使用,,如一个符合HPR V2标准的机柜,其电源(PSU)输出功率为204kW(每个PSU12kW,17个PSU+1个冗余),正常情况下也应配备18个输出功率为12kW的BBU单元,但在实际应用中可以用CBU部分取代BBU,如下图中,最多可以用6个CBU取代6个BBU,形成12个BBU+6个CBU的组合

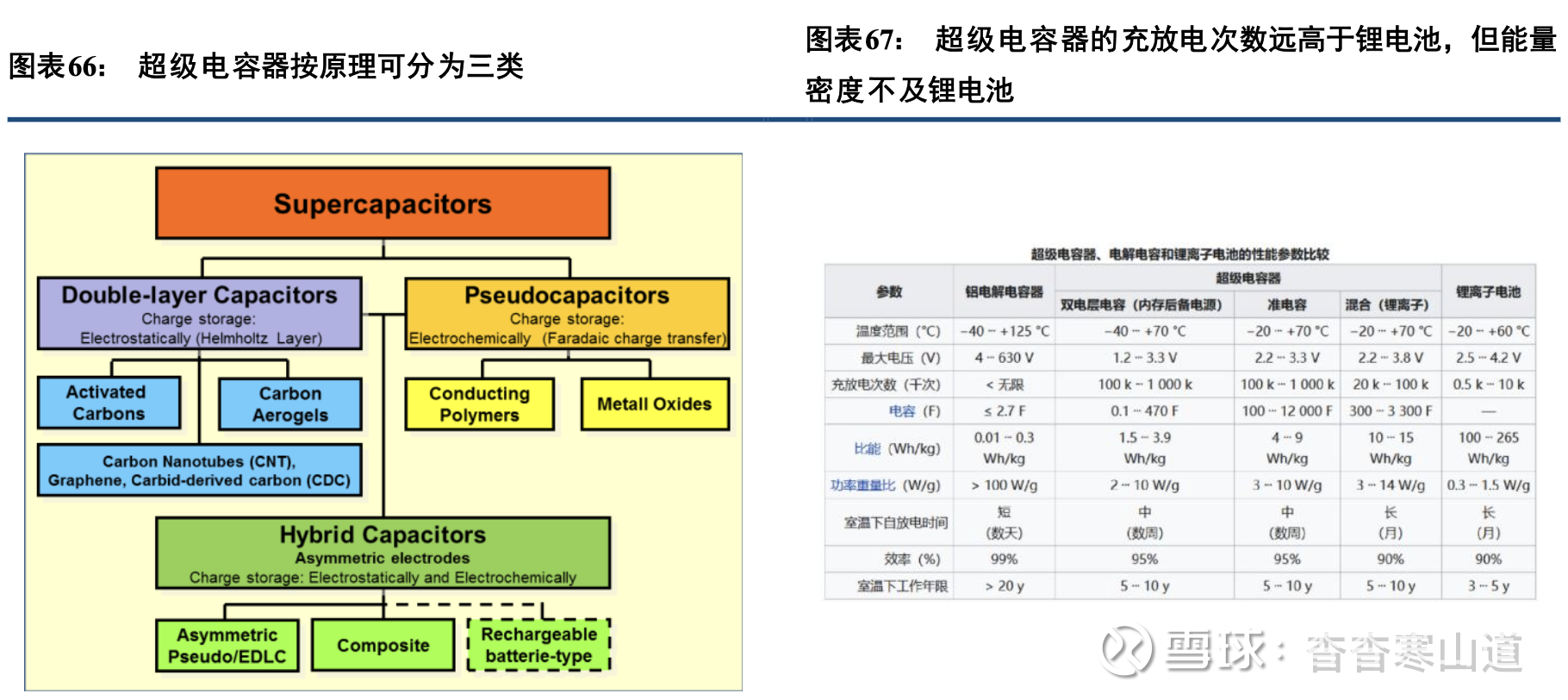

CBU内部的核心零部件为超级电容器,是拥有高能量密度的电化学电容器,比传统的电解电容容量高 上数百倍至千倍不等,其容量和性能介于电解电容和蓄电池之间。超级电容的吞吐速度可比电池快得多, 充放 电周期也远多于蓄电池。但超级电容器也有缺点,除成本高于主流电池,在性能方面它还面临着峰值功率密 度低(最高30 kw/kg)、能量密度低(约10 wh/kg)、工作电压低(小于3V)的挑战,核心原因在于其电极材 料和 电解质无法承载高压。

超级电容器按其储能原理可分为三类:其一为静电双层电容器(EDLC),其储能原理在于电极表面与 电解质界面形成亥姆霍兹双电层,通过电荷分离实现能量存储;其二为电化学赝电容器,电极材料多选用 金属 氧化物或导电聚合物,通过氧化还原反应、离子嵌入或电化学吸附等电化学反应实现;其三为混合型电容 器, 其结构包含两种特性迥异的电极:一个主要呈现静电电容特性,另一个则主要表现为电化学电容特性,从 而综 合两种储能机制的优势。

目前,国内企业江海股份、中天超容已实现EDLC成熟量产,循环寿命达30 万次以上,宽温范围-30°C~+75°C,适配工业与电网场景。上海奥威新一代混合超容能量密度达140Wh/kg,居国际领先。思源 电气2017 年增资烯晶碳能,掌握干法电极、单体/ 模组核心技术,整合超容、锂电、混合超容,推出600Ah + 大电芯兼容平台,适配发电/ 电网/ 用户侧全场景,2025 年获车企定点,实现汽车电子量产配套。推出EDLC 超级电容单体,具备高功率密度,适配电网调频、SSC 静止同步调相机等毫秒级响应场景。思源电气还推 出HUC 混合超级电容模组:融合EDLC 与LIC 优势,兼顾能量密度与循环寿命,用于储能调频、AIDC 备用电源、车载电源等。