从CPU到TPU,算力芯片的分工与AI硬件的下一个落点

在人工智能与数据中心“军备竞赛”中,算力已经成为核心生产要素。CPU、GPU、NPU、TPU是不同类型的计算芯片,它们的本质区别在于通用性与专用性——CPU是全能型“指挥官”,而GPU、NPU、TPU则是针对特定任务的“特种兵”。它们协同作用,构成了现代AI算力体系的底层支撑。

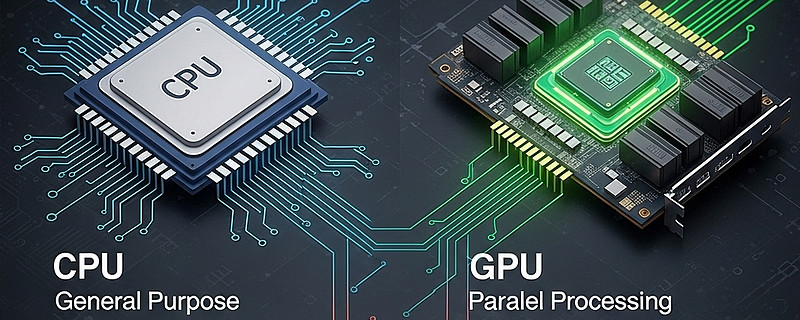

CPU(中央处理器)核心数较少,设计上偏通用计算,是执行操作系统与通用应用的“大脑”,在NAS等设备中也负责调度核心任务。

GPU(图形处理器)具有大量并行计算单元,除了渲染3D图形,也是深度学习、大规模数据分析的重要引擎。

NPU(神经网络处理单元)专为AI加速设计,在人脸识别、图像生成等场景下具备高效与低功耗优势。

TPU(张量处理单元)则是Google为机器学习推理与训练场景定制的处理器,在神经网络推理效率上是CPU/GPU的数十倍,但产量有限、价格昂贵。

以QNAP NAS为例,不同类型加速芯片可以直接影响产品能力:

内建GPU可显著提升视频转码速度、虚拟机图形性能;

内建NPU可加速QuMagie图片识别、QVR人脸识别等AI应用;

Edge TPU适合在安防、零售等需要实时人脸识别与多路视频分析的场景减轻CPU压力,功耗仅0.5W即可达到4TOPS性能。

对产业链而言,不同加速芯片的普及正在重塑AI基础设施。从高端GPU市场的英伟达,到边缘AI加速的寒武纪、地平线,再到提供专用AI推理芯片方案的谷歌、云端厂商,这背后对光模块、高速互连、PCB、存储等环节的需求都在快速放大。从投资角度看,硬件迭代周期、应用场景扩展,以及边缘端AI渗透率提升,都是未来几年确定性较强的成长方向。

算力芯片的竞争,不仅仅是硬件比拼,更是生态之争。谁能率先在不同应用场景建立稳定的技术与产业链接,将在下一阶段的AI浪潮中占据制高点。

免责声明:本文仅作市场资讯分享,不构成任何投资建议。股市有风险,投资需谨慎,请结合自身情况独立判断与决策。