液冷服务器+数据中心:中报预增的6家公司

兰板套利

· 江苏

AI 浪潮下的液冷与数据中心变革

近年来,AI 技术呈爆发式发展,从最初的语音识别、图像识别,到如今的大语言模型、生成式 AI,其应用领域不断拓展,深入到人们生活和工作的方方面面 。AI 的快速发展离不开强大算力的支持,随着 AI 模型的参数规模不断扩大,对算力的需求呈指数级增长。例如,GPT-3 拥有 1750 亿个参数,训练这样的大模型需要消耗海量的计算资源,传统的计算设备和散热方式难以满足其需求。

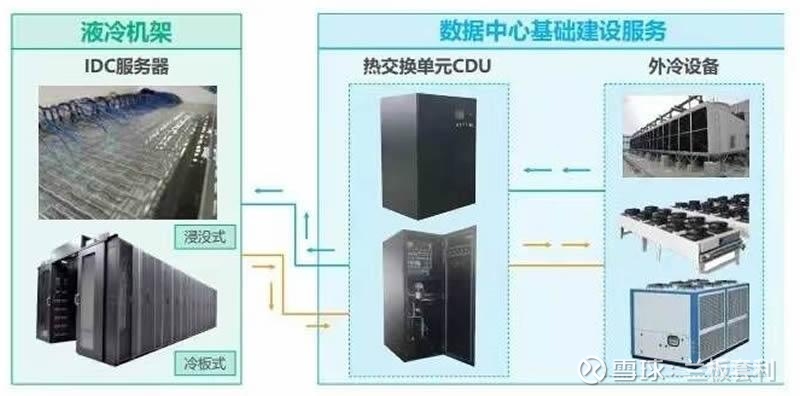

在这样的背景下,液冷服务器和数据中心成为了应对算力挑战的关键。液冷服务器通过液体作为冷却介质,能够更高效地将服务器产生的热量带走,相比传统风冷服务器,其散热效率大幅提升,可有效保障服务器在高负载下稳定运行。数据中心则是算力的集中承载平台,通过整合大量服务器和存储设备,为 AI 应用提供所需的计算和存储资源。

液冷服务器与数据中心的协同发展,是当前满足 AI 算力需求的重要趋势。一方面,液冷服务

点击查看全文